LLM Local Personalizado: Ajuste fino de LLM con Llama-Factory en Jetson

Introducción

🚀¡Ajuste fino de LLM con Llama-Factory en Jetson! Ahora puedes personalizar un LLM local privado para satisfacer tus requisitos.

Llama-Factory proporciona una herramienta de ajuste fino de modelos de lenguaje grandes altamente conveniente que soporta modelos de lenguaje grandes comunes, conjuntos de datos y métodos de ajuste fino. Con esta plataforma, podemos personalizar fácilmente modelos de lenguaje grandes privados.

En este wiki, aprenderemos cómo desplegar Llama-Factory en Nvidia Jetson y usar Llama-Factory para entrenar un modelo de lenguaje grande que soporte preguntas y respuestas en chino.

Prerrequisitos

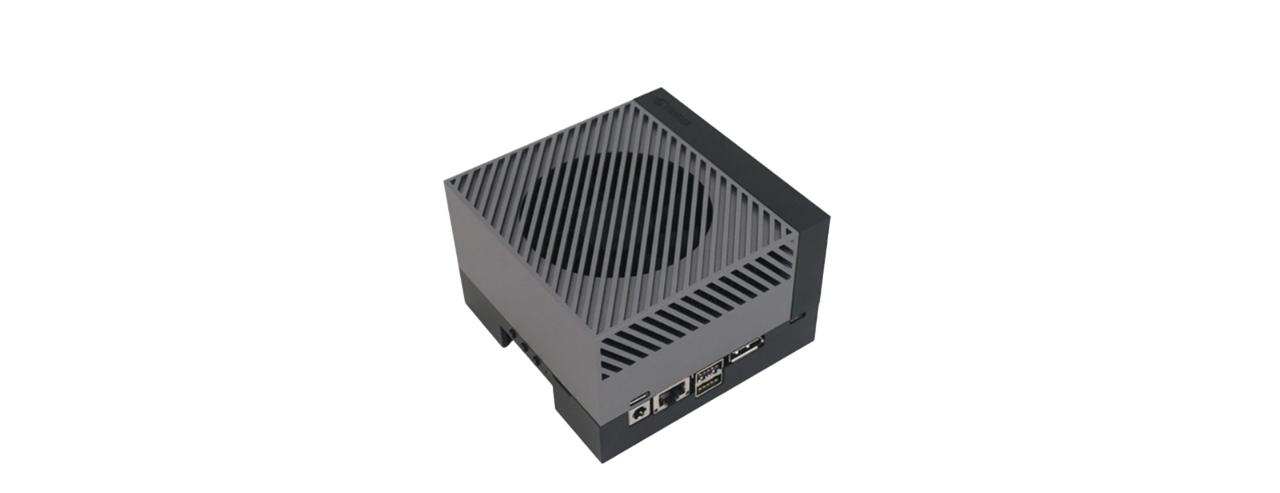

- Dispositivo Jetson con más de 16GB de memoria.

- Monitor, ratón, teclado y red. (no necesario)

Ya hemos probado la viabilidad de este wiki en reComputer Orin NX 16GB y AGX Orin 64GB Developer Kit.

Comenzando

Conexión de Hardware

- Conecta el cable Ethernet al reComputer (Alimentado por Jetson).

- Conecta el ratón, teclado y monitor al reComputer.

- Enciende el reComputer.

Instalar Jetson-Examples

Los jetson-examples de Seeed Studio ofrecen un despliegue sin problemas con un comando de una línea para ejecutar modelos de IA de visión e IA Generativa en la plataforma NVIDIA Jetson.

Para instalar el paquete, por favor abre la terminal en Jetson y ejecuta:

pip3 install jetson-examples

sudo reboot

Instalar y Ejecutar Llama-Factory en Jetson

Despliega Llama-Factory con jetson-examples en una línea:

reComputer run llama-factory

Luego podemos abrir un navegador web y acceder a la dirección para abrir la WebUI:

# http://<jetson-ip>:7860

http://127.0.0.1:7860

Iniciar Entrenamiento

Aquí, usamos el conjunto de datos alpaca_zh para hacer ajuste fino del modelo Phi-1.5, permitiéndole tener capacidades conversacionales en chino. Por lo tanto, en la interfaz web, solo configuramos el Model name de entrenamiento y Dataset, manteniendo los otros parámetros de entrenamiento como predeterminados.

Finalmente, haz clic en el botón start para iniciar el entrenamiento.

El proceso de entrenamiento tomará aproximadamente 18 horas.

Después de completar el ajuste fino, puedes encontrar el modelo ajustado en el directorio de guardado.

Probando el Modelo con Ajuste Fino.

Finalmente, podemos usar Llama-Factory con el modelo ajustado para probar si efectivamente ha adquirido capacidades conversacionales en chino. Los pasos específicos son los siguientes.

Paso1. Cargar el modelo con ajuste fino mediante la WebUI de Llama-Factory.

Paso2. Ingresa un prompt en chino en el cuadro de texto Input, haz clic en el botón Submit, y verifica el resultado de salida del modelo de lenguaje grande en el cuadro de texto Chatbot.

De los resultados de la prueba, podemos ver que el modelo con ajuste fino ya tiene la capacidad de conversar con humanos en chino. Si quieres que tu modelo tenga capacidades más avanzadas, ¡intenta usar un conjunto más diverso de datos de ajuste fino para entrenar tu modelo!

Demostración

Referencias

- https://github.com/hiyouga/LLaMA-Factory

- https://github.com/dusty-nv/jetson-containers

- https://github.com/Seeed-Projects/jetson-examples

Soporte Técnico y Discusión de Productos

¡Gracias por elegir nuestros productos! Estamos aquí para brindarte diferentes tipos de soporte para asegurar que tu experiencia con nuestros productos sea lo más fluida posible. Ofrecemos varios canales de comunicación para atender diferentes preferencias y necesidades.