Instalar Pytorch para reComputer Jetson

Este wiki demuestra cómo instalar PyTorch optimizado por NVIDIA en tu reComputer, coincidiendo con tu versión de JetPack. También cubre cómo usar entornos virtuales (conda) para gestionar múltiples versiones de PyTorch para desarrollo y despliegue.

Prerrequisitos

- reComputer con JetPack instalado

- Conexión a Internet

Instalar PyTorch para reComputer

Aquí, introduciremos cómo instalar PyTorch con soporte CUDA en las dos versiones comúnmente utilizadas de Jetpack 5 y Jetpack 6.

- JP5.1.3

- JP6.2

- Otra Versión

En reComputer, la versión comúnmente utilizada de Jetpack 5 es 5.1.3. Aquí, la usaremos para introducir cómo instalar PyTorch.

Paso 1. Actualizar el sistema e instalar dependencias:

sudo apt-get -y update

sudo apt-get install -y python3-pip libopenblas-dev

Paso 2. Descargar el wheel oficial de PyTorch (ejemplo: torch-2.1.0 para JetPack 5.1.3, Python 3.8):

wget https://developer.download.nvidia.com/compute/redist/jp/v512/pytorch/torch-2.1.0a0+41361538.nv23.06-cp38-cp38-linux_aarch64.whl

pip install torch-2.1.0a0+41361538.nv23.06-cp38-cp38-linux_aarch64.whl

Si necesitas una versión más reciente de torch que soporte Jetpack 5.1.3, por favor descarga el archivo wheel compilado desde aquí (torch-2.2 para python3.8).

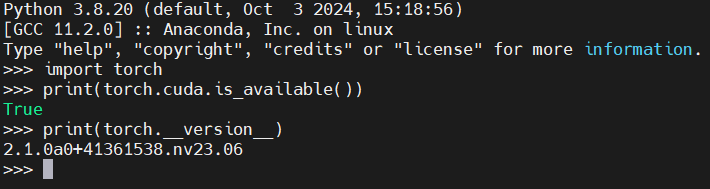

Paso 3. Verificar la instalación:

import torch

print(torch.cuda.is_available())

print(torch.__version__)

En reComputer, la versión comúnmente utilizada de Jetpack 6 es 6.2. Aquí, la usaremos para introducir cómo instalar PyTorch.

Paso 1. Actualizar el sistema e instalar dependencias:

sudo apt-get -y update

sudo apt-get install -y python3-pip libopenblas-dev

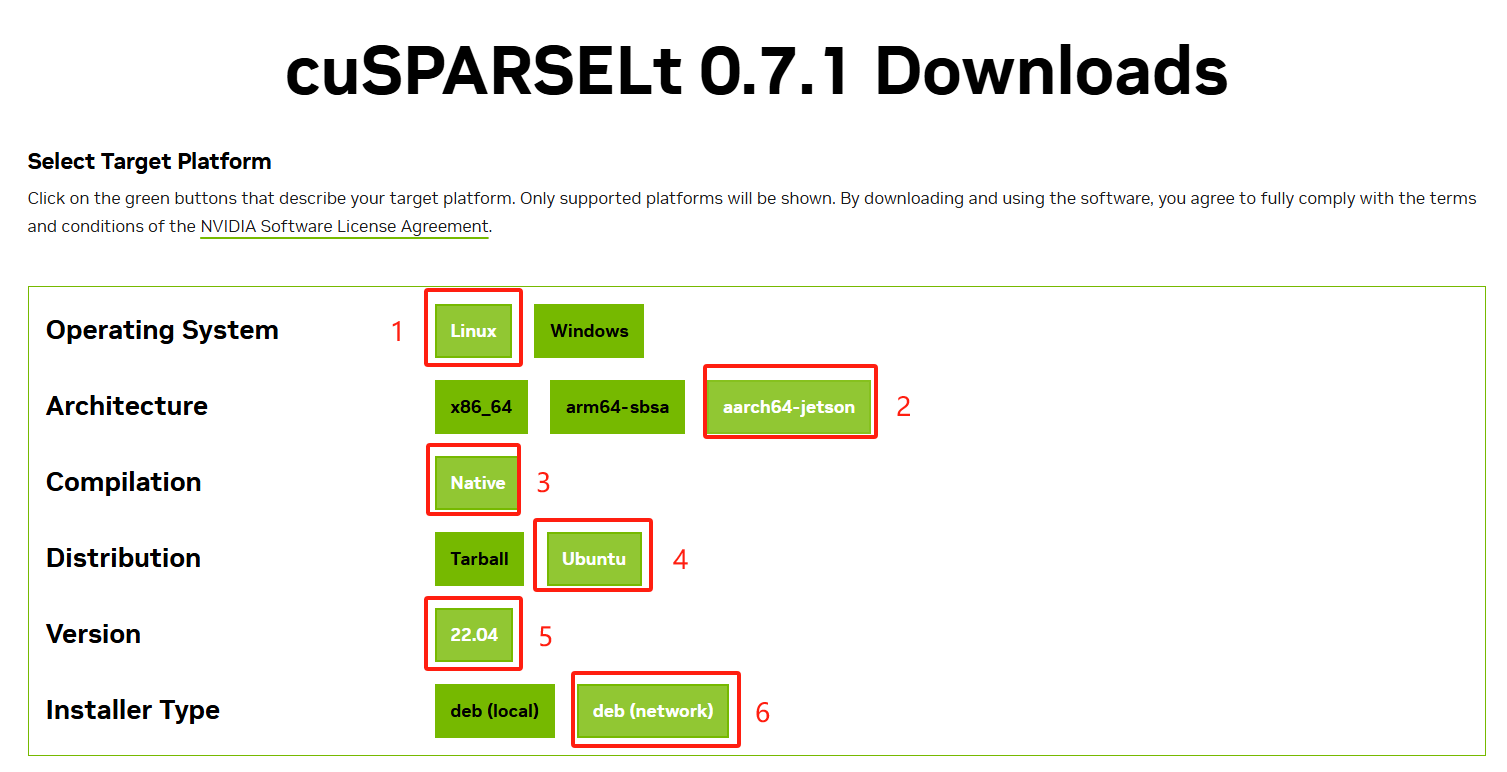

Paso 2. Instalar cuSPARSELt desde aquí (requerido para PyTorch 24.06+):

cuSPARSELt es una biblioteca CUDA de alto rendimiento desarrollada por NVIDIA específicamente para multiplicación de matrices dispersas. Se utiliza principalmente para acelerar operaciones de multiplicación de matrices bajo pesos dispersos, que se ven comúnmente en inferencia de modelos grandes y redes neuronales dispersas. En la nueva versión de PyTorch(PyTorch 24.06+), llamará automáticamente a cusparselt para mejorar la velocidad de inferencia de modelos dispersos, especialmente en GPUs embebidas como Jetson, lo que puede mejorar significativamente la eficiencia.

Paso 3. Según la versión seleccionada como se muestra en la figura anterior, obtendrás el siguiente comando de instalación:

wget https://developer.download.nvidia.com/compute/cusparselt/0.7.1/local_installers/cusparselt-local-tegra-repo-ubuntu2204-0.7.1_1.0-1_arm64.deb

sudo dpkg -i cusparselt-local-tegra-repo-ubuntu2204-0.7.1_1.0-1_arm64.deb

sudo cp /var/cusparselt-local-tegra-repo-ubuntu2204-0.7.1/cusparselt-*-keyring.gpg /usr/share/keyrings/

sudo apt-get update

sudo apt-get -y install libcusparselt0 libcusparselt-dev

Paso 4. Descargar e instalar PyTorch (ejemplo: torch-2.5.0 para JetPack 6.2, Python 3.10):

wget https://developer.download.nvidia.cn/compute/redist/jp/v61/pytorch/torch-2.5.0a0+872d972e41.nv24.08.17622132-cp310-cp310-linux_aarch64.whl

pip install torch-2.5.0a0+872d972e41.nv24.08.17622132-cp310-cp310-linux_aarch64.whl

Si necesitas una versión más reciente de torch que soporte Jetpack 6.2, por favor descarga el archivo wheel compilado desde aquí (torch-2.7 para python3.10).

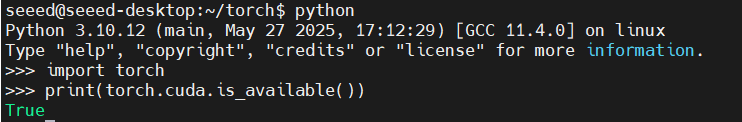

Paso 5. Verificar la instalación:

import torch

print(torch.cuda.is_available())

Paso 1. Actualizar el sistema e instalar dependencias:

sudo apt-get -y update

sudo apt-get install -y python3-pip libopenblas-dev

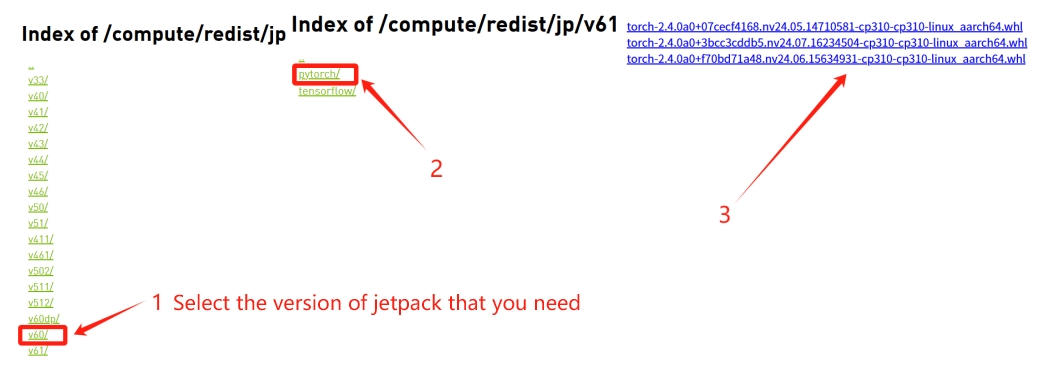

Aquí está el archivo wheel compilado oficialmente de PyTorch con soporte CUDA proporcionado por NVIDIA.

Paso 2. Descargar el archivo wheel apropiado basado en tu versión de JetPack y versión de Python.

# Descargar el archivo wheel

wget https://developer.download.nvidia.cn/compute/redist/jp/v60/pytorch/torch-2.4.0a0+f70bd71a48.nv24.06.15634931-cp310-cp310-linux_aarch64.whl

# Instalar el archivo wheel

pip install torch-2.4.0a0+f70bd71a48.nv24.06.15634931-cp310-cp310-linux_aarch64.whl

Paso 3. Verificar la instalación:

import torch

print(torch.cuda.is_available())

Múltiples Versiones de PyTorch con Conda

Miniconda es un instalador ligero para el gestor de paquetes Conda, proporcionando un entorno mínimo para crear y gestionar rápidamente entornos de Python y paquetes.

Paso 1. Instalar Miniconda:

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-aarch64.sh

bash Miniconda3-latest-Linux-aarch64.sh

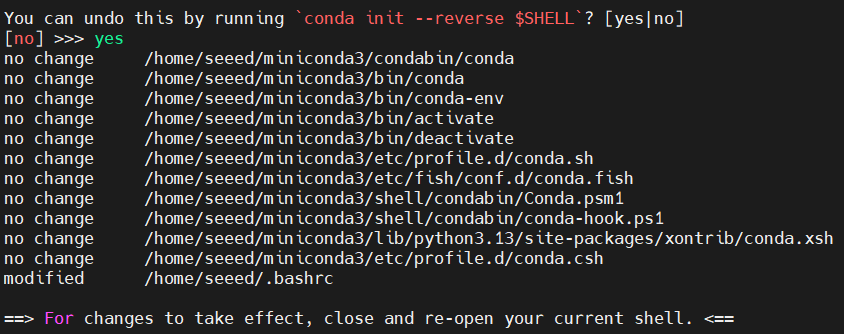

- Sigue las instrucciones e ingresa "yes" para aceptar los términos.

- Se recomienda usar la configuración predeterminada para la ruta de instalación, como ~/miniconda3.

- Finalmente, pregunta si agregar automáticamente a .bashrc. Se recomienda ingresar "yes".

Paso 2. Inicializar y configurar conda:

source ~/.bashrc

# Verificar si conda está funcionando correctamente

conda --version

# Deshabilitar la entrada automática al entorno base de conda

conda config --set auto_activate_base false

# Cerrar y reabrir la terminal. Por defecto, no entrará al entorno base.

Paso 3. Crear un nuevo entorno e instalar un wheel específico de PyTorch:

conda create -n torch_2.0 python=3.8

conda activate torch_2.0

Paso 4. Descargar e instalar el archivo wheel de PyTorch como se muestra en las secciones anteriores.

Para más detalles, consulta la guía de instalación de PyTorch de NVIDIA

Recursos

- Foro de Desarrolladores de NVIDIA

- Guía de instalación de PyTorch de NVIDIA

- Notas de Lanzamiento de PyTorch para Jetson

Soporte Técnico y Discusión de Productos

¡Gracias por elegir nuestros productos! Estamos aquí para brindarte diferentes tipos de soporte para asegurar que tu experiencia con nuestros productos sea lo más fluida posible. Ofrecemos varios canales de comunicación para atender diferentes preferencias y necesidades.