Introducción al brazo robótico SO-ARM100 y SO-ARM101 con LeRobot

Introducción

El SO-10xARM es un proyecto de brazo robótico completamente de código abierto lanzado por TheRobotStudio. Incluye el brazo seguidor y el brazo robótico líder, y también proporciona archivos detallados de impresión 3D y guías de operación. LeRobot está comprometido a proporcionar modelos, conjuntos de datos y herramientas para robótica del mundo real en PyTorch. Su objetivo es reducir la barrera de entrada de la robótica, permitiendo que todos contribuyan y se beneficien del intercambio de conjuntos de datos y modelos preentrenados. LeRobot integra metodologías de vanguardia validadas para aplicaciones del mundo real, centrándose en el aprendizaje por imitación. Ha proporcionado un conjunto de modelos preentrenados, conjuntos de datos con demostraciones recopiladas por humanos y entornos de simulación, permitiendo a los usuarios comenzar sin la necesidad de ensamblar robots. En las próximas semanas, la intención es aumentar el soporte para robótica del mundo real en los robots más rentables y competentes actualmente accesibles.

Introducción del Proyecto

El kit de robot inteligente SO-ARM10x y reComputer Jetson AI combina perfectamente el control de brazo robótico de alta precisión con una potente plataforma de computación AI, proporcionando una solución integral de desarrollo de robots. Este kit está basado en la plataforma Jetson Orin o AGX Orin, combinado con el brazo robótico SO-ARM10x y el marco AI LeRobot, ofreciendo a los usuarios un sistema de robot inteligente aplicable a múltiples escenarios como educación, investigación y automatización industrial. Este wiki proporciona el tutorial de ensamblaje y depuración para el SO ARM10x y realiza la recopilación de datos y entrenamiento dentro del marco Lerobot.

Características Principales

- Código abierto y bajo costo: Es una solución de brazo robótico de código abierto y bajo costo de TheRobotStudio

- Integración con LeRobot: Diseñado para integración con plataforma LeRobot

- Abundantes recursos de aprendizaje: Proporciona recursos de aprendizaje de código abierto integrales como guías de ensamblaje y calibración, y tutoriales para pruebas, recopilación de datos, entrenamiento y despliegue para ayudar a los usuarios a comenzar rápidamente y desarrollar aplicaciones robóticas.

- Compatible con Nvidia: Despliega este kit de brazo con reComputer Mini J4012 Orin NX 16 GB.

- Aplicación Multi-Escenario: Es aplicable a campos como educación, investigación científica, producción automatizada y robótica, ayudando a los usuarios a lograr operaciones de robot eficientes y precisas en varias tareas complejas.

Novedades:

- Optimización del cableado: Comparado con SO-ARM100, SO-ARM101 presenta un cableado mejorado que previene problemas de desconexión previamente vistos en la articulación 3. El nuevo diseño de cableado también ya no limita el rango de movimiento de las articulaciones.

- Diferentes relaciones de engranajes para el brazo líder: El brazo líder ahora usa motores con relaciones de engranajes optimizadas, mejorando el rendimiento y eliminando la necesidad de cajas de engranajes externas.

- Soporte de nueva funcionalidad: El brazo líder ahora puede seguir al brazo seguidor en tiempo real, lo cual es crucial para la próxima política de aprendizaje, donde un humano puede intervenir y corregir las acciones del robot.

Seeed Studio solo es responsable de la calidad del hardware en sí. Los tutoriales se actualizan estrictamente de acuerdo con la documentación oficial. Si encuentras problemas de software o problemas de dependencias del entorno que no se pueden resolver, además de verificar la sección FAQ al final de este tutorial, por favor reporta el problema prontamente a la plataforma LeRobot o al canal Discord de LeRobot.

Especificaciones

| Tipo | SO-ARM100 | SO-ARM101 | ||

|---|---|---|---|---|

| Kit de Brazo | Kit de Brazo Pro | Kit de Brazo | Kit de Brazo Pro | |

| Brazo Líder | 12x motores ST-3215- C001 (7.4V) con relación de engranajes 1:345 para todas las articulaciones | 12x motores ST-3215-C018/ST-3215-C047 (12V) con relación de engranajes 1:345 para todas las articulaciones | 1x motor ST-3215- C001 (7.4V) con relación de engranajes 1:345 solo para la articulación 2 | |

| Brazo Seguidor | Igual que SO-ARM100 | |||

| Fuente de Alimentación | 5.5 mm × 2.1 mm DC 5 V 4 A | 5.5 mm × 2.1 mm DC 12 V 2 A | 5.5 mm × 2.1 mm DC 5 V 4 A | 5.5 mm × 2.1 mm DC 12 V 2 A (Brazo Seguidor) |

| Sensor de Ángulo | Codificador magnético de 12 bits | |||

| Temperatura de Operación Recomendada | 0 °C a 40 °C | |||

| Comunicación | UART | |||

| Método de Control | PC | |||

Si compras la versión Arm Kit, ambas fuentes de alimentación son de 5V. Si compras la versión Arm Kit Pro, por favor usa la fuente de alimentación de 5V para la calibración y cada paso del brazo robótico Líder, y la fuente de alimentación de 12V para la calibración y cada paso del brazo robótico Seguidor.

Lista de Materiales (BOM)

| Parte | Cantidad | Incluido |

|---|---|---|

| Motores Servo | 12 | ✅ |

| Placa de Control de Motor | 2 | ✅ |

| Cable USB-C 2 piezas | 1 | ✅ |

| Fuente de Alimentación2 | 2 | ✅ |

| Abrazadera de Mesa | 4 | ✅ |

| Partes impresas en 3D del brazo | 1 | Opción |

Entorno del Sistema Inicial

Para Ubuntu x86:

- Ubuntu 22.04

- CUDA 12+

- Python 3.10

- Torch 2.6+

Para Jetson Orin:

- Jetson JetPack 6.0 y 6.1, no soporta 6.1

- Python 3.10

- Torch 2.3+

Tabla de Contenidos

H. Grabar el conjunto de datos

I. Visualizar el conjunto de datos

Guía de Impresión 3D

Siguiendo la actualización oficial de SO101, SO100 ya no lo soportará y los archivos fuente serán eliminados según lo oficial, pero los archivos fuente aún se pueden encontrar en nuestro Makerworld. Sin embargo, para usuarios que han comprado previamente SO100, los tutoriales y métodos de instalación siguen siendo compatibles. La impresión de SO101 es completamente compatible con la instalación del kit de motor de SO100.

Paso 1: Elegir una impresora

Los archivos STL proporcionados están listos para imprimir en muchas impresoras FDM. A continuación se muestran las configuraciones probadas y sugeridas aunque otras pueden funcionar.

- Material: PLA+

- Diámetro de Boquilla y Precisión: diámetro de boquilla de 0.4mm a altura de capa de 0.2mm o boquilla de 0.6mm a altura de capa de 0.4mm.

- Densidad de Relleno: 15%

Paso 2: Configurar la impresora

- Asegúrate de que la impresora esté calibrada y el nivel de la cama esté configurado correctamente usando las instrucciones específicas de la impresora.

- Limpia la cama de impresión, asegurándote de que esté libre de polvo o grasa. Si limpias la cama usando agua u otro líquido, seca la cama.

- Si tu impresora lo recomienda, usa una barra de pegamento estándar y aplica una capa delgada y uniforme de pegamento en el área de impresión de la cama. Evita la acumulación o aplicación desigual.

- Carga el filamento de la impresora usando las instrucciones específicas de la impresora.

- Asegúrate de que la configuración de la impresora coincida con las sugeridas arriba (la mayoría de las impresoras tienen múltiples configuraciones, así que elige las que más se acerquen).

- Configura para soportes en todas partes pero ignora pendientes mayores a 45 grados respecto a la horizontal.

- No debe haber soportes en los agujeros de tornillos con ejes horizontales.

Paso 3: Imprimir las piezas

Todas las piezas para el líder o seguidor están ya contenidas en un solo archivo para facilitar la impresión 3D, correctamente orientadas con z hacia arriba para minimizar los soportes.

-

Para tamaños de cama de impresora de 220mmx220mm (como la Ender), imprime estos archivos:

-

Para tamaños de cama de impresora de 205mm x 250mm (como la Prusa/Up):

Instalar LeRobot

Entornos como pytorch y torchvision necesitan ser instalados basándose en tu CUDA.

- Instalar Miniconda: Para Jetson:

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-aarch64.sh

chmod +x Miniconda3-latest-Linux-aarch64.sh

./Miniconda3-latest-Linux-aarch64.sh

source ~/.bashrc

O, para X86 Ubuntu 22.04:

mkdir -p ~/miniconda3

cd miniconda3

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh -O ~/miniconda3/miniconda.sh

bash ~/miniconda3/miniconda.sh -b -u -p ~/miniconda3

rm ~/miniconda3/miniconda.sh

source ~/miniconda3/bin/activate

conda init --all

- Crear y activar un entorno conda nuevo para lerobot

conda create -y -n lerobot python=3.10 && conda activate lerobot

- Clonar Lerobot:

git clone https://github.com/Seeed-Projects/lerobot.git ~/lerobot

- Al usar miniconda, instala ffmpeg en tu entorno:

conda install ffmpeg -c conda-forge

Esto usualmente instala ffmpeg 7.X para tu plataforma compilado con el codificador libsvtav1. Si libsvtav1 no es compatible (verifica los codificadores compatibles con ffmpeg -encoders), puedes:

- [En cualquier plataforma] Instalar explícitamente ffmpeg 7.X usando:

conda install ffmpeg=7.1.1 -c conda-forge

- [Solo en Linux] Instalar las dependencias de compilación de ffmpeg y compilar ffmpeg desde el código fuente con libsvtav1, y asegúrate de usar el binario ffmpeg correspondiente a tu instalación con which ffmpeg.

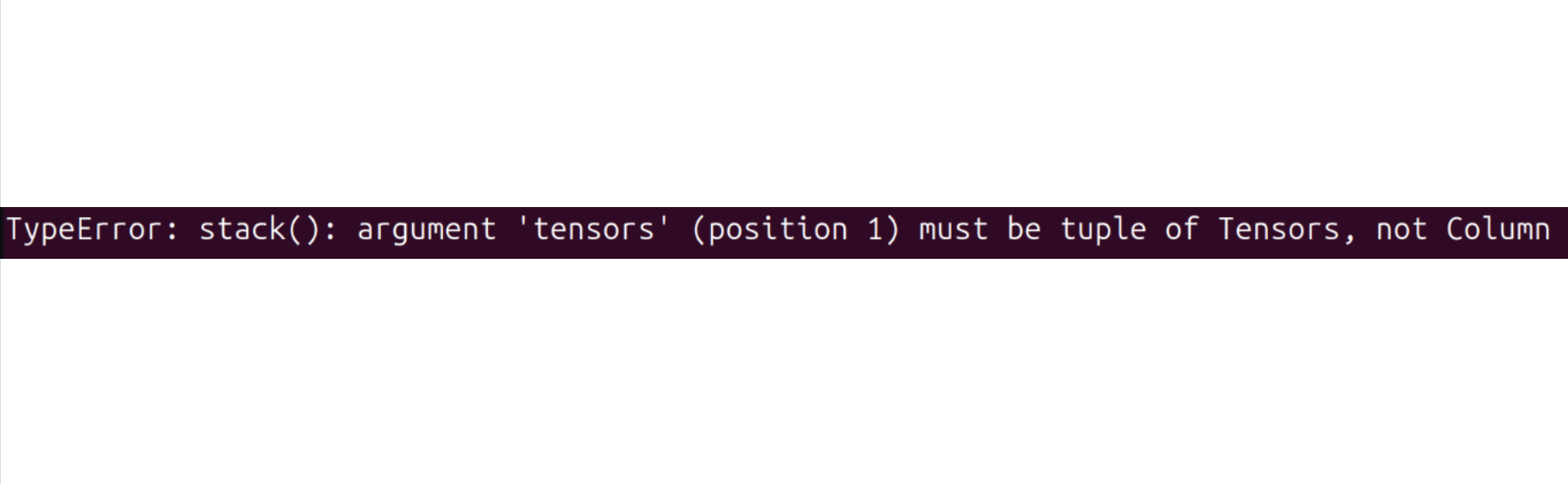

Si encuentras un error como este, también puedes usar este comando.

- Instalar LeRobot con dependencias para los motores feetech:

cd ~/lerobot && pip install -e ".[feetech]"

Para dispositivos Jetson Jetpack 6.0+ (por favor asegúrate de instalar Pytorch-gpu y Torchvision desde el paso 5 antes de ejecutar este paso):

conda install -y -c conda-forge "opencv>=4.10.0.84" # Install OpenCV and other dependencies through conda, this step is only for Jetson Jetpack 6.0+

conda remove opencv # Uninstall OpenCV

pip3 install opencv-python==4.10.0.84 # Then install opencv-python via pip3

conda install -y -c conda-forge ffmpeg

conda uninstall numpy

pip3 install numpy==1.26.0 # This should match torchvision

- Verificar Pytorch y Torchvision

Dado que instalar el entorno lerobot vía pip desinstalará el Pytorch y Torchvision originales e instalará las versiones CPU de Pytorch y Torchvision, necesitas realizar una verificación en Python.

import torch

print(torch.cuda.is_available())

Si el resultado impreso es False, necesitas reinstalar Pytorch y Torchvision según el tutorial del sitio web oficial.

Si estás usando un dispositivo Jetson, instala Pytorch y Torchvision según este tutorial.

Configurar los motores

- SO101

El proceso de calibración e inicialización del servo para SO-ARM101 es el mismo que el de SO-ARM100 en términos tanto de método como de código. Sin embargo, ten en cuenta que las relaciones de engranajes para las primeras tres articulaciones del Brazo Líder SO-ARM101 difieren de las de SO-ARM100, por lo que es importante distinguir y calibrarlas cuidadosamente.

Para configurar los motores, designa un adaptador de servo de bus y 6 motores para tu brazo líder, y de manera similar el otro adaptador de servo de bus y 6 motores para el brazo seguidor. Es conveniente etiquetarlos y escribir en cada motor si es para el seguidor F o para el líder L y su ID del 1 al 6. Usamos F1–F6 para representar las articulaciones 1 a 6 del Brazo Seguidor, y L1–L6 para representar las articulaciones 1 a 6 del Brazo Líder. Los detalles correspondientes del modelo de servo, asignaciones de articulaciones y relación de engranajes son los siguientes:

| Modelo de Servo | Relación de Engranajes | Articulaciones Correspondientes |

|---|---|---|

| ST-3215-C044(7.4V) | 1:191 | L1 |

| ST-3215-C001(7.4V) | 1:345 | L2 |

| ST-3215-C044(7.4V) | 1:191 | L3 |

| ST-3215-C046(7.4V) | 1:147 | L4–L6 |

| ST-3215-C001(7.4V) / C018(12V) / C047(12V) | 1:345 | F1–F6 |

Ahora debes conectar la fuente de alimentación de 5V o 12V al bus del motor. 5V para los motores STS3215 7.4V y 12V para los motores STS3215 12V. Ten en cuenta que el brazo líder siempre usa los motores de 7.4V, así que ten cuidado de conectar la fuente de alimentación correcta si tienes motores de 12V y 7.4V, ¡de lo contrario podrías quemar tus motores! Ahora, conecta el bus del motor a tu computadora vía USB. Ten en cuenta que el USB no proporciona energía, y tanto la fuente de alimentación como el USB deben estar conectados.

Los siguientes son los pasos de calibración de código, por favor calibra con el servo de cableado de referencia en la imagen de arriba

Encontrar puertos USB asociados a tus brazos Para encontrar los puertos correctos para cada brazo, ejecuta el script de utilidad dos veces:

lerobot-find-port

Salida de ejemplo:

Finding all available ports for the MotorBus.

['/dev/ttyACM0', '/dev/ttyACM1']

Remove the usb cable from your MotorsBus and press Enter when done.

[...Disconnect corresponding leader or follower arm and press Enter...]

The port of this MotorsBus is /dev/ttyACM1

Reconnect the USB cable.

Recuerda quitar el usb, de lo contrario la interfaz no será detectada.

Salida de ejemplo al identificar el puerto del brazo seguidor (ej., /dev/tty.usbmodem575E0031751 en Mac, o posiblemente /dev/ttyACM0 en Linux):

Salida de ejemplo al identificar el puerto del brazo líder (ej., /dev/tty.usbmodem575E0032081, o posiblemente /dev/ttyACM1 en Linux):

Podrías necesitar dar acceso a los puertos USB ejecutando:

sudo chmod 666 /dev/ttyACM0

sudo chmod 666 /dev/ttyACM1

Configurar tus motores

Por favor usa una fuente de alimentación de 5V para calibrar los motores Líder (ST-3215-C046, C044, 001).

| Calibración Articulación 6 Brazo Líder | Calibración Articulación 5 Brazo Líder | Calibración Articulación 4 Brazo Líder | Calibración Articulación 3 Brazo Líder | Calibración Articulación 2 Brazo Líder | Calibración Articulación 1 Brazo Líder |

|---|---|---|---|---|---|

|  |  |  |  |  |

Si compras la versión Arm Kit (ST-3215-C001), usa una fuente de alimentación de 5V. Si compras la versión Arm Kit Pro, por favor usa una fuente de alimentación de 12V para calibrar el servo (ST-3215-C047/ST-3215-C018).

| Calibración Articulación 6 Brazo Seguidor | Calibración Articulación 5 Brazo Seguidor | Calibración Articulación 4 Brazo Seguidor | Calibración Articulación 3 Brazo Seguidor | Calibración Articulación 2 Brazo Seguidor | Calibración Articulación 1 Brazo Seguidor |

|---|---|---|---|---|---|

|  |  |  |  |  |

Nuevamente, asegúrate de que los IDs de las articulaciones del servo y las relaciones de engranajes correspondan estrictamente a los del SO-ARM101.

Conecta el cable USB desde tu computadora y la fuente de alimentación a la placa controladora del brazo seguidor. Luego, ejecuta el siguiente comando.

lerobot-setup-motors \

--robot.type=so101_follower \

--robot.port=/dev/ttyACM0 # <- paste here the port found at previous step

Deberías ver la siguiente instrucción.

Connect the controller board to the 'gripper' motor only and press enter.

Como se indica, conecta el motor de la pinza. Asegúrate de que sea el único motor conectado a la placa, y que el motor en sí no esté aún conectado en cadena a ningún otro motor. Al presionar [Enter], el script configurará automáticamente el ID y la velocidad de transmisión para ese motor.

Luego deberías ver el siguiente mensaje:

'gripper' motor id set to 6

Seguido de la siguiente instrucción:

Connect the controller board to the 'wrist_roll' motor only and press enter.

Puedes desconectar el cable de 3 pines de la placa controladora, pero puedes dejarlo conectado al motor de la pinza en el otro extremo, ya que ya estará en el lugar correcto. Ahora, conecta otro cable de 3 pines al motor de rotación de la muñeca y conéctalo a la placa controladora. Al igual que con el motor anterior, asegúrate de que sea el único motor conectado a la placa y que el motor en sí no esté conectado a ningún otro.

Repite la operación para cada motor según se indique.

Verifica tu cableado en cada paso antes de presionar Enter. Por ejemplo, el cable de la fuente de alimentación podría desconectarse mientras manipulas la placa.

Cuando hayas terminado, el script simplemente finalizará, momento en el cual los motores estarán listos para ser utilizados. Ahora puedes conectar el cable de 3 pines de cada motor al siguiente, y el cable del primer motor (el 'giro del hombro' con id=1) a la placa controladora, que ahora puede ser fijada a la base del brazo.

Realiza los mismos pasos para el brazo líder.

lerobot-setup-motors \

--teleop.type=so101_leader \

--teleop.port=/dev/ttyACM0 # <- paste here the port found at previous step

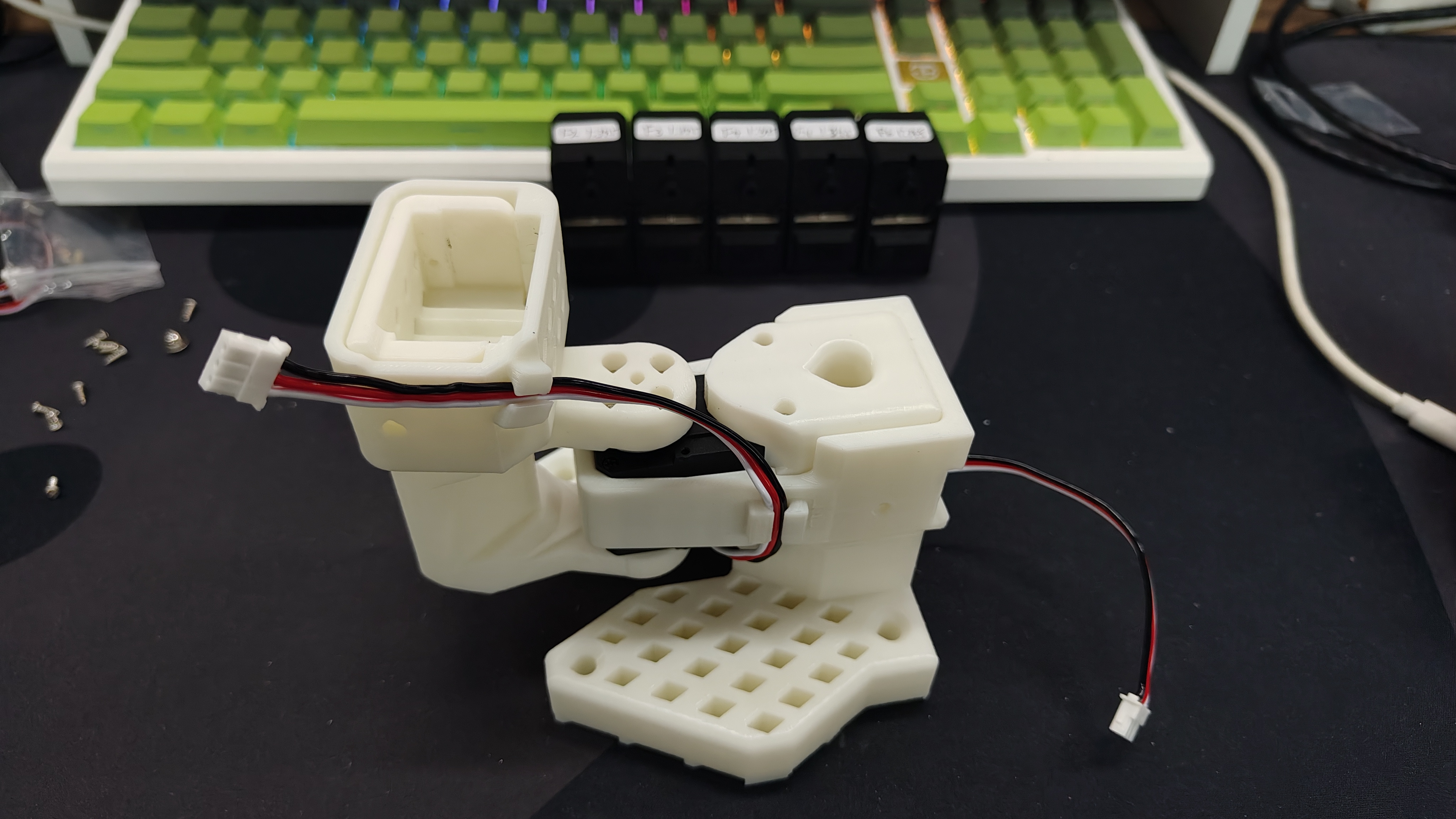

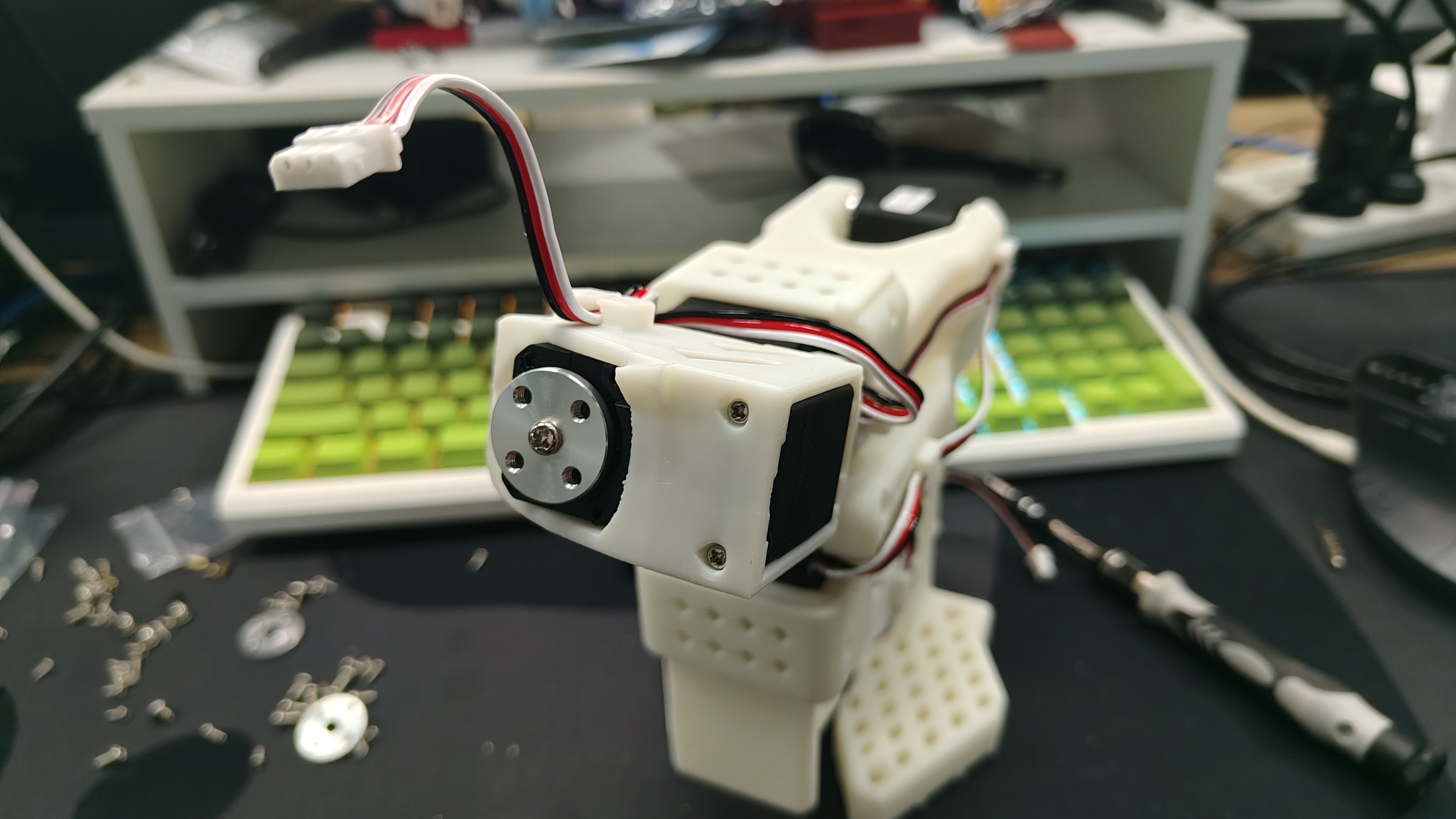

Ensamblaje

- El proceso de ensamblaje de doble brazo del SO-ARM101 es el mismo que el del SO-ARM100. Las únicas diferencias son la adición de clips de cable en el SO-ARM101 y las diferentes relaciones de engranajes de los servos de las articulaciones en el Brazo Líder. Por lo tanto, tanto el SO100 como el SO101 pueden instalarse siguiendo el siguiente contenido

- Antes del ensamblaje, por favor verifica nuevamente tu modelo de motor y relación de reducción. Si has comprado el SO100, puedes ignorar este paso. Si has comprado el SO101, por favor verifica la siguiente tabla para distinguir F1 a F6 y L1 a L6.

| Modelo de Servo | Relación de Engranajes | Articulaciones Correspondientes |

|---|---|---|

| ST-3215-C044(7.4V) | 1:191 | L1 |

| ST-3215-C001(7.4V) | 1:345 | L2 |

| ST-3215-C044(7.4V) | 1:191 | L3 |

| ST-3215-C046(7.4V) | 1:147 | L4–L6 |

| ST-3215-C001(7.4V) / C018(12V) / C047(12V) | 1:345 | F1–F6 |

Si compraste el SO101 Arm Kit Standard Edition, todas las fuentes de alimentación son de 5V. Si compraste el SO101 Arm Kit Pro Edition, el Brazo Líder debe calibrarse y operarse en cada paso usando una fuente de alimentación de 5V, mientras que el Brazo Seguidor debe calibrarse y operarse en cada paso usando una fuente de alimentación de 12V.

Ensamblar Brazo Líder

| Paso 1 | Paso 2 | Paso 3 | Paso 4 | Paso 5 | Paso 6 |

|---|---|---|---|---|---|

|  |  |  |  |  |

| Paso 7 | Paso 8 | Paso 9 | Paso 10 | Paso 11 | Paso 12 |

|  |  |  |  |  |

| Paso 13 | Paso 14 | Paso 15 | Paso 16 | Paso 17 | Paso 18 |

|  |  |  |  |  |

| Paso 19 | Paso 20 | ||||

|  |

Ensamblar Brazo Seguidor

- Los pasos para ensamblar el Brazo Seguidor son generalmente los mismos que los del Brazo Líder. La única diferencia radica en el método de instalación del efector final (pinza y mango) después del Paso 12.

| Paso 1 | Paso 2 | Paso 3 | Paso 4 | Paso 5 | Paso 6 |

|---|---|---|---|---|---|

|  |  |  |  |  |

| Paso 7 | Paso 8 | Paso 9 | Paso 10 | Paso 11 | Paso 12 |

|  |  |  |  |  |

| Paso 13 | Paso 14 | Paso 15 | Paso 16 | Paso 17 | |

|  |  |  |  |

Calibrar

Los códigos del SO100 y SO101 son compatibles. Los usuarios del SO100 pueden utilizar directamente los parámetros y código del SO101 para la operación.

Si compraste el SO101 Arm Kit Standard Edition, todas las fuentes de alimentación son de 5V. Si compraste el SO101 Arm Kit Pro Edition, el Brazo Líder debe calibrarse y operarse en cada paso usando una fuente de alimentación de 5V, mientras que el Brazo Seguidor debe calibrarse y operarse en cada paso usando una fuente de alimentación de 12V.

A continuación, necesitas conectar la fuente de alimentación y el cable de datos a tu robot SO-10x para la calibración para asegurar que los brazos líder y seguidor tengan los mismos valores de posición cuando estén en la misma posición física. Esta calibración es esencial porque permite que una red neuronal entrenada en un robot SO-10x funcione en otro. Si necesitas recalibrar el brazo robótico, elimina los archivos bajo ~/.cache/huggingface/lerobot/calibration/robots o ~/.cache/huggingface/lerobot/calibration/teleoperators y recalibra el brazo robótico. De lo contrario, aparecerá un mensaje de error. La información de calibración del brazo robótico se almacenará en los archivos JSON bajo este directorio.

Calibración manual del brazo seguidor

Por favor conecta las interfaces de los 6 servos del robot mediante un cable de 3 pines y conecta el servo del chasis a la placa de control del servo, luego ejecuta el siguiente comando o ejemplo de API para calibrar el brazo robótico:

Primero se otorgan permisos de interfaz

sudo chmod 666 /dev/ttyACM*

Luego calibra el brazo seguidor

lerobot-calibrate \

--robot.type=so101_follower \

--robot.port=/dev/ttyACM0 \# <- The port of your robot

--robot.id=my_awesome_follower_arm # <- Give the robot a unique name

El video a continuación muestra cómo realizar la calibración. Primero necesitas mover el robot a la posición donde todas las articulaciones estén en el medio de sus rangos. Luego, después de presionar enter, tienes que mover cada articulación a través de su rango completo de movimiento.

Calibración manual del brazo líder

Realiza los mismos pasos para calibrar el brazo líder, ejecuta el siguiente comando o ejemplo de API:

lerobot-calibrate \

--teleop.type=so101_leader \

--teleop.port=/dev/ttyACM1 \# <- The port of your robot

--teleop.id=my_awesome_leader_arm # <- Give the robot a unique name

Teleoperar

Teleoperación simple ¡Entonces estás listo para teleoperar tu robot! Ejecuta este script simple (no se conectará ni mostrará las cámaras):

Ten en cuenta que el id asociado con un robot se usa para almacenar el archivo de calibración. Es importante usar el mismo id al teleoperar, grabar y evaluar cuando uses la misma configuración.

sudo chmod 666 /dev/ttyACM*

lerobot-teleoperate \

--robot.type=so101_follower \

--robot.port=/dev/ttyACM0 \

--robot.id=my_awesome_follower_arm \

--teleop.type=so101_leader \

--teleop.port=/dev/ttyACM1 \

--teleop.id=my_awesome_leader_arm

El comando teleoperate automáticamente:

- Identificará cualquier calibración faltante e iniciará el procedimiento de calibración.

- Conectará el robot y el dispositivo de teleoperación e iniciará la teleoperación.

Agregar cámaras

Si usas la Cámara de Profundidad Orbbec Gemini2

- 🚀 Paso 1: Instalar el Entorno Dependiente del SDK de Orbbec

-

Clonar el repositorio

pyorbbeccd ~/

git clone https://github.com/orbbec/pyorbbecsdk.git -

Descargar e instalar el archivo .whl correspondiente para el SDK

Ve a pyorbbecsdk Releases,

selecciona e instala basándote en tu versión de Python. Por ejemplo:pip install pyorbbecsdk-x.x.x-cp310-cp310-linux_x86_64.whl -

Instalar dependencias en el directorio

pyorbbeccd ~/pyorbbecsdk

pip install -r requirements.txtForzar la degradación de la versión de

numpya1.26.0pip install numpy==1.26.0

Los mensajes de error rojos pueden ser ignorados.

- Clonar el SDK de Orbbec en el directorio

~/lerobot/src/cameras

cd ~/lerobot/src/cameras

git clone https://github.com/ZhuYaoHui1998/orbbec.git

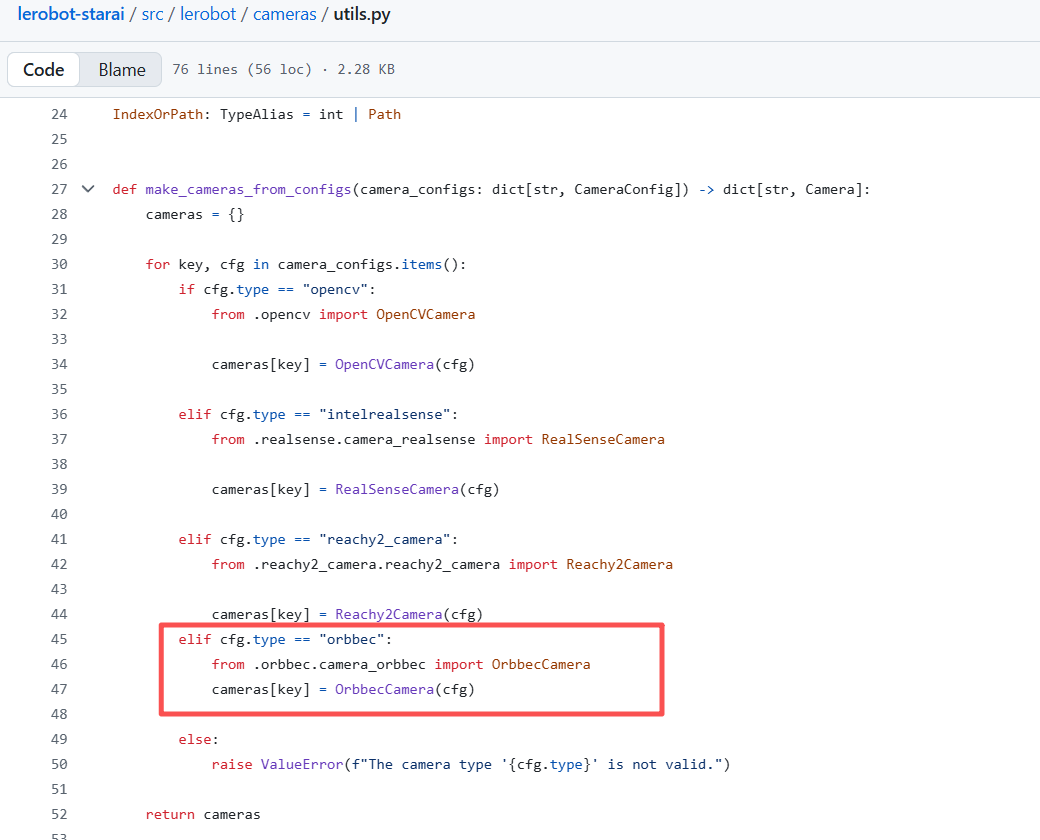

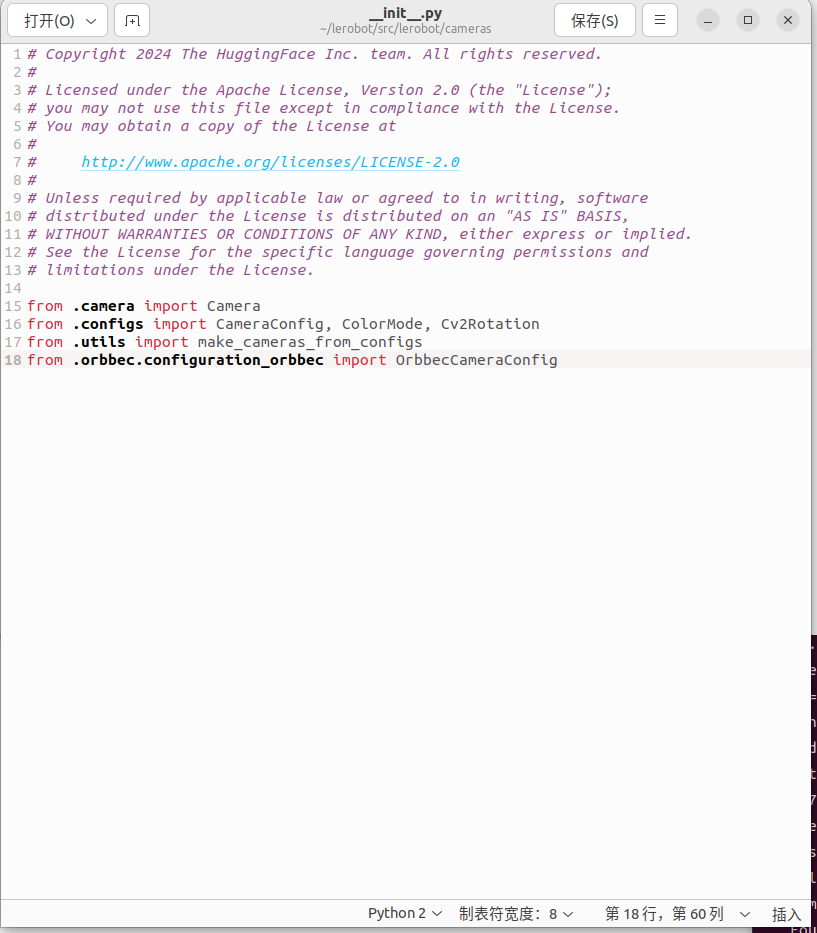

- Modificar utils.py y init.py

- Encuentra

utils.pyen el directorio~/lerobot/src/lerobot/cameras, y agrega el siguiente código en la línea 40:

elif cfg.type == "orbbec":

from .orbbec.camera_orbbec import OrbbecCamera

cameras[key] = OrbbecCamera(cfg)

- Encuentra

__init__.pyen el directorio~/lerobot/src/lerobot/cameras, y agrega el siguiente código en la línea 18:

from .orbbec.configuration_orbbec import OrbbecCameraConfig

- 🚀 Paso 2: Llamada de Función y Ejemplos

En todos los siguientes ejemplos, reemplaza so101_follower con el modelo real del brazo robótico que estés usando (ej., so100 / so101).

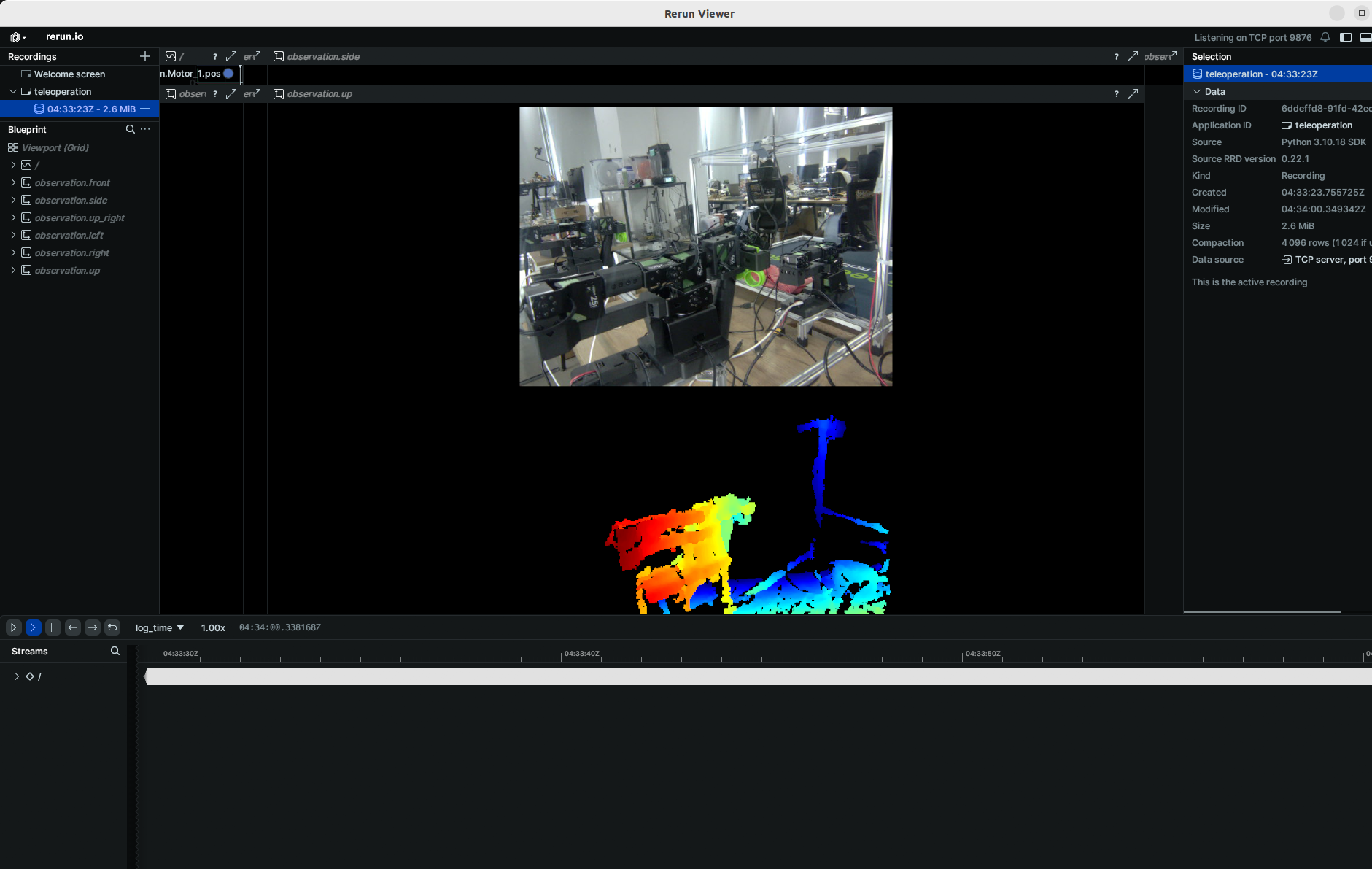

Hemos agregado el hiperparámetro focus_area. Dado que los datos de profundidad que están demasiado lejos no tienen sentido para el brazo robótico (no puede alcanzar o agarrar objetos), los datos de profundidad menores o mayores que el focus_area se mostrarán en negro. El focus_area predeterminado es (20, 600).

Actualmente, la única resolución soportada es ancho: 640, alto: 880.

lerobot-teleoperate \

--robot.type=so101_follower \

--robot.port=/dev/ttyACM0 \

--robot.id=my_awesome_follower_arm \

--robot.cameras="{ up: {type: orbbec, width: 640, height: 880, fps: 30, focus_area:[60,300]}}" \

--teleop.type=so101_leader \

--teleop.port=/dev/ttyACM1 \

--teleop.id=my_awesome_leader_arm \

--display_data=true

Para tareas posteriores como recolección de datos, entrenamiento y evaluación, el proceso es el mismo que para comandos RGB regulares. Solo necesitas reemplazar la parte relevante en el comando RGB regular con:

--robot.cameras="{ up: {type: orbbec, width: 640, height: 880, fps: 30, focus_area:[60,300]}}" \

También puedes agregar una cámara RGB monocular adicional después.

Los códigos SO100 y SO101 son compatibles. Los usuarios de SO100 pueden utilizar directamente los parámetros y código de SO101 para la operación.

Para instanciar una cámara, necesitas un identificador de cámara. Este identificador podría cambiar si reinicias tu computadora o reconectas tu cámara, un comportamiento que depende principalmente de tu sistema operativo.

Para encontrar los índices de cámara de las cámaras conectadas a tu sistema, ejecuta el siguiente script:

lerobot-find-cameras opencv # or realsense for Intel Realsense cameras

La terminal imprimirá la siguiente información.

--- Detected Cameras ---

Camera #0:

Name: OpenCV Camera @ 0

Type: OpenCV

Id: 0

Backend api: AVFOUNDATION

Default stream profile:

Format: 16.0

Width: 1920

Height: 1080

Fps: 15.0

--------------------

(more cameras ...)

Puedes encontrar las imágenes tomadas por cada cámara en el directorio outputs/captured_images.

Al usar cámaras Intel RealSense en macOS, podrías obtener este error: Error finding RealSense cameras: failed to set power state, esto se puede resolver ejecutando el mismo comando con permisos sudo. Ten en cuenta que usar cámaras RealSense en macOS es inestable.

Entonces podrás mostrar las cámaras en tu computadora mientras teleoperás ejecutando el siguiente código. Esto es útil para preparar tu configuración antes de grabar tu primer conjunto de datos.

lerobot-teleoperate \

--robot.type=so101_follower \

--robot.port=/dev/ttyACM0 \

--robot.id=my_awesome_follower_arm \

--robot.cameras="{ front: {type: opencv, index_or_path: 0, width: 640, height: 480, fps: 30, fourcc: "MJPG"}}" \

--teleop.type=so101_leader \

--teleop.port=/dev/ttyACM1 \

--teleop.id=my_awesome_leader_arm \

--display_data=true

Si tienes más cámaras, puedes cambiar --robot.cameras para agregar cámaras. Debes notar el formato del index_or_path, que está determinado por el último dígito del ID de cámara mostrado por python -m lerobot.find_cameras opencv.

Las imágenes en formato fourcc: "MJPG" están comprimidas. Puedes probar resoluciones más altas, y también puedes intentar el formato YUYV. Sin embargo, este último reducirá la resolución de imagen y FPS, causando retraso en la operación del brazo robótico. Actualmente, bajo el formato MJPG, puede soportar 3 cámaras a una resolución de 1920*1080 manteniendo 30FPS. Dicho esto, conectar 2 cámaras a una computadora a través del mismo USB HUB aún no se recomienda.

Por ejemplo, quieres agregar una cámara lateral:

lerobot-teleoperate \

--robot.type=so101_follower \

--robot.port=/dev/ttyACM0 \

--robot.id=my_awesome_follower_arm \

--robot.cameras="{ front: {type: opencv, index_or_path: 0, width: 640, height: 480, fps: 30, fourcc: "MJPG"}, side: {type: opencv, index_or_path: 2, width: 640, height: 480, fps: 30, fourcc: "MJPG"}}" \

--teleop.type=so101_leader \

--teleop.port=/dev/ttyACM1 \

--teleop.id=my_awesome_leader_arm \

--display_data=true

Las imágenes en formato fourcc: "MJPG" están comprimidas. Puedes probar resoluciones más altas, y también puedes intentar el formato YUYV. Sin embargo, este último reducirá la resolución de imagen y FPS, causando retraso en la operación del brazo robótico. Actualmente, bajo el formato MJPG, puede soportar 3 cámaras a una resolución de 1920*1080 manteniendo 30FPS. Dicho esto, conectar 2 cámaras a una computadora a través del mismo USB HUB aún no se recomienda.

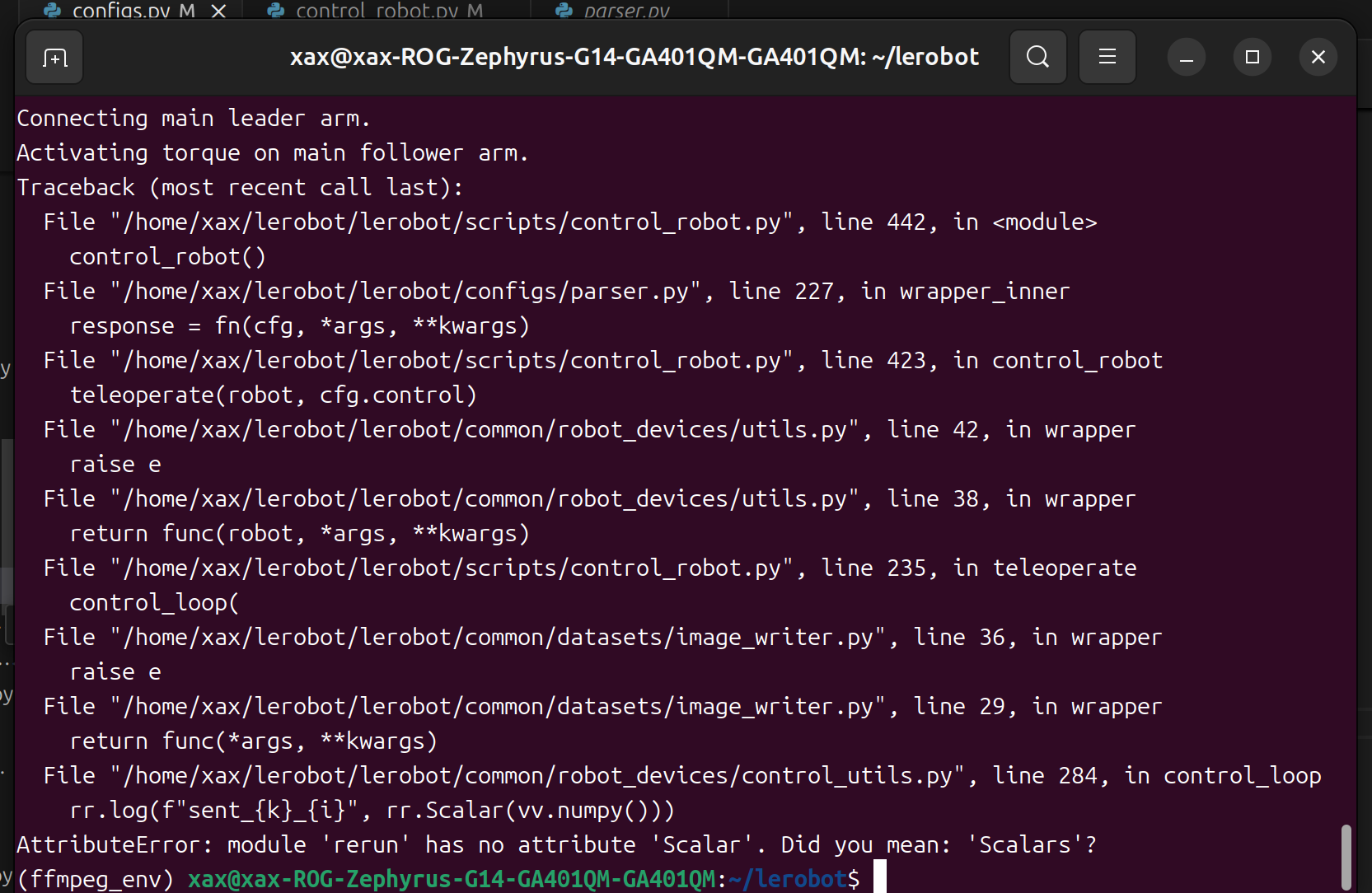

Si encuentras un error como este.

Puedes degradar la versión de rerun para resolver el problema.

pip3 install rerun-sdk==0.23

Grabar el conjunto de datos

- Si quieres guardar el conjunto de datos localmente, puedes ejecutarlo directamente:

lerobot-record \

--robot.type=so101_follower \

--robot.port=/dev/ttyACM0 \

--robot.id=my_awesome_follower_arm \

--robot.cameras="{ front: {type: opencv, index_or_path: 0, width: 640, height: 480, fps: 30, fourcc: "MJPG"}, side: {type: opencv, index_or_path: 2, width: 640, height: 480, fps: 30, fourcc: "MJPG"}}" \

--teleop.type=so101_leader \

--teleop.port=/dev/ttyACM1 \

--teleop.id=my_awesome_leader_arm \

--display_data=true \

--dataset.repo_id=seeedstudio123/test \

--dataset.num_episodes=5 \

--dataset.single_task="Grab the black cube" \

--dataset.push_to_hub=false \

--dataset.episode_time_s=30 \

--dataset.reset_time_s=30

Entre ellos, repo_id se puede modificar de forma personalizada, y push_to_hub=false. Finalmente, el conjunto de datos se guardará en el directorio ~/.cache/huggingface/lerobot en la carpeta de inicio, donde se creará la carpeta seeedstudio123/test mencionada anteriormente.

- Si quieres usar las funciones del hub de Hugging Face para subir tu conjunto de datos y no lo has hecho anteriormente, asegúrate de haber iniciado sesión usando un token de acceso de escritura, que se puede generar desde la configuración de Hugging Face:

huggingface-cli login --token ${HUGGINGFACE_TOKEN} --add-to-git-credential

Almacena el nombre de tu repositorio de Hugging Face en una variable para ejecutar estos comandos:

HF_USER=$(huggingface-cli whoami | head -n 1)

echo $HF_USER

Graba 5 episodios y sube tu conjunto de datos al hub:

lerobot-record \

--robot.type=so101_follower \

--robot.port=/dev/ttyACM0 \

--robot.id=my_awesome_follower_arm \

--robot.cameras="{ front: {type: opencv, index_or_path: 0, width: 640, height: 480, fps: 30, fourcc: "MJPG"}, side: {type: opencv, index_or_path: 2, width: 640, height: 480, fps: 30, fourcc: "MJPG"}}" \

--teleop.type=so101_leader \

--teleop.port=/dev/ttyACM1 \

--teleop.id=my_awesome_leader_arm \

--display_data=true \

--dataset.repo_id=${HF_USER}/record-test \

--dataset.num_episodes=5 \

--dataset.single_task="Grab the black cube" \

--dataset.push_to_hub=true \

--dataset.episode_time_s=30 \

--dataset.reset_time_s=30

Verás muchas líneas apareciendo como esta:

INFO 2024-08-10 15:02:58 ol_robot.py:219 dt:33.34 (30.0hz) dtRlead: 5.06 (197.5hz) dtWfoll: 0.25 (3963.7hz) dtRfoll: 6.22 (160.7hz) dtRlaptop: 32.57 (30.7hz) dtRphone: 33.84 (29.5hz)

Función de grabación

La función record proporciona un conjunto de herramientas para capturar y gestionar datos durante la operación del robot.

1. Almacenamiento de Datos

- Los datos se almacenan usando el formato

LeRobotDatasety se guardan en disco durante la grabación. - Por defecto, el conjunto de datos se sube a tu página de Hugging Face después de la grabación.

- Para deshabilitar la subida, usa:

--dataset.push_to_hub=False

2. Puntos de Control y Reanudación

- Los puntos de control se crean automáticamente durante la grabación.

- Para reanudar después de una interrupción, vuelve a ejecutar el mismo comando con:

--resume=true

⚠️ Nota Crítica: Al reanudar, establece --dataset.num_episodes al número de episodios adicionales a grabar (no el número total objetivo de episodios en el conjunto de datos).

- Para comenzar a grabar desde cero, elimina manualmente el directorio del conjunto de datos.

3. Parámetros de Grabación

Configura el flujo de grabación de datos usando argumentos de línea de comandos:

| Parámetro | Descripción | Por defecto |

|---|---|---|

| --dataset.episode_time_s | Duración por episodio de datos (segundos) | 60 |

| --dataset.reset_time_s | Tiempo de reinicio del entorno después de cada episodio (segundos) | 60 |

| --dataset.num_episodes | Total de episodios a grabar | 50 |

4. Controles de Teclado Durante la Grabación

Controla el flujo de grabación de datos usando atajos de teclado:

| Tecla | Acción |

|---|---|

| → (Flecha Derecha) | Detener temprano el episodio actual/reiniciar; pasar al siguiente. |

| ← (Flecha Izquierda) | Cancelar episodio actual; volver a grabarlo. |

| ESC | Detener sesión inmediatamente, codificar videos y subir conjunto de datos. |

Si el teclado no funciona, puede que necesites instalar otra versión de pynput.

pip install pynput==1.6.8

Consejos para Recopilar Datos

- Sugerencia de Tarea: Agarrar objetos en diferentes ubicaciones y colocarlos en un contenedor.

- Escala: Graba ≥50 episodios (10 episodios por ubicación).

- Consistencia:

- Mantén las cámaras fijas.

- Mantén un comportamiento de agarre idéntico.

- Asegúrate de que los objetos manipulados sean visibles en las transmisiones de la cámara.

- Progresión:

- Comienza con un agarre confiable antes de agregar variaciones (nuevas ubicaciones, técnicas, ajustes de cámara).

- Evita aumentos rápidos de complejidad para prevenir fallos.

💡 Regla General: Deberías poder hacer la tarea tú mismo solo mirando las imágenes de la cámara.

Si quieres profundizar en este tema importante, puedes consultar la publicación del blog que escribimos sobre qué hace un buen conjunto de datos.

Solución de Problemas

Problema específico de Linux:

Si las teclas Flecha Derecha/Flecha Izquierda/ESC no responden durante la grabación:

- Verifica que la variable de entorno

$DISPLAYesté configurada (ver limitaciones de pynput).

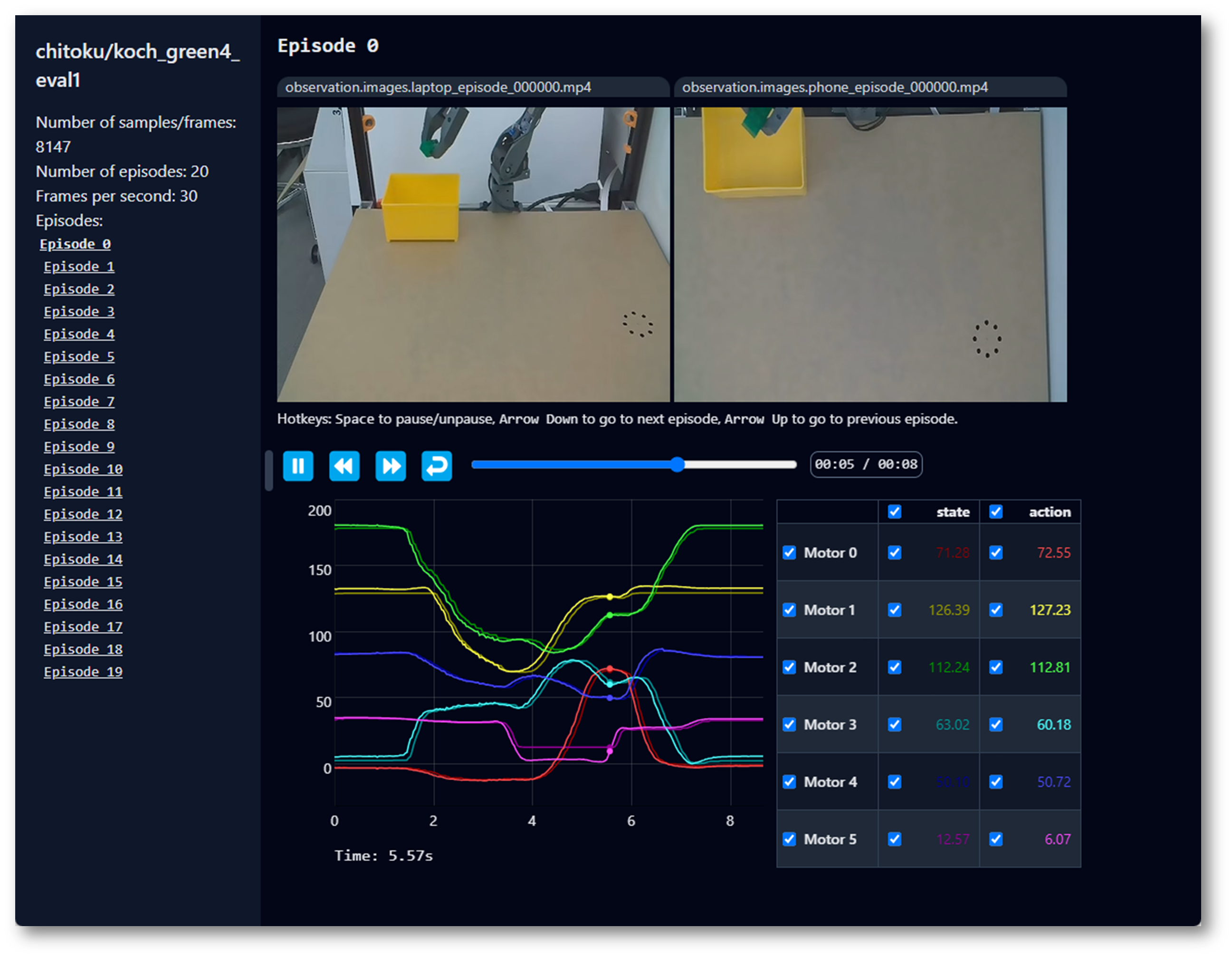

Visualizar el conjunto de datos

Los códigos SO100 y SO101 son compatibles. Los usuarios de SO100 pueden utilizar directamente los parámetros y código de SO101 para la operación.

Si subiste tu conjunto de datos al hub con --control.push_to_hub=true, puedes visualizar tu conjunto de datos en línea copiando y pegando tu repo id dado por:

echo ${HF_USER}/so101_test

Si no subiste con --dataset.push_to_hub=false, también puedes visualizarlo localmente con:

lerobot-dataset-viz \

--repo-id ${HF_USER}/so101_test \

Si subes con --dataset.push_to_hub=false, también puedes visualizarlo localmente con:

lerobot-dataset-viz \

--repo-id seeed_123/so101_test \

Aquí, seeed_123 es el nombre personalizado de repo_id definido al recopilar datos.

Reproducir un episodio

Los códigos SO100 y SO101 son compatibles. Los usuarios de SO100 pueden utilizar directamente los parámetros y código de SO101 para la operación.

Una función útil es la función replay, que te permite reproducir cualquier episodio que hayas grabado o episodios de cualquier conjunto de datos disponible. Esta función te ayuda a probar la repetibilidad de las acciones de tu robot y evaluar la transferibilidad entre robots del mismo modelo.

Puedes reproducir el primer episodio en tu robot con el comando de abajo o con el ejemplo de API:

lerobot-replay \

--robot.type=so101_follower \

--robot.port=/dev/ttyACM0 \

--robot.id=my_awesome_follower_arm \

--dataset.repo_id=${HF_USER}/record-test \

--dataset.episode=0

Tu robot debería replicar movimientos similares a los que grabaste.

Entrenar y Evaluar

ACT

Consulta ACT

Para entrenar una política para controlar tu robot, usa el script lerobot-train.

Entrenar

lerobot-train \

--dataset.repo_id=${HF_USER}/so101_test \

--policy.type=act \

--output_dir=outputs/train/act_so101_test \

--job_name=act_so101_test \

--policy.device=cuda \

--wandb.enable=false \

--steps=300000

Si quieres entrenar en un conjunto de datos local, asegúrate de que el repo_id coincida con el usado durante la recopilación de datos y agrega --policy.push_to_hub=False.

lerobot-train \

--dataset.repo_id=seeedstudio123/test \

--policy.type=act \

--output_dir=outputs/train/act_so101_test \

--job_name=act_so101_test \

--policy.device=cuda \

--wandb.enable=false \

--policy.push_to_hub=false\

--steps=300000

Vamos a explicarlo:

- Especificación del conjunto de datos: Proporcionamos el conjunto de datos a través del parámetro

--dataset.repo_id=${HF_USER}/so101_test. - Pasos de entrenamiento: Modificamos el número de pasos de entrenamiento usando

--steps=300000. El algoritmo por defecto usa 800000 pasos, y puedes ajustarlo según la dificultad de tu tarea y observando la pérdida durante el entrenamiento. - Tipo de política: Proporcionamos la política con

policy.type=act. De manera similar, puedes cambiar entre políticas como [act,diffusion,pi0,pi0fast,pi0fast,sac,smolvla]., que cargará la configuración desdeconfiguration_act.py. Importante, esta política se adaptará automáticamente a los estados del motor de tu robot (por ejemplo,laptopyphone), acciones del motor y el número de cámaras, ya que esta información ya está almacenada en tu conjunto de datos. - Selección de dispositivo: Proporcionamos

policy.device=cudaporque estamos entrenando en una GPU Nvidia, pero puedes usarpolicy.device=mpspara entrenar en Apple Silicon. - Herramienta de visualización: Proporcionamos

wandb.enable=truepara visualizar gráficos de entrenamiento usando Weights and Biases. Esto es opcional, pero si lo usas, asegúrate de haber iniciado sesión ejecutandowandb login.

Evaluar

Los códigos SO100 y SO101 son compatibles. Los usuarios de SO100 pueden utilizar directamente los parámetros y código de SO101 para la operación.

Puedes usar la función record de lerobot/record.py pero con un punto de control de política como entrada. Por ejemplo, ejecuta este comando para grabar 10 episodios de evaluación:

lerobot-record \

--robot.type=so100_follower \

--robot.port=/dev/ttyACM0 \

--robot.cameras="{ up: {type: opencv, index_or_path: /dev/video10, width: 640, height: 480, fps: 30, fourcc: "MJPG"}, side: {type: intelrealsense, serial_number_or_name: 233522074606, width: 640, height: 480, fps: 30, fourcc: "MJPG"}}" \

--robot.id=my_awesome_follower_arm \

--display_data=false \

--dataset.repo_id=${HF_USER}/eval_so100 \

--dataset.single_task="Put lego brick into the transparent box" \

--policy.path=${HF_USER}/my_policy

como por ejemplo:

lerobot-record \

--robot.type=so101_follower \

--robot.port=/dev/ttyACM0 \

--robot.cameras="{ front: {type: opencv, index_or_path: 0, width: 640, height: 480, fps: 30, fourcc: "MJPG"}, side: {type: opencv, index_or_path: 2, width: 640, height: 480, fps: 30, fourcc: "MJPG"}}" \

--robot.id=my_awesome_follower_arm \

--display_data=false \

--dataset.repo_id=seeed/eval_test123 \

--dataset.single_task="Put lego brick into the transparent box" \

--policy.path=outputs/train/act_so101_test/checkpoints/last/pretrained_model

-

El parámetro

--policy.pathindica la ruta al archivo de pesos de los resultados de entrenamiento de tu política (por ejemplo,outputs/train/act_so101_test/checkpoints/last/pretrained_model). Si subes el archivo de pesos del resultado del entrenamiento del modelo a Hub, también puedes usar el repositorio del modelo (por ejemplo,${HF_USER}/act_so100_test). -

El nombre del conjunto de datos

dataset.repo_idcomienza coneval_. Esta operación registrará por separado videos y datos durante la evaluación, que se guardarán en la carpeta que comience coneval_, comoseeed/eval_test123. -

Si encuentras

File exists: 'home/xxxx/.cache/huggingface/lerobot/xxxxx/seeed/eval_xxxx'durante la fase de evaluación, por favor elimina primero la carpeta que comience coneval_y luego ejecuta el programa nuevamente. -

Cuando encuentres

mean is infinity. You should either initialize with stats as an argument or use a pretrained model, ten en cuenta que las palabras clave como front y side en el parámetro--robot.camerasdeben ser estrictamente consistentes con las utilizadas al recopilar el conjunto de datos.

SmolVLA

SmolVLA es el modelo fundacional ligero de Hugging Face para robótica. Diseñado para un ajuste fino fácil en conjuntos de datos de LeRobot, ¡ayuda a acelerar tu desarrollo!

Configura Tu Entorno

Instala las dependencias de SmolVLA ejecutando:

pip install -e ".[smolvla]"

Ajusta SmolVLA con tus datos

Usa smolvla_base, nuestro modelo preentrenado de 450M, y ajústalo con tus datos. Entrenar el modelo durante 20k pasos tomará aproximadamente ~4 horas en una sola GPU A100. Debes ajustar el número de pasos basándote en el rendimiento y tu caso de uso.

Si no tienes un dispositivo GPU, puedes entrenar usando nuestro notebook en Google Colab.

Pasa tu conjunto de datos al script de entrenamiento usando --dataset.repo_id. Si quieres probar tu instalación, ejecuta el siguiente comando donde usamos uno de los conjuntos de datos que recopilamos para el Artículo de SmolVLA.

lerobot-train \

--policy.path=lerobot/smolvla_base \

--dataset.repo_id=${HF_USER}/mydataset \

--batch_size=64 \

--steps=20000 \

--output_dir=outputs/train/my_smolvla \

--job_name=my_smolvla_training \

--policy.device=cuda \

--wandb.enable=true

Puedes comenzar con un tamaño de lote pequeño y aumentarlo incrementalmente, si la GPU lo permite, siempre que los tiempos de carga se mantengan cortos.

El ajuste fino es un arte. Para una visión completa de las opciones para el ajuste fino, ejecuta

lerobot-train --help

Evalúa el modelo ajustado y ejecútalo en tiempo real

De manera similar a cuando grabas un episodio, se recomienda que hayas iniciado sesión en HuggingFace Hub. Puedes seguir los pasos correspondientes: Grabar un conjunto de datos. Una vez que hayas iniciado sesión, puedes ejecutar la inferencia en tu configuración haciendo:

lerobot-record \

--robot.type=so101_follower \

--robot.port=/dev/ttyACM0 \ # <- Use your port

--robot.id=my_blue_follower_arm \ # <- Use your robot id

--robot.cameras="{ front: {type: opencv, index_or_path: 8, width: 640, height: 480, fps: 30, fourcc: "MJPG"}}" \ # <- Use your cameras

--dataset.single_task="Grasp a lego block and put it in the bin." \ # <- Use the same task description you used in your dataset recording

--dataset.repo_id=${HF_USER}/eval_DATASET_NAME_test \ # <- This will be the dataset name on HF Hub

--dataset.episode_time_s=50 \

--dataset.num_episodes=10 \

# <- Teleop optional if you want to teleoperate in between episodes \

# --teleop.type=so100_leader \

# --teleop.port=/dev/ttyACM0 \

# --teleop.id=my_red_leader_arm \

--policy.path=HF_USER/FINETUNE_MODEL_NAME # <- Use your fine-tuned model

Dependiendo de tu configuración de evaluación, puedes configurar la duración y el número de episodios a grabar para tu suite de evaluación.

LIBERO

LIBERO es un benchmark diseñado para estudiar el aprendizaje robótico de por vida. La idea es que los robots no solo serán preentrenados una vez en una fábrica, necesitarán seguir aprendiendo y adaptándose con sus usuarios humanos a lo largo del tiempo. Esta adaptación continua se llama aprendizaje de por vida en la toma de decisiones (LLDM), y es un paso clave hacia la construcción de robots que se conviertan en verdaderos asistentes personalizados.

Evaluando con LIBERO

En LeRobot, portamos LIBERO a nuestro framework y lo usamos principalmente para evaluar SmolVLA, nuestro modelo ligero de Visión-Lenguaje-Acción.

LIBERO ahora es parte de nuestra simulación multi-eval soportada, lo que significa que puedes evaluar tus políticas ya sea en una suite única de tareas o a través de múltiples suites a la vez con solo una bandera.

Para instalar LIBERO, después de seguir las instrucciones oficiales de LeRobot, simplemente haz: pip install -e ".[libero]"

Evaluación de suite única

Evalúa una política en una suite de LIBERO:

lerobot-eval \

--policy.path="your-policy-id" \

--env.type=libero \

--env.task=libero_object \

--eval.batch_size=2 \

--eval.n_episodes=3

--env.taskselecciona la suite (libero_object,libero_spatial, etc.).--eval.batch_sizecontrola cuántos entornos se ejecutan en paralelo.--eval.n_episodesestablece cuántos episodios ejecutar en total.

Evaluación multi-suite

Evalúa una política a través de múltiples suites a la vez:

lerobot-eval \

--policy.path="your-policy-id" \

--env.type=libero \

--env.task=libero_object,libero_spatial \

--eval.batch_size=1 \

--eval.n_episodes=2

- Pasa una lista separada por comas a

--env.taskpara evaluación multi-suite.

Comando de entrenamiento de ejemplo

lerobot-train \

--policy.type=smolvla \

--policy.repo_id=${HF_USER}/libero-test \

--dataset.repo_id=HuggingFaceVLA/libero \

--env.type=libero \

--env.task=libero_10 \

--output_dir=./outputs/ \

--steps=100000 \

--batch_size=4 \

--eval.batch_size=1 \

--eval.n_episodes=1 \

--eval_freq=1000 \

Nota sobre renderizado

LeRobot usa MuJoCo para simulación. Necesitas configurar el backend de renderizado antes del entrenamiento o evaluación:

export MUJOCO_GL=egl→ para servidores sin cabeza (por ejemplo, HPC, nube)

Pi0

Consulta Pi0

pip install -e ".[pi]"

Entrenar

lerobot-train \

--policy.type=pi0 \

--dataset.repo_id=seeed/eval_test123 \

--job_name=pi0_training \

--output_dir=outputs/pi0_training \

--policy.pretrained_path=lerobot/pi0_base \

--policy.compile_model=true \

--policy.gradient_checkpointing=true \

--policy.dtype=bfloat16 \

--steps=20000 \

--policy.device=cuda \

--batch_size=32 \

--wandb.enable=false

Evaluar

lerobot-record \

--robot.type=so101_follower \

--robot.port=/dev/ttyACM0 \

--robot.cameras="{ front: {type: opencv, index_or_path: 0, width: 640, height: 480, fps: 30, fourcc: "MJPG"}, side: {type: opencv, index_or_path: 2, width: 640, height: 480, fps: 30,fourcc: "MJPG"}}" \

--robot.id=my_awesome_follower_arm \

--display_data=false \

--dataset.repo_id=seeed/eval_test123 \

--dataset.single_task="Put lego brick into the transparent box" \

--policy.path=outputs/pi0_training/checkpoints/last/pretrained_model

Pi0.5

Consulta Pi0.5

pip install -e ".[pi]"

Entrenar

lerobot-train \

--dataset.repo_id=seeed/eval_test123 \

--policy.type=pi05 \

--output_dir=outputs/pi05_training \

--job_name=pi05_training \

--policy.pretrained_path=lerobot/pi05_base \

--policy.compile_model=true \

--policy.gradient_checkpointing=true \

--wandb.enable=false \

--policy.dtype=bfloat16 \

--steps=3000 \

--policy.device=cuda \

--batch_size=32

Evaluar

lerobot-record \

--robot.type=so101_follower \

--robot.port=/dev/ttyACM0 \

--robot.cameras="{ front: {type: opencv, index_or_path: 0, width: 640, height: 480, fps: 30, fourcc: "MJPG"}, side: {type: opencv, index_or_path: 2, width: 640, height: 480, fps: 30,fourcc: "MJPG"}}" \

--robot.id=my_awesome_follower_arm \

--display_data=false \

--dataset.repo_id=seeed/eval_test123 \

--dataset.single_task="Put lego brick into the transparent box" \

--policy.path=outputs/pi05_training/checkpoints/last/pretrained_model

GR00T N1.5

Consulta GR00T N1.5

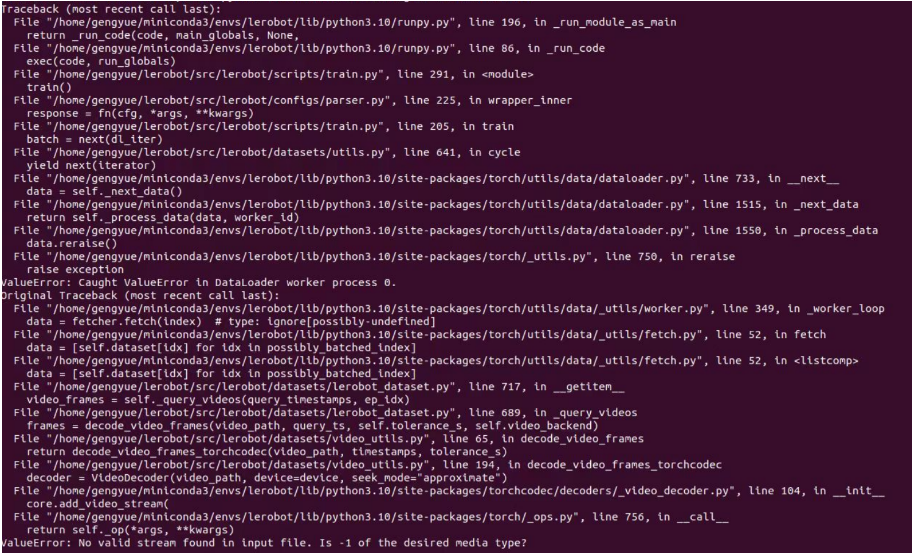

Si encuentras el siguiente error:

Intenta ejecutar el siguiente comando para resolverlo:

pip install datasets==2.19

El entrenamiento debería tomar varias horas. Encontrarás checkpoints en outputs/train/act_so100_test/checkpoints.

Para reanudar el entrenamiento desde un checkpoint, a continuación se muestra un comando de ejemplo para reanudar desde el checkpoint last de la política act_so101_test:

lerobot-train \

--config_path=outputs/train/act_so101_test/checkpoints/last/pretrained_model/train_config.json \

--resume=true

Subir checkpoints de política

Una vez que el entrenamiento esté completo, sube el último checkpoint con:

huggingface-cli upload ${HF_USER}/act_so101_test \

outputs/train/act_so101_test/checkpoints/last/pretrained_model

También puedes subir checkpoints intermedios con:

CKPT=010000

huggingface-cli upload ${HF_USER}/act_so101_test${CKPT} \

outputs/train/act_so101_test/checkpoints/${CKPT}/pretrained_model

FAQ

-

Si estás siguiendo esta documentación/tutorial, por favor clona el repositorio de GitHub recomendado

https://github.com/Seeed-Projects/lerobot.git. El repositorio recomendado en esta documentación es una versión estable verificada; el repositorio oficial de Lerobot se actualiza continuamente a la última versión, lo que puede causar problemas imprevistos como diferentes versiones de conjuntos de datos, diferentes comandos, etc. -

Si encuentras el siguiente error al calibrar los IDs de los servos:

`Motor ‘gripper’ was not found, Make sure it is connected`Por favor verifica cuidadosamente si el cable de comunicación está conectado correctamente al servo y si la fuente de alimentación está proporcionando el voltaje correcto.

-

Si encuentras:

Could not connect on port "/dev/ttyACM0"Y puedes ver que ACM0 existe al ejecutar

ls /dev/ttyACM*, significa que olvidaste otorgar permisos al puerto serie. Ingresasudo chmod 666 /dev/ttyACM*en la terminal para solucionarlo. -

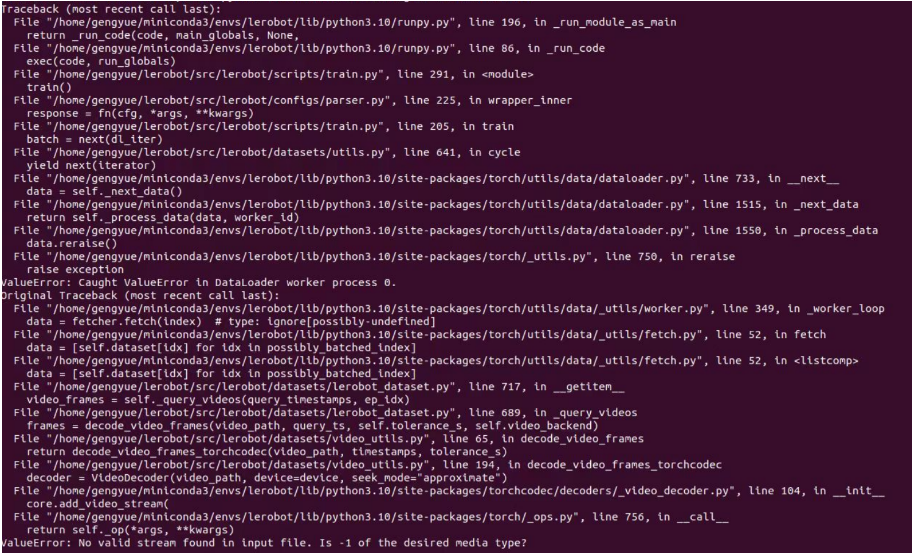

Si encuentras:

No valid stream found in input file. Is -1 of the desired media type?Por favor instala ffmpeg 7.1.1 usando

conda install ffmpeg=7.1.1 -c conda-forge.

-

Si encuentras:

ConnectionError: Failed to sync read 'Present_Position' on ids=[1,2,3,4,5,6] after 1 tries. [TxRxResult] There is no status packet!Necesitas verificar si el brazo robótico en el puerto correspondiente está encendido, y si los cables de datos de los servos del bus están sueltos o desconectados. Si la luz de un servo no está encendida, significa que el cable del servo anterior está suelto.

-

Si encuentras el siguiente error al calibrar el brazo robótico:

Magnitude 30841 exceeds 2047 (max for sign_bit_index=11)Apaga y reinicia el brazo robótico, luego intenta calibrar nuevamente. Este método también se puede usar si el ángulo MAX alcanza un valor de decenas de miles durante la calibración. Si esto no funciona, necesitas recalibrar los servos correspondientes, incluyendo la calibración mediana y la escritura de ID.

-

Si encuentras durante la fase de evaluación:

File exists: 'home/xxxx/.cache/huggingface/lerobot/xxxxx/seeed/eval_xxxx'Por favor elimina primero la carpeta que comience con

eval_y luego ejecuta el programa nuevamente. -

Si encuentras durante la fase de evaluación:

`mean` is infinity. You should either initialize with `stats` as an argument or use a pretrained modelPor favor ten en cuenta que las palabras clave como "front" y "side" en el parámetro

--robot.camerasdeben ser estrictamente consistentes con las utilizadas al recopilar el conjunto de datos. -

Si has reparado o reemplazado partes del brazo robótico, por favor elimina completamente los archivos bajo

~/.cache/huggingface/lerobot/calibration/robotso~/.cache/huggingface/lerobot/calibration/teleoperatorsy recalibra el brazo robótico. De lo contrario, pueden aparecer mensajes de error, ya que la información de calibración se almacena en archivos JSON en estos directorios. -

Entrenar ACT en 50 conjuntos de datos toma aproximadamente 6 horas en una laptop con RTX 3060 (8GB), y alrededor de 2-3 horas en computadoras con GPUs RTX 4090 o A100.

-

Durante la recopilación de datos, asegúrate de que la posición de la cámara, el ángulo y la iluminación ambiental sean estables. Reduce la cantidad de fondo inestable y peatones capturados por la cámara, ya que cambios excesivos en el entorno de despliegue pueden causar que el brazo robótico falle al agarrar correctamente.

-

Para el comando de recopilación de datos, asegúrate de que el parámetro

num-episodesesté configurado para recopilar datos suficientes. No pauses manualmente a la mitad, ya que la media y la varianza de los datos se calculan solo después de que la recopilación de datos esté completa, las cuales son necesarias para el entrenamiento. -

Si el programa indica que no puede leer datos de imagen de la cámara USB, asegúrate de que la cámara USB no esté conectada a través de un hub. La cámara USB debe estar conectada directamente al dispositivo para garantizar una velocidad de transmisión de imagen rápida.

-

Si encuentras un error como

AttributeError: module 'rerun' has no attribute 'scalar'. Did you mean: 'scalars'?, puedes degradar la versión de rerun para resolver el problema.

pip3 install rerun-sdk==0.23

Si encuentras problemas de software o problemas de dependencias del entorno que no se pueden resolver, además de verificar la sección FAQ al final de este tutorial, por favor reporta el problema oportunamente a la plataforma LeRobot o al canal de Discord de LeRobot.

Citas

Proyecto TheRobotStudio: SO-ARM10x

Proyecto Huggingface: Lerobot

Dnsty: Jetson Containers

Soporte Técnico y Discusión de Productos

¡Gracias por elegir nuestros productos! Estamos aquí para brindarte diferentes tipos de soporte para asegurar que tu experiencia con nuestros productos sea lo más fluida posible. Ofrecemos varios canales de comunicación para satisfacer diferentes preferencias y necesidades.