カスタムローカルLLM:JetsonでLlama-FactoryによるLLMファインチューニング

はじめに

🚀JetsonでLlama-FactoryによるLLMファインチューニング!これで要件に合わせてカスタムプライベートローカルLLMを調整できます。

Llama-Factoryは、一般的な大規模言語モデル、データセット、ファインチューニング手法をサポートする非常に便利な大規模言語モデルファインチューニングツールを提供します。このプラットフォームを使用することで、プライベート大規模言語モデルを簡単にカスタマイズできます。

このwikiでは、Nvidia JetsonにLlama-Factoryをデプロイし、Llama-Factoryを使用して中国語Q&Aをサポートする大規模言語モデルを訓練する方法を学びます。

前提条件

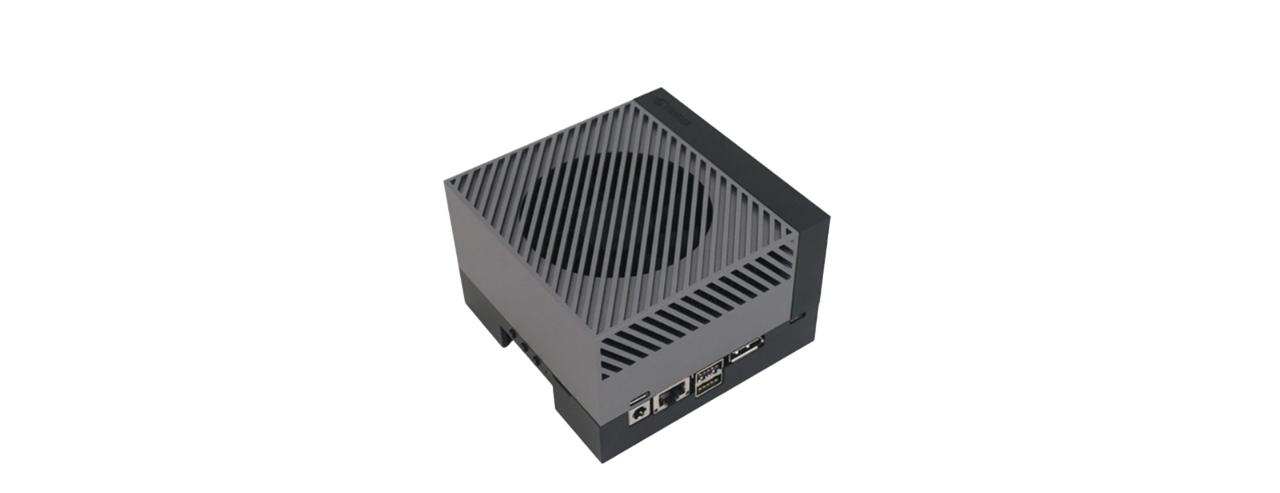

- 16GB以上のメモリを持つJetsonデバイス。

- モニター、マウス、キーボード、ネットワーク。(必須ではありません)

このwikiの実現可能性は、reComputer Orin NX 16GBとAGX Orin 64GB Developer Kitですでにテスト済みです。

はじめに

ハードウェア接続

- EthernetケーブルをreComputer(Jetson搭載)に接続します。

- マウス、キーボード、モニターをreComputerに接続します。

- reComputerの電源を入れます。

Jetson-Examplesのインストール

Seeed Studioのjetson-examplesは、NVIDIA Jetsonプラットフォーム上でビジョンAIと生成AIモデルを実行するためのシームレスなワンラインコマンドデプロイメントを提供します。

パッケージをインストールするには、Jetsonでターミナルを開いて以下を実行してください:

pip3 install jetson-examples

sudo reboot

JetsonでLlama-Factoryをインストールして実行する

jetson-examplesを使用してLlama-Factoryをワンラインでデプロイ:

reComputer run llama-factory

その後、Webブラウザを開いてアドレスにアクセスし、WebUIを開くことができます:

# http://<jetson-ip>:7860

http://127.0.0.1:7860

トレーニング開始

ここでは、alpaca_zh データセットを使用して Phi-1.5 モデルをファインチューニングし、中国語での会話能力を持たせます。そのため、Web UI では、トレーニングの Model name と Dataset のみを設定し、その他のトレーニングパラメータはデフォルトのままにします。

最後に、start ボタンをクリックしてトレーニングを開始します。

トレーニングプロセスには約18時間かかります。

ファインチューニングが完了すると、保存ディレクトリでファインチューニングされたモデルを見つけることができます。

ファインチューニングされたモデルのテスト

最後に、ファインチューニングされたモデルでLlama-Factoryを使用して、実際に中国語での会話能力を獲得したかどうかをテストできます。具体的な手順は以下の通りです。

ステップ1. Llama-Factory WebUIでファインチューニングされたモデルを読み込みます。

ステップ2. Input テキストボックスに中国語のプロンプトを入力し、Submit ボタンをクリックして、Chatbot テキストボックスで大規模言語モデルの出力結果を確認します。

テスト結果から、ファインチューニングされたモデルがすでに中国語で人間と会話する能力を持っていることがわかります。モデルにより高度な能力を持たせたい場合は、より多様なファインチューニングデータセットを使用してモデルをトレーニングしてみてください!

デモンストレーション

参考文献

- https://github.com/hiyouga/LLaMA-Factory

- https://github.com/dusty-nv/jetson-containers

- https://github.com/Seeed-Projects/jetson-examples

技術サポート & 製品ディスカッション

私たちの製品をお選びいただき、ありがとうございます!私たちの製品での体験ができるだけスムーズになるよう、さまざまなサポートを提供しています。異なる好みやニーズに対応するため、複数のコミュニケーションチャンネルを提供しています。