Edge Impulseを使用したワンストップモデルトレーニング

概要

このwikiでは、Edge Impulseを使用して特定のアプリケーション向けの独自のAIモデルをトレーニングし、SenseCAP A1101 - LoRaWAN Vision AI Sensorに簡単にデプロイする方法を説明します。始めましょう!

**Edge Impulseとは?**Edge Impulseは、あらゆるエッジデバイスで最適化されたモデルを構築するエンタープライズチーム向けのエッジAIプラットフォームです。高度なAIセンサー機能により、より迅速な価値提供と製品イノベーションの実現を可能にします。

ハードウェアの準備

Seeed SenseCAP A1101 - LoRaWAN Vision AI Sensorは、開発者向けに設計された画像認識AIセンサーです。SenseCAP A1101 - LoRaWAN Vision AI Sensorは、TinyML AI技術とLoRaWAN長距離伝送を組み合わせ、屋内外での使用に対応した低消費電力・高性能AIデバイスソリューションを実現します。

このセンサーは、Google TensorFlow Liteフレームワークと複数のTinyML AIプラットフォームをサポートするHimaxの高性能・低消費電力AIビジョンソリューションを特徴としています。

Edge Impulseによって完全にサポートされており、カメラから生データをサンプリングし、モデルを構築し、トレーニング済み機械学習モデルをプログラミング不要でスタジオから直接モジュールにデプロイできます。SenseCAP - Vision AI ModuleはSeeed Studio Bazaarから直接購入できます。

- SenseCAP A1101 - LoRaWAN Vision AI Sensor

- USB Type-Cケーブル

- インターネットアクセス可能なWindows/ Linux/ Mac

ソフトウェアの準備

Edge ImpulseでこのA1101をセットアップするには、以下のソフトウェアをインストールする必要があります:

- Edge Impulse CLI

- Linuxの場合:

- GNU Screen:例えば

sudo apt install screenでインストール

- GNU Screen:例えば

- 最新のBouffalo Lab Dev Cubeをダウンロード

Edge Impulse CLIのインストールに問題がありますか? インストールとトラブルシューティングガイドを参照してください。

Edge Impulseへの接続

すべてのソフトウェアが準備できたら、A1101をEdge Impulseに接続します。

2023年3月30日以降にデバイスを購入した場合、EIのファームウェアを更新する必要はありません。直接STEP3キーの設定にジャンプしてください。EIのファームウェアを更新すると、デフォルトモデルが上書きされることにご注意ください。

ステップ1. BL702チップファームウェアの更新

BL702は、PCとHimaxチップ間の通信を可能にするUSB-UARTチップです。Edge Impulseファームウェアが正常に動作するために、このファームウェアを更新する必要があります。

-

こちらから最新のブートローダーファームウェアを取得:tinyuf2-sensecap_vision_ai_xxx.bin

-

A1101のBootボタンを押しながら、USB Type-CケーブルでA1101をPCに接続します。

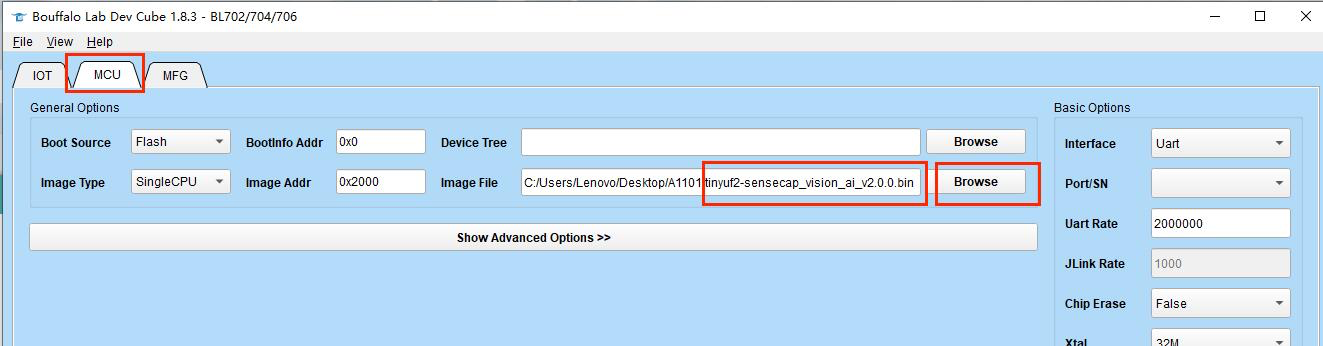

- 事前にインストールしたBouffalo Lab Dev Cubeソフトウェアを開き、BL702/704/706を選択し、Finishをクリックします。

- MCUタブに移動します。Image fileの下でBrowseをクリックし、ダウンロードしたファームウェアを選択します。

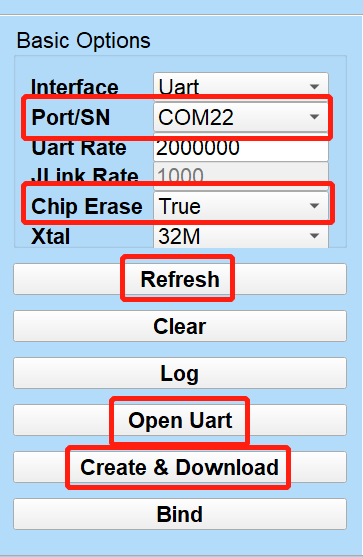

- Refreshをクリックし、接続されたA1101に関連するPortを選択し、Chip EraseをTrueに設定し、Open UARTをクリックし、Create & Downloadをクリックしてプロセスが完了するまで待ちます。

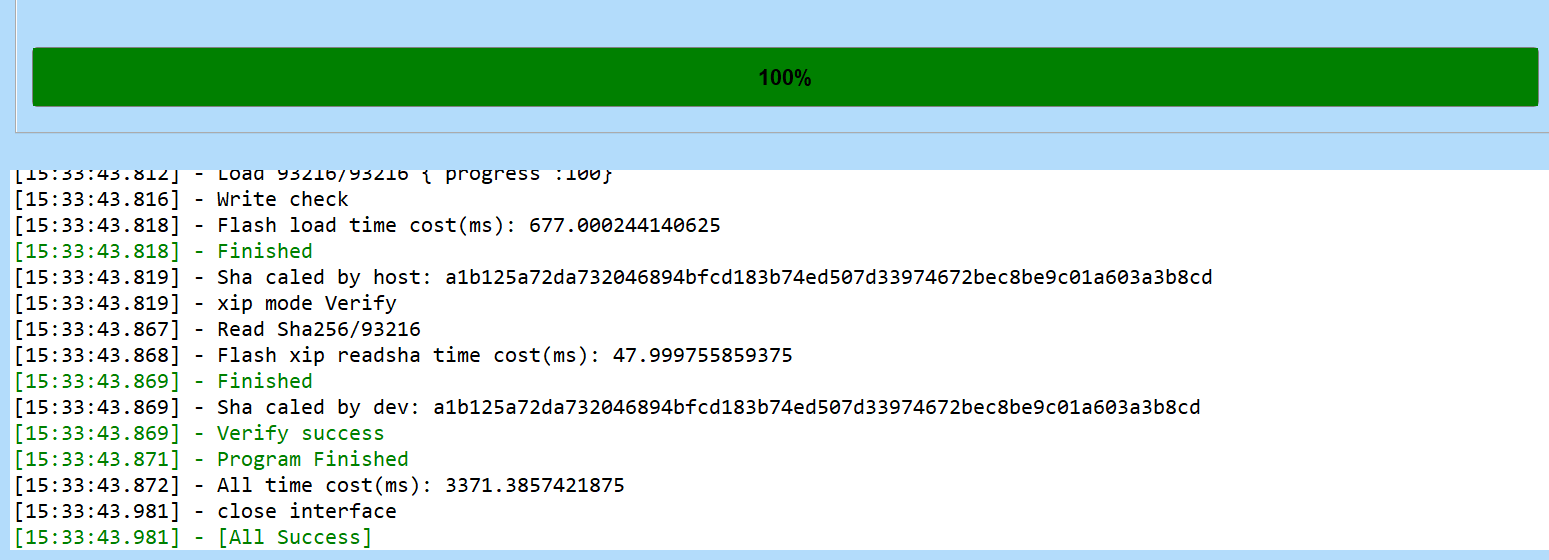

正常に完了すると、All Successとして出力が表示されます。

フラッシュでエラーが発生した場合は、All Successメッセージが表示されるまでCreate & Downloadを複数回クリックしてみてください。

ステップ2. Edge Impulseファームウェアの更新

A1101には適切なEdge Impulseファームウェアがまだ搭載されていません。ファームウェアを更新するには:

-

最新のEdge Impulseファームウェアをダウンロードし、解凍してfirmware.uf2ファイルを取得します。

-

USB Type-CケーブルでA1101を再度PCに接続し、A1101のBootボタンをダブルクリックしてマスストレージモードに入ります。

-

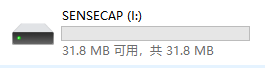

その後、ファイルエクスプローラーにSENSECAPとして新しいストレージドライブが表示されます。firmware.uf2ファイルをSENSECAPドライブにドラッグアンドドロップします。

コピーが完了するとSENSECAPドライブが消えます。これがコピーが成功したかどうかを確認する方法です。

ステップ3. キーの設定

コマンドプロンプトまたはターミナルから、以下を実行します:

edge-impulse-daemon

これにより、ログインしてEdge Impulseプロジェクトを選択するよう求めるウィザードが開始されます。プロジェクトを切り替えたい場合は、--cleanオプションを付けてコマンドを実行してください。

また、Google ChromeやMicrosoft Edgeの最新バージョンでは、Edge Impulse CLIを使用せずに、A1101から直接データを収集することができます。詳細についてはこのブログ記事をご覧ください。

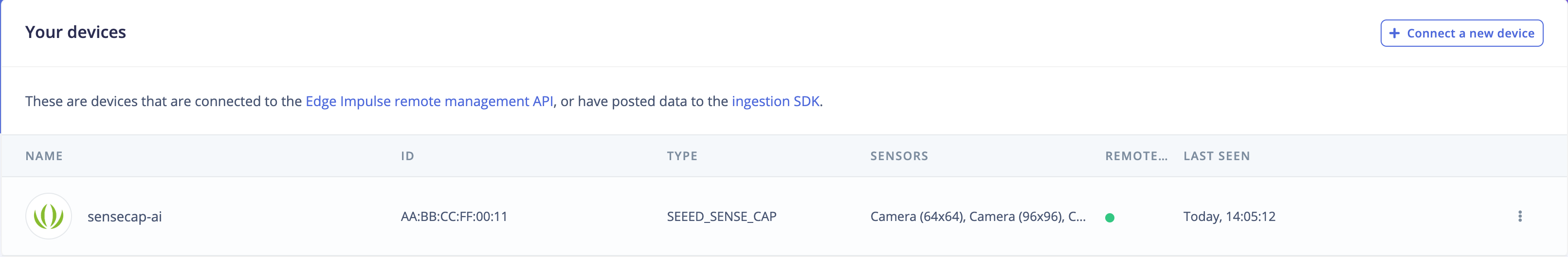

ステップ4. デバイスが接続されていることを確認する

以上です!デバイスがEdge Impulseに接続されました。これを確認するには、Edge Impulseプロジェクトにアクセスし、Devicesをクリックしてください。デバイスがここに表示されます。

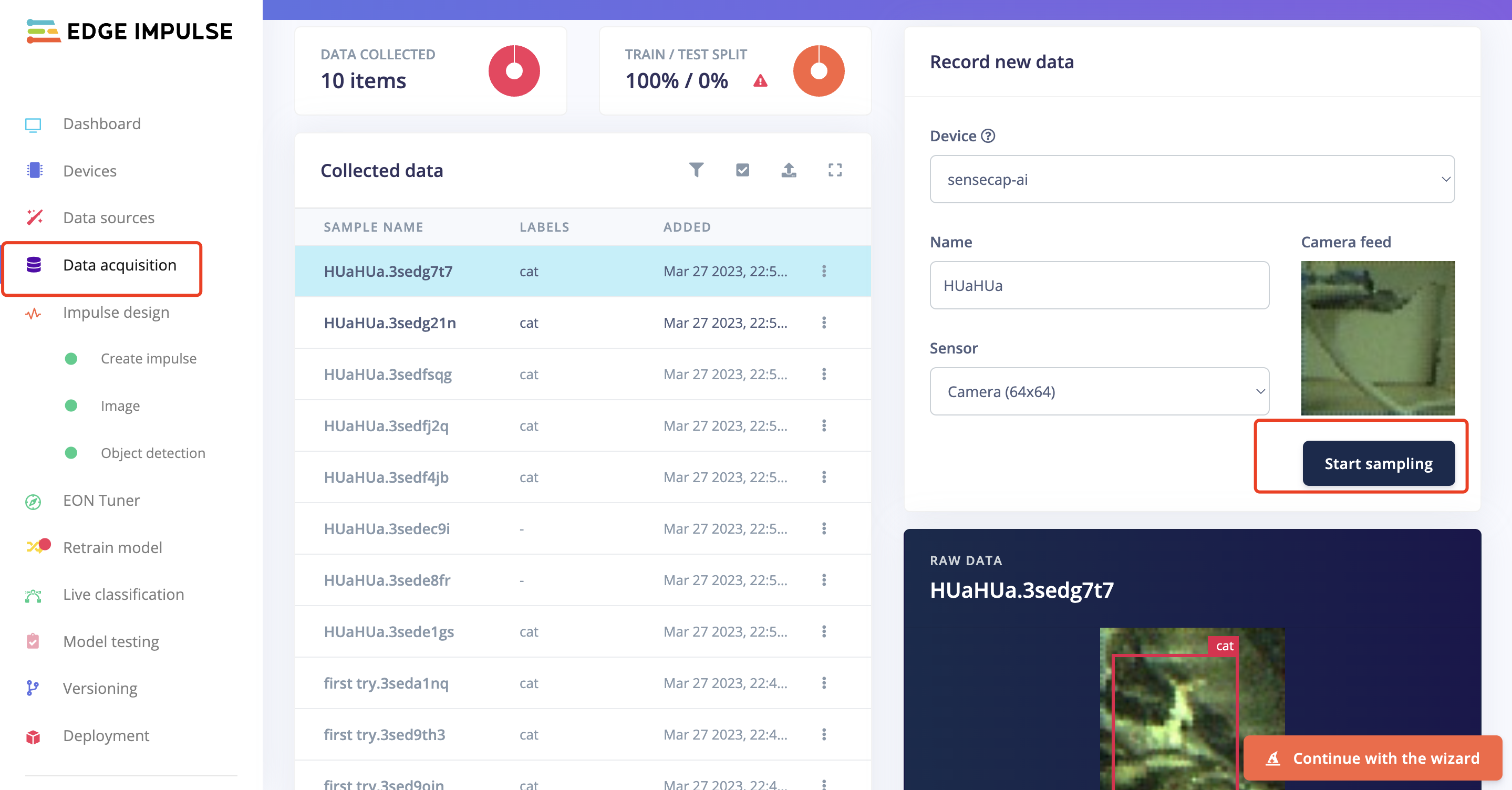

A1101 - Vision AIからのデータ収集

すべての設定が完了したら、以下のチュートリアルで初めての機械学習モデルを構築して実行できます:

オンボードカメラからのフレームは、スタジオから直接キャプチャできます:

最後に、モデルがトレーニングされると、A1101 – Vision AIモジュールに簡単にデプロイして推論を開始できます!

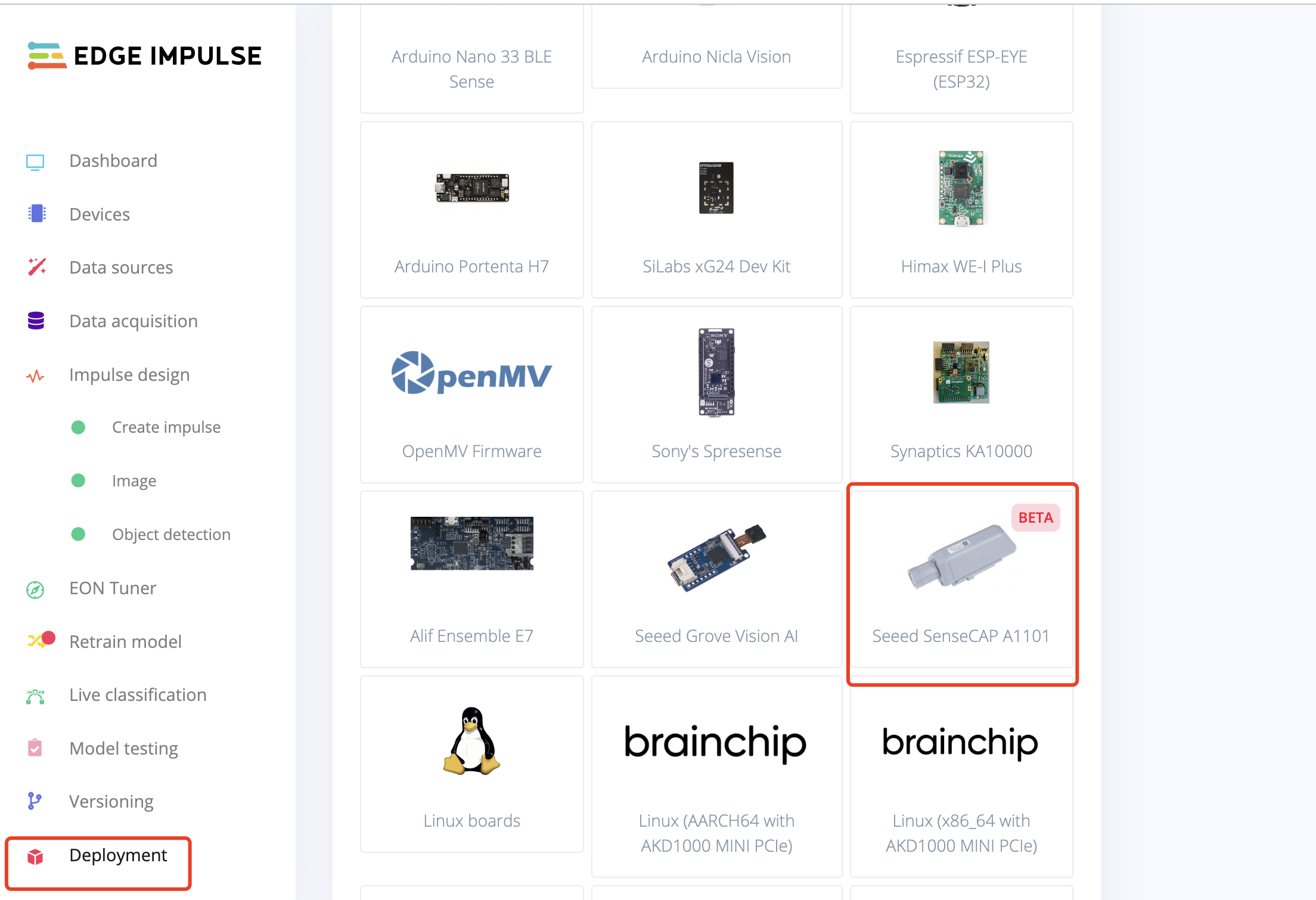

A1101 - Vision AIへのモデルデプロイ

機械学習モデルを構築し、Edge Impulse StudioからEdge Impulseファームウェアをダウンロードした後、Edge Impulseファームウェア更新セクションのステップ1と2に従って、モデルuf2をSenseCAP - Vision AIにデプロイします。 EDGE IMPULSEからfirmware.uf2ファイルをSENSECAPドライブにドラッグアンドドロップしてください。

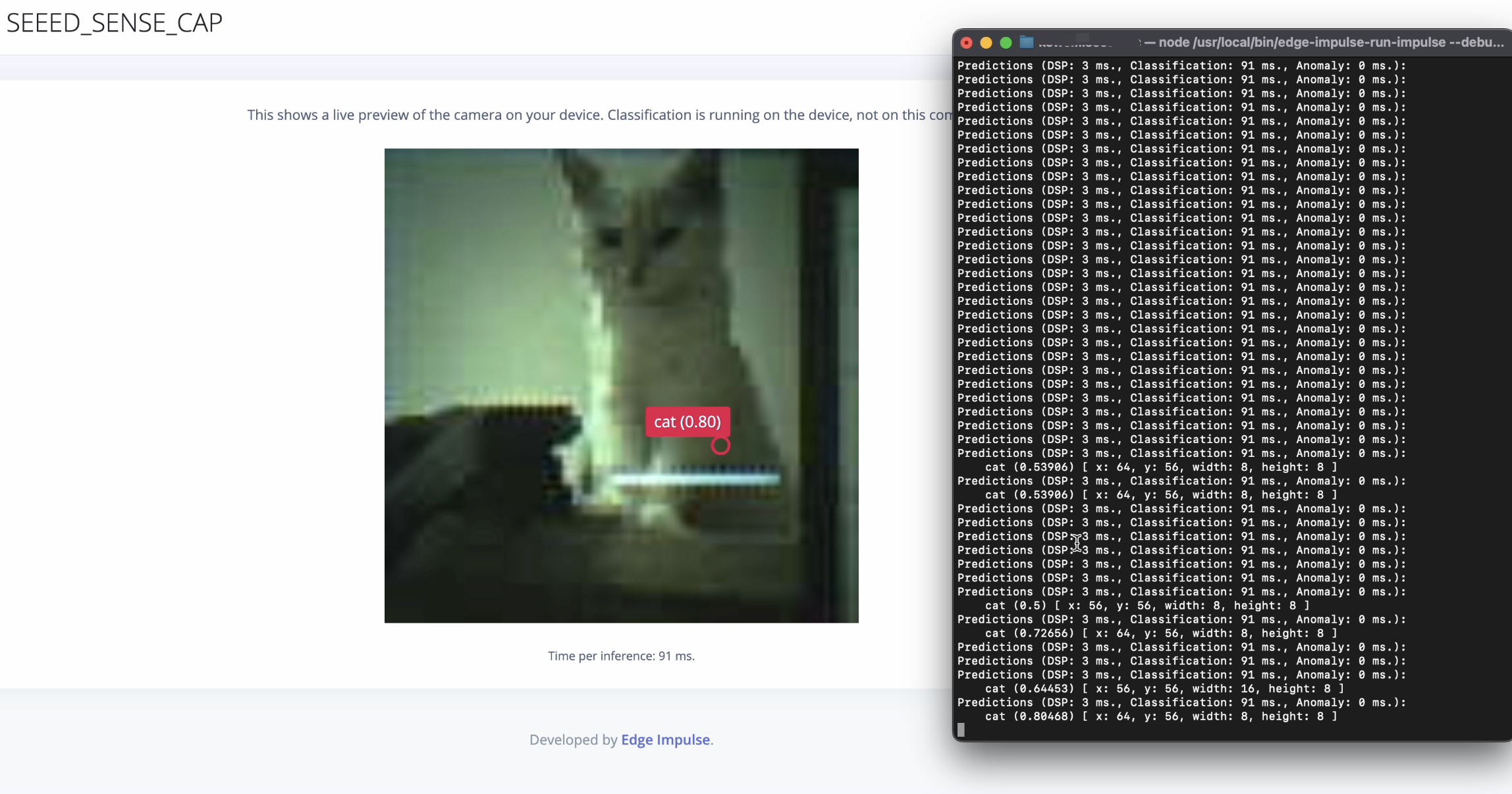

ローカルインターフェースでこれを実行すると:

edge-impulse-daemon --debug

URLをクリックするよう求められ、デバイス上でカメラのライブプレビューが表示されます。

SenseCap Mateでモデルを設定する

- SenseCAP Mateをダウンロード

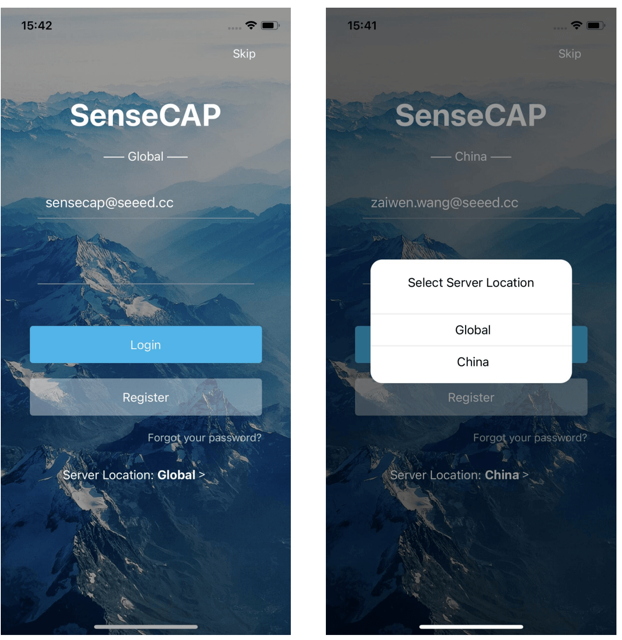

- SenseCAP Mateを開いてログイン

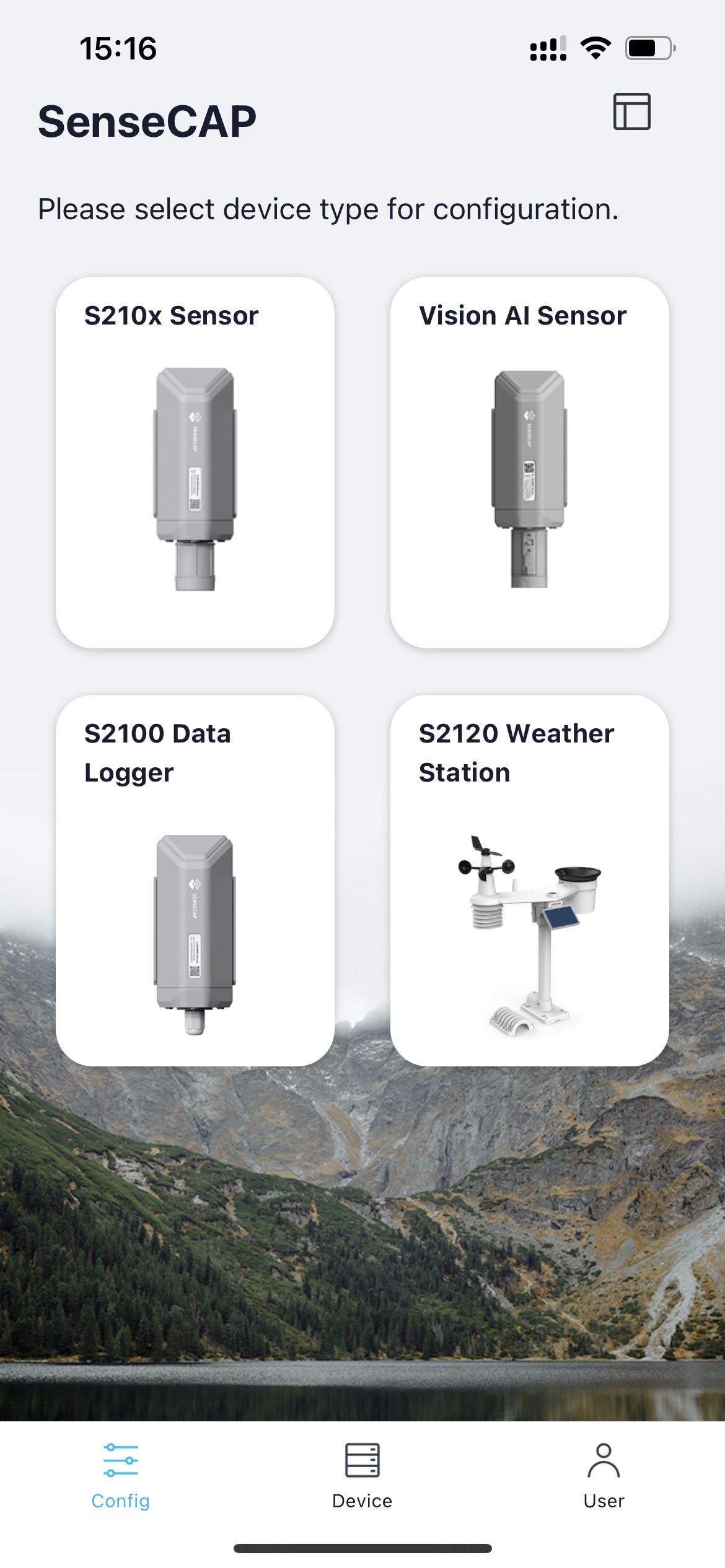

- Config画面で、Vision AI Sensorを選択

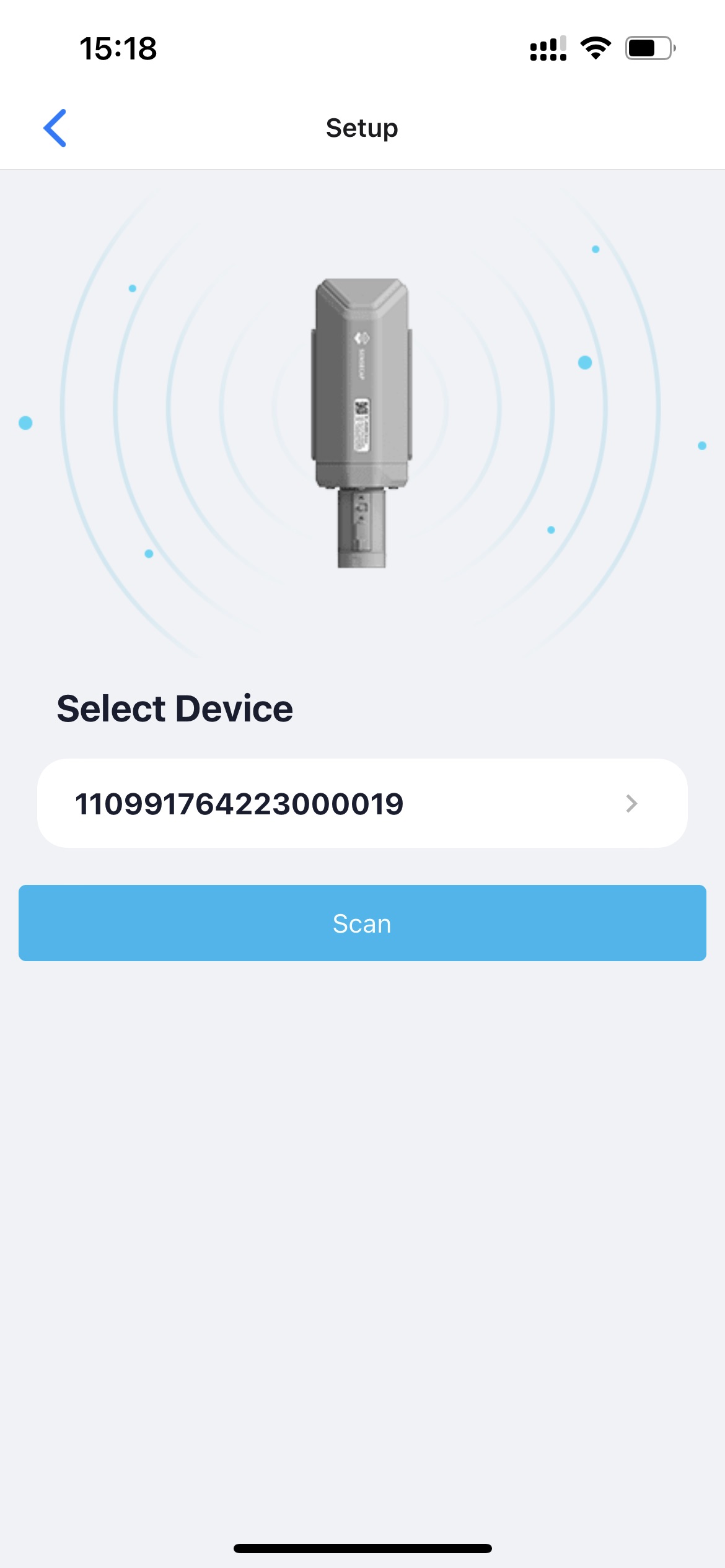

- SenseCap A1101の設定ボタンを3秒間長押しして、Bluetoothペアリングモードに入る

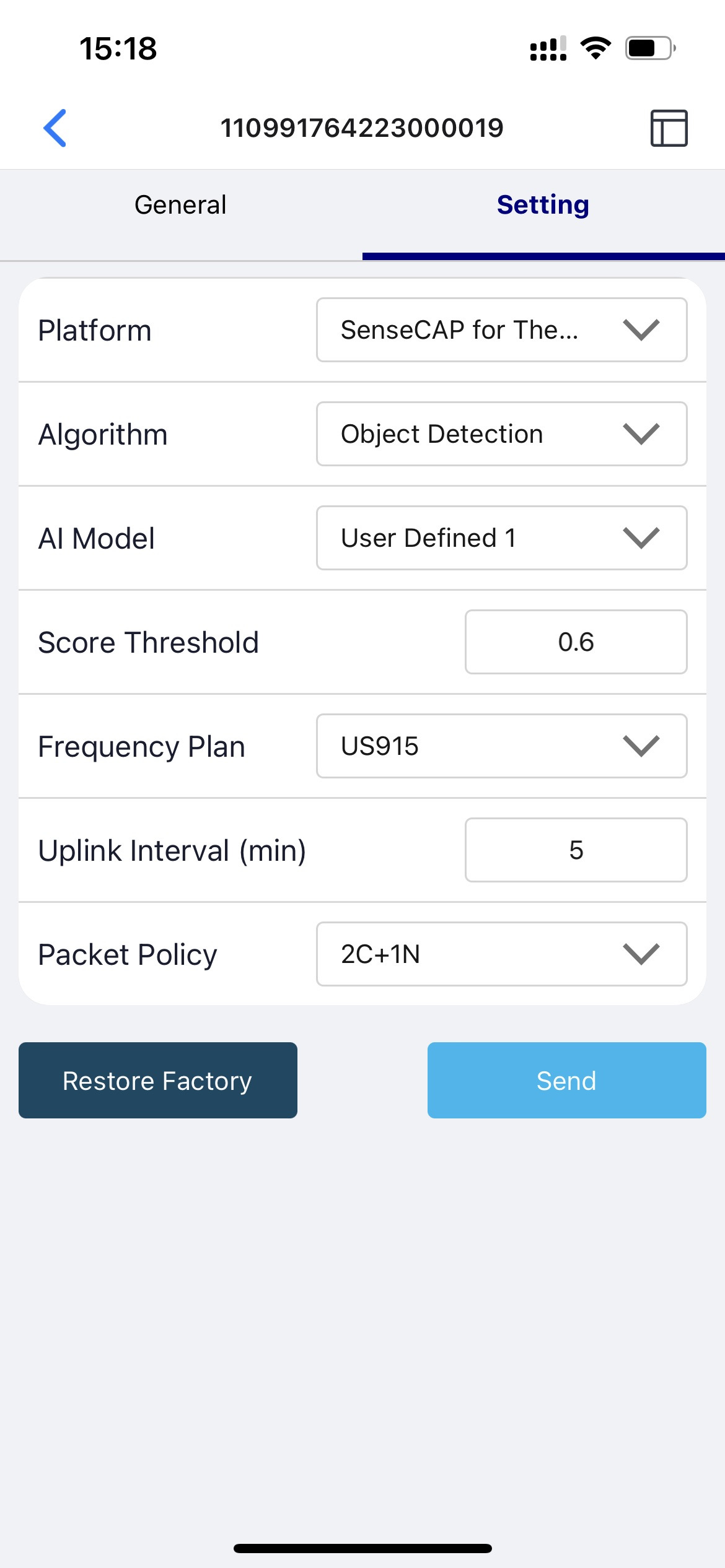

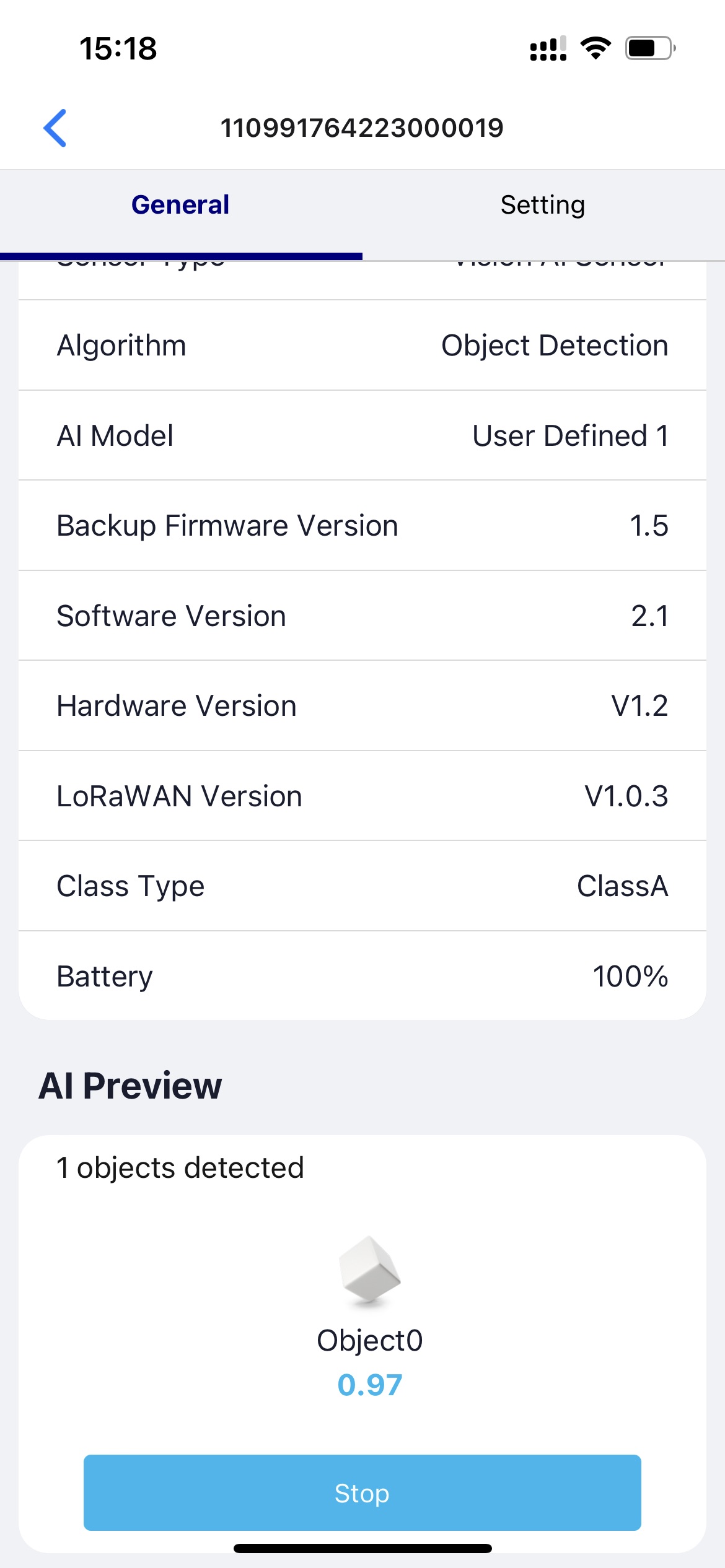

- Setupをクリックすると、近くのSenseCAP A1101デバイスのスキャンが開始されます- Settingsに移動し、Object DetectionとUser Defined 1が選択されていることを確認してください。選択されていない場合は、選択してSendをクリック

- Generalに移動し、Detectをクリック

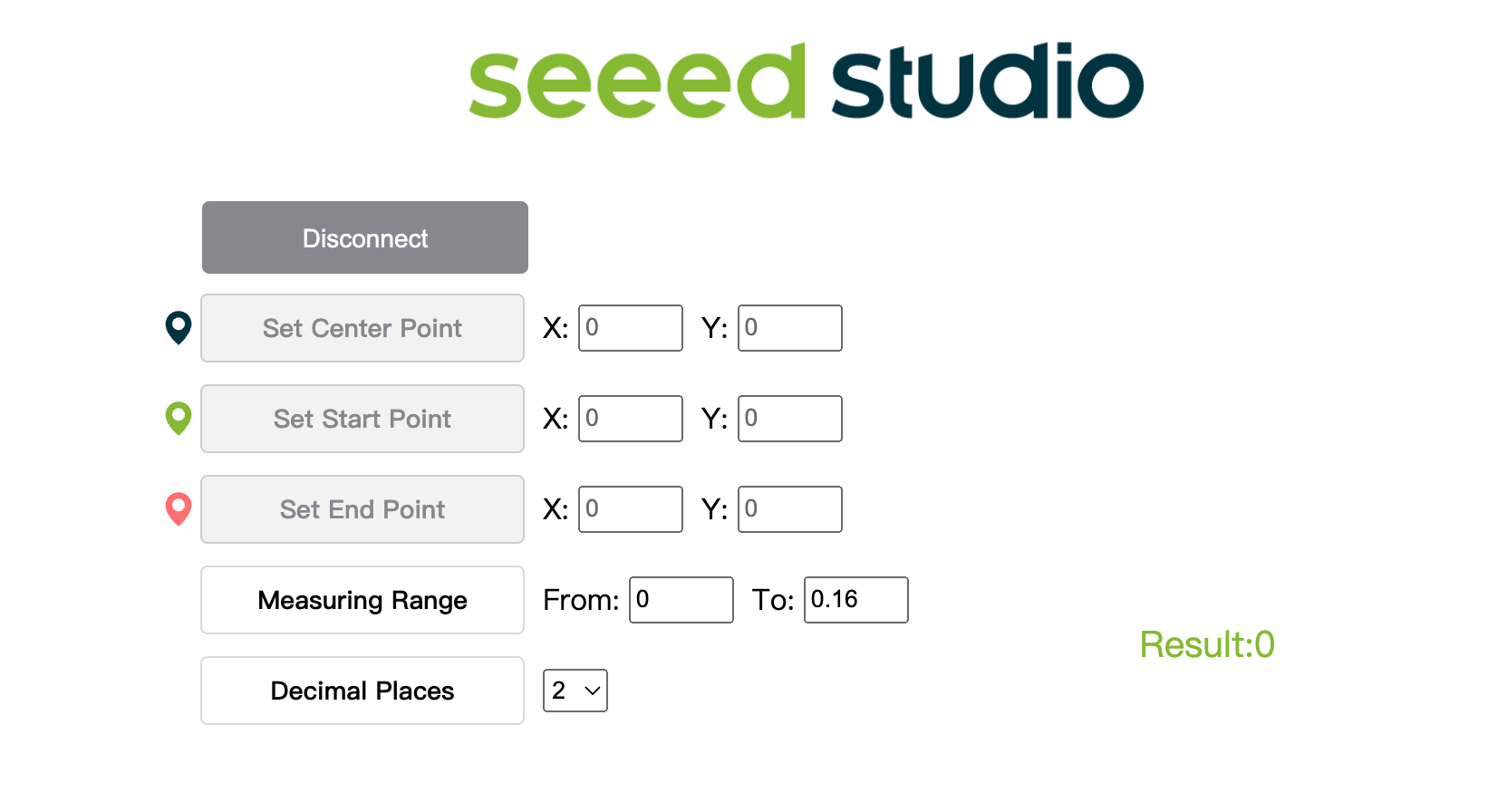

- こちらをクリックしてカメラストリームのプレビューウィンドウを開く

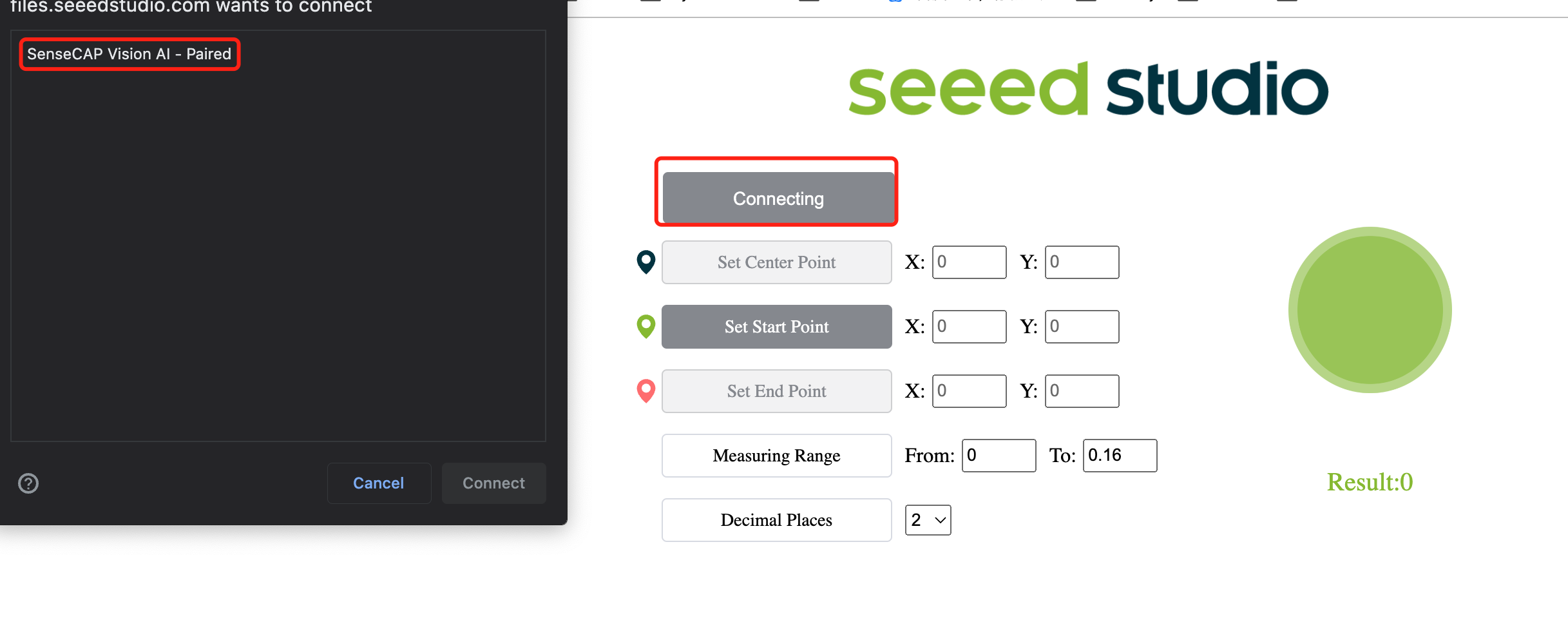

- Connectボタンをクリック。ブラウザにポップアップが表示されます。SenseCAP Vision AI - Pairedを選択し、Connectをクリック

- プレビューウィンドウを使用してリアルタイム推論結果を表示!

例えば、上記のように、猫がバウンディングボックスで囲まれて検出されています。ここで「0」は同じクラスの各検出に対応しています。複数のクラスがある場合、0、1、2、3、4などと名前が付けられます。また、検出された各りんごの信頼度スコア(上記のデモでは0.72)も表示されています!

技術サポート & 製品ディスカッション

弊社製品をお選びいただき、ありがとうございます!弊社製品での体験が可能な限りスムーズになるよう、さまざまなサポートを提供しています。さまざまな好みやニーズに対応するため、複数のコミュニケーションチャネルを提供しています。