reComputer Jetson に Live VLM WebUI をデプロイする

はじめに

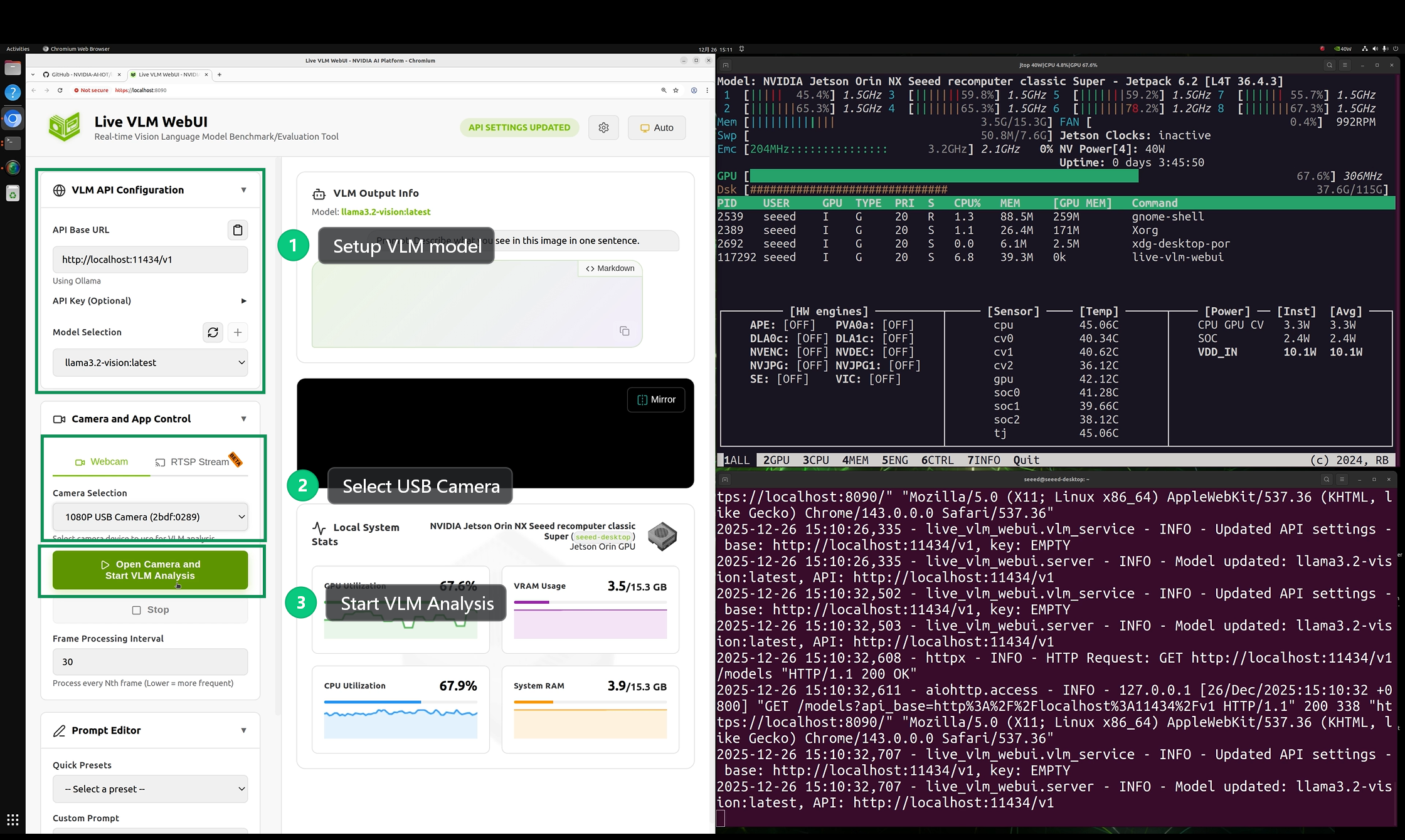

Live VLM WebUI は、リアルタイムの Vision Language Model インタラクションとベンチマーキングのための汎用ウェブインターフェースです。ウェブカメラを任意の VLM にストリーミングし、ライブ AI 駆動分析を取得できます - モデルのテスト、パフォーマンスのベンチマーク、複数のドメインとハードウェアプラットフォームにわたるビジョン AI 機能の探索に最適です。

この Wiki では、reComputer Super J4012 に Live VLM WebUI をデプロイする方法を説明します。

前提条件

- reComputer Super J4012

- USB カメラ

Jetson デバイスに Jetpack 6.2 オペレーティングシステムがインストールされていることを確認してください。

ソフトウェアを設定する前に、USB カメラを reComputer Super J4012 の Type-A ポートに接続してください。

Live VLM WebUI のデプロイ

ステップ1. reComputer Jetson に ollama をインストールして実行します。

reComputer Jetson のターミナルウィンドウで以下のコマンドを実行します。

curl -fsSL https://ollama.com/install.sh | sh

ollama pull llama3.2-vision:11b

モデルのダウンロードには約10分かかります。しばらくお待ちください。

ステップ2. Live VLM WebUI をインストールします。

reComputer Jetson のターミナルウィンドウで以下のコマンドを実行します。

# Install dependencies

sudo apt install openssl python3-pip

# Install the package

python3 -m pip install --user live-vlm-webui

# Add to PATH (one-time setup)

echo 'export PATH="$HOME/.local/bin:$PATH"' >> ~/.bashrc

source ~/.bashrc

# Run it

live-vlm-webui

ステップ3. Live VLM WebUI を設定して起動します。

アプリケーションが正常に実行されると、ブラウザで https://localhost:8090 を入力して WebUI を開くことができます。

- VLM API Configuration で、

ollama推論エンジンと先ほどダウンロードしたllama3.2-visionモデルを選択します。 - Camera and App Control で、

USB Cameraを選択します。 - Run ボタンをクリックした後、バックエンドからの推論結果を待つことができます。

効果のデモンストレーション

ワークフロー全体は、16GB のメモリを持つ reComputer Super J4012 デバイスで正常に実行できます。ただし、実際のテストでは、推論速度が非常に遅いことがわかりました。

参考文献

技術サポートと製品ディスカッション

弊社製品をお選びいただき、ありがとうございます!弊社製品での体験が可能な限りスムーズになるよう、さまざまなサポートを提供しています。さまざまな好みやニーズに対応するため、複数のコミュニケーションチャンネルを提供しています。