Reachy Mini用reComputer Miniにローカル音声LLMをデプロイ!

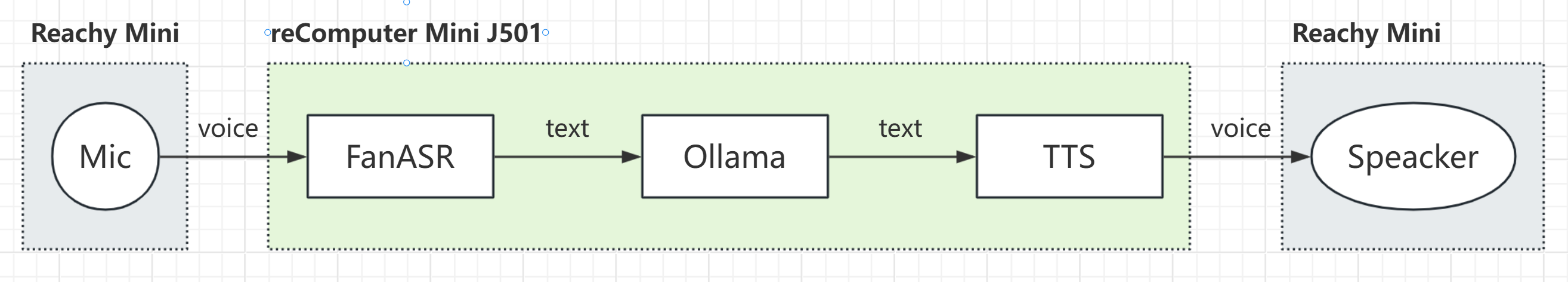

ダブルミニ!このプロジェクトでは、完全にローカライズされた、低遅延、高プライバシーの音声対話型ロボットアシスタントシステムを構築します。reComputer Mini J501エッジコンピューティングデバイスを中心として、ローカル音声認識、大規模言語モデル、音声合成サービスをデプロイします。オープンソースロボットプラットフォームReachy Miniを人間とコンピューターの相互作用の物理的端末として使用し、知覚的、会話的、行動的な具現化されたインテリジェント対話体験を実現します。

前提条件

- reComputer Mini J501 Kit

- Reachy Mini Lite

ソフトウェアを設定する前に、Reachy MiniをreComputer Mini J501のType-Aポートに接続してください。

ソフトウェアアプリケーションのデプロイ

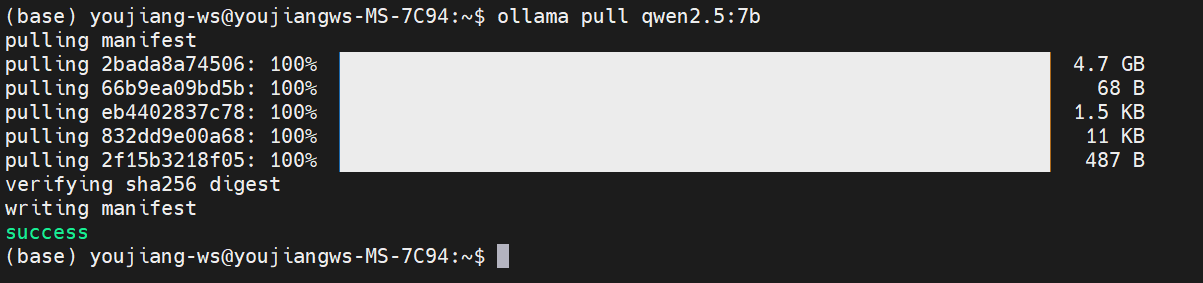

ステップ1. reComputer JetsonにOllama推論サーバーをインストールして実行します。

reComputer Jetsonのターミナルウィンドウ(Ctrl + Alt + T)で以下のコマンドを実行します。

# Install Ollama (visit https://ollama.ai for platform-specific instructions)

curl -fsSL https://ollama.com/install.sh | sh

# Pull the required model

ollama pull llama3.2-vision:11b

モデルのダウンロードには約10分かかります。しばらくお待ちください。

ステップ2. 会話アプリケーションをインストールします。

reComputer Jetsonのターミナルウィンドウで以下のコマンドを実行します。

conda仮想環境でランタイム環境を設定したい場合は、以下のインストールコマンドを実行する前にconda activate <name>コマンドを使用してターゲット環境をアクティベートしてください。

cd Downloads

git clone https://github.com/Seeed-Projects/reachy-mini-loacl-conversation.git

cd reachy-mini-loacl-conversation

pip install -r requirements.txt -i https://pypi.jetson-ai-lab.io/

pip install "reachy-mini"

詳細なインストール情報についてはこちらを参照してください。

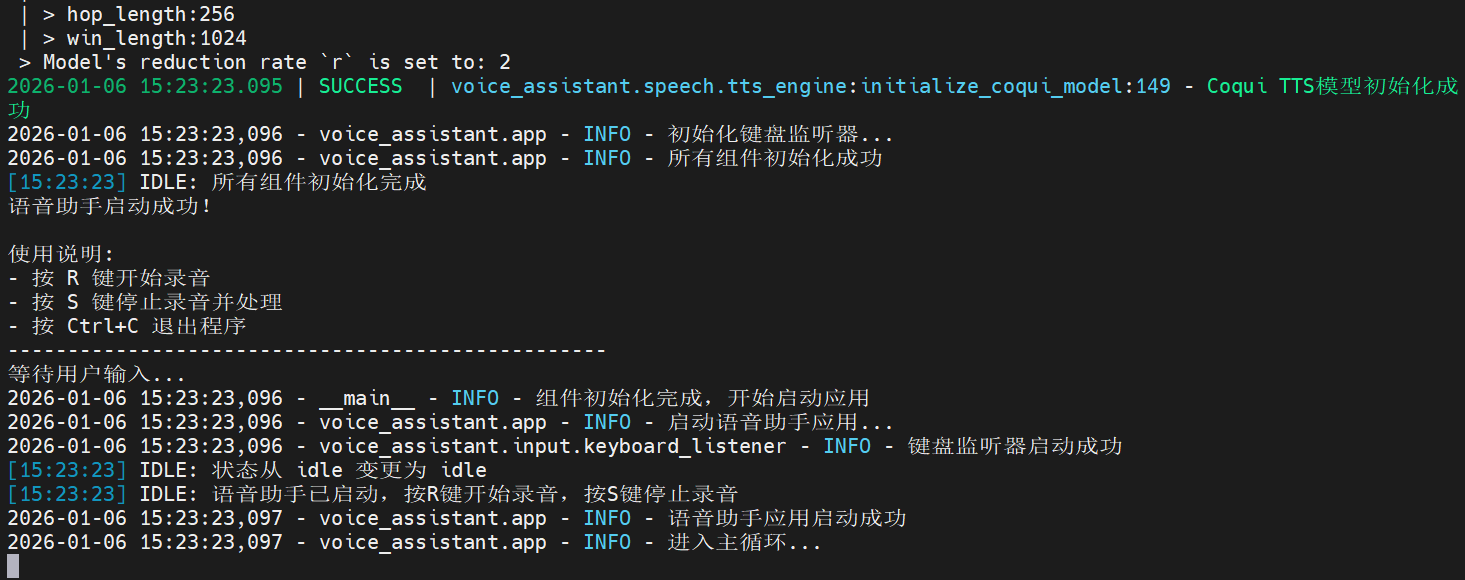

ステップ3. アプリケーションを起動します。

reComputer Jetsonのターミナルウィンドウで以下のコマンドを実行してreachy miniデーモンを起動します。

reachy-mini-daemon

別のターミナルを開いて実行します:

# Set environment variables

export OLLAMA_HOST="http://localhost:11434"

export OLLAMA_MODEL="qwen2.5:7b"

export COQUI_MODEL_NAME="tts_models/zh-CN/baker/tacotron2-DDC-GST"

export DEFAULT_VOLUME="1.5"

# Start the voice assistant

python main.py

ここでは、デモンストレーション用に中国語モデルを使用しています。必要に応じて他の言語のモデルに置き換えることができます。

効果のデモンストレーション

プログラムが正常に開始された後、キーボードのRキーとSキーを使用して録音の開始と停止を制御できます。録音が停止されると、プログラムはローカル大規模言語モデルを呼び出して応答を生成します。

参考文献

- https://ollama.com/download/linux

- https://github.com/modelscope/FunASR

- https://github.com/coqui-ai/TTS

- https://github.com/Seeed-Projects/reachy-mini-loacl-conversation/

技術サポート & 製品ディスカッション

私たちの製品をお選びいただき、ありがとうございます!私たちは、お客様の製品体験が可能な限りスムーズになるよう、さまざまなサポートを提供しています。異なる好みやニーズに対応するため、複数のコミュニケーションチャネルを提供しています。