XIAO ESP32S3 Sense & Edge Impulse キーワードスポッティング

このチュートリアルでは、XIAO ESP32S3 Sense マイクロコントローラーボード上で TinyML を使用してキーワードスポッティング(KWS)システムを実装する方法を説明します。データ収集とモデル訓練には Edge Impulse を使用します。KWS は音声認識システムにとって不可欠であり、TinyML の力により、より小型で低消費電力のデバイスでも実現可能です。Edge Impulse と XIAO ESP32S3 Sense を使用して独自の KWS システムを構築しましょう!

はじめに

このプロジェクトを開始する前に、以下の準備手順に従って、このプロジェクトに必要なソフトウェアとハードウェアを準備してください。

ハードウェア

このプロジェクトを成功させるために、以下のハードウェアを準備する必要があります。

- XIAO ESP32S3 Sense

- microSD カード(32GB 以下)

- microSD カードリーダー

- USB-C データケーブル

XIAO ESP32S3 Sense に拡張ボードを取り付けることで、拡張ボード上のマイクを使用できます。

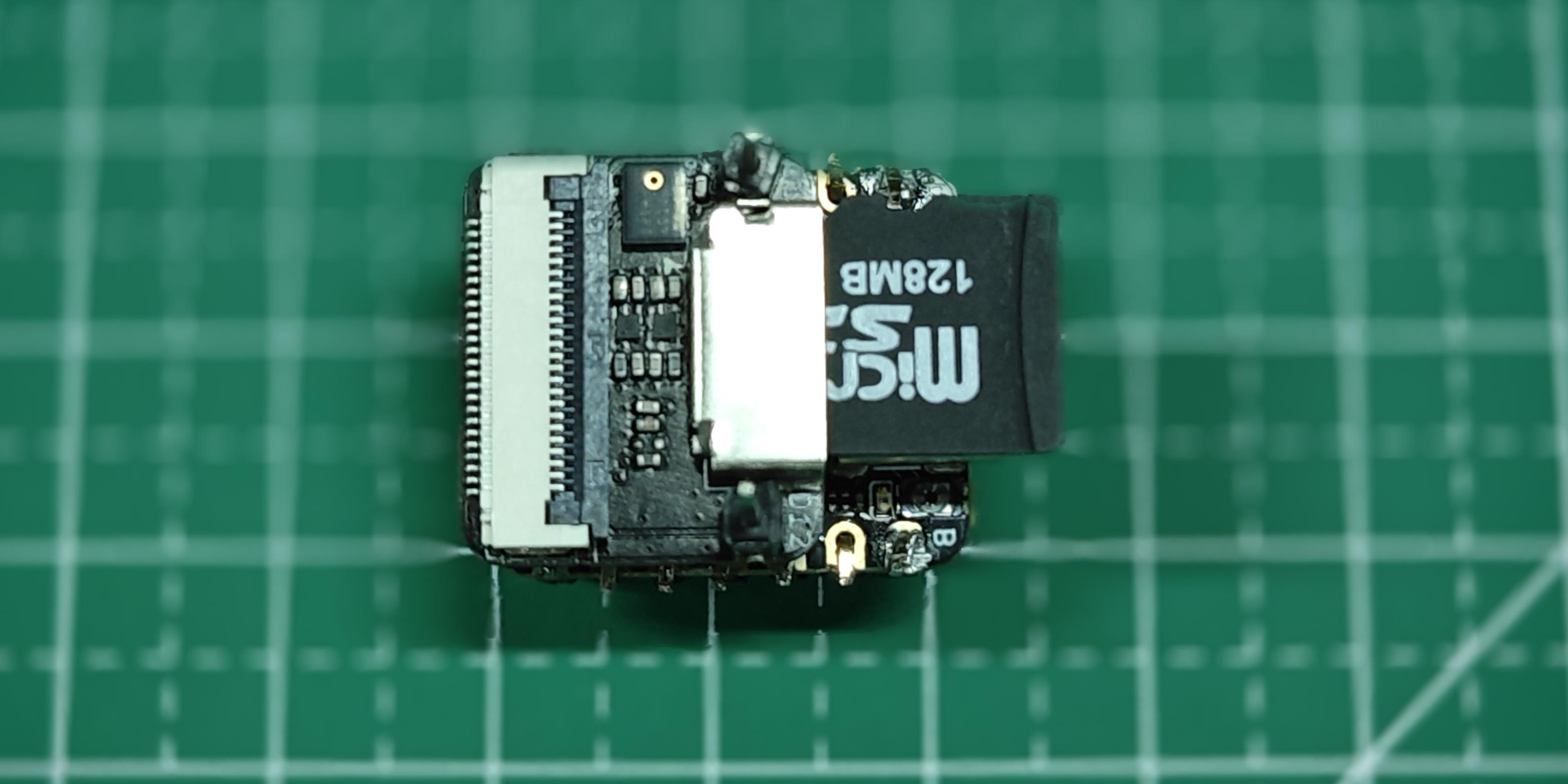

拡張ボードの取り付けは非常に簡単で、拡張ボード上のコネクタを XIAO ESP32S3 の B2B コネクタに合わせて、強く押して「カチッ」という音が聞こえれば取り付け完了です。

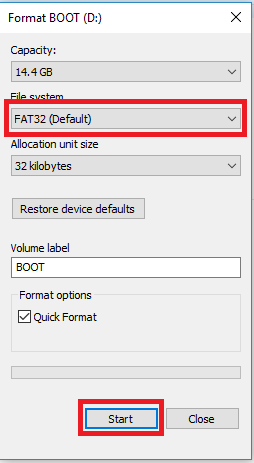

XIAO ESP32S3 Sense は最大 32GB の microSD カードをサポートしているため、XIAO 用の microSD カードを購入する予定の場合は、この仕様を参考にしてください。microSD カードを使用する前に、FAT32 形式でフォーマットしてください。

フォーマット後、microSD カードを microSD カードスロットに挿入できます。挿入方向に注意してください。金色の端子がある面を内側に向けてください。

ソフトウェア

XIAO ESP32S3 Sense を初めて使用する場合は、開始前に以下の 2 つの Wiki を読んで使用方法を学ぶことをお勧めします。

(オフライン)音声データの取得

ステップ 1. 録音したサウンドサンプルを .wav 音声ファイルとして microSD カードに保存

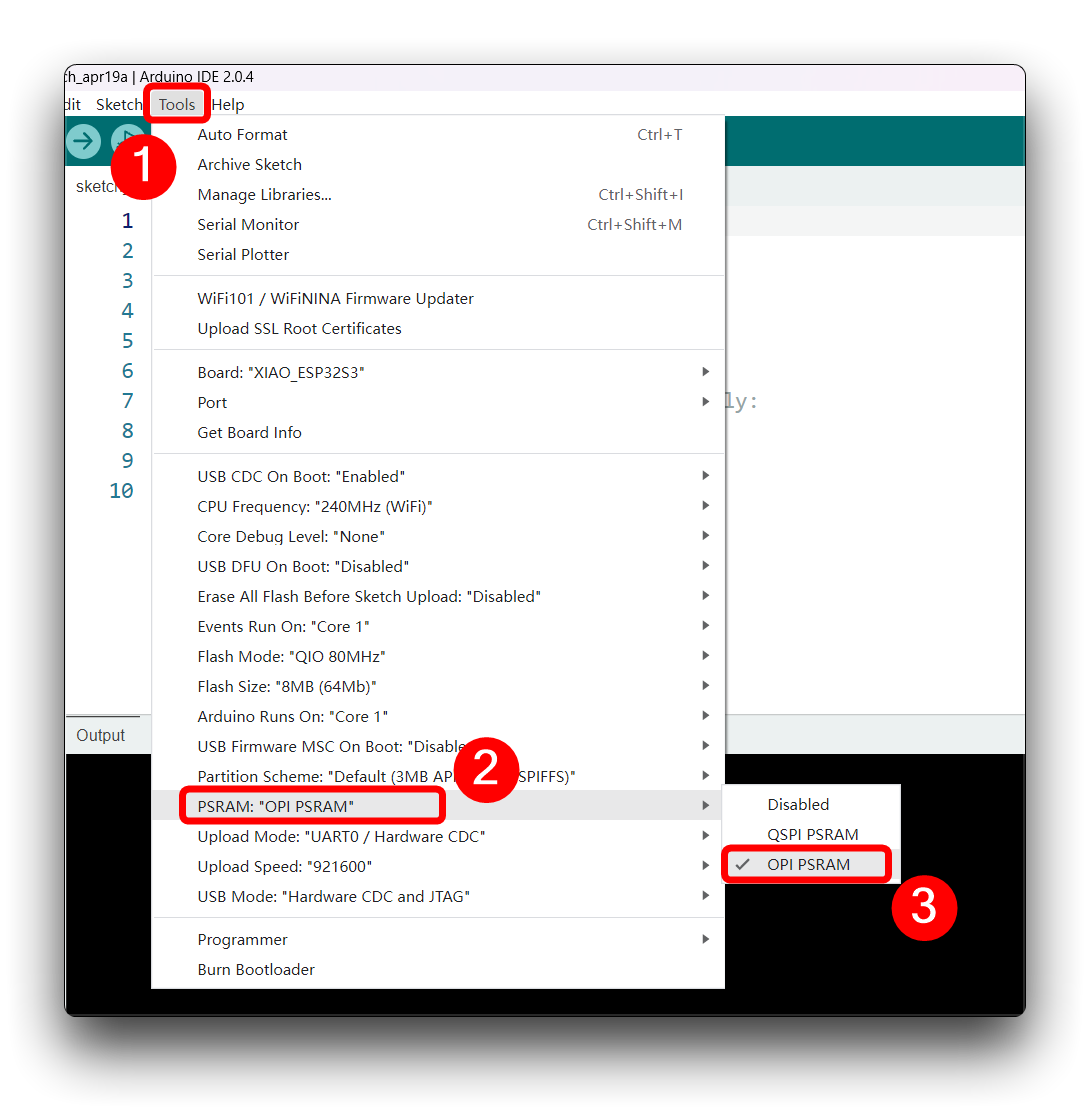

オンボード SD カードリーダーを使用して .wav 音声ファイルを保存しましょう。まず XIAO PSRAM を有効にする必要があります。

次に、以下のプログラムをコンパイルして XIAO ESP32S3 にアップロードします。

このコードは、Seeed XIAO ESP32S3 Sense ボードの I2S インターフェースを使用して音声を録音し、録音を SD カード上の .wav ファイルとして保存し、シリアルモニターから送信されるコマンドを通じて録音プロセスを制御できます。音声ファイルの名前はカスタマイズ可能で(訓練で使用するクラスラベルにする必要があります)、複数の録音を行うことができ、それぞれ新しいファイルに保存されます。このコードには録音の音量を上げる機能も含まれています。

ESP32 バージョンが 2.0.x の場合。ここをクリックして完全なプログラムをプレビューしてください

/*

* WAV Recorder for Seeed XIAO ESP32S3 Sense

*

* NOTE: To execute this code, we will need to use the PSRAM

* function of the ESP-32 chip, so please turn it on before uploading.

* Tools>PSRAM: "OPI PSRAM"

*

* Adapted by M.Rovai @May23 from original Seeed code

*/

#include <I2S.h>

#include "FS.h"

#include "SD.h"

#include "SPI.h"

// make changes as needed

#define RECORD_TIME 10 // seconds, The maximum value is 240

#define WAV_FILE_NAME "data"

// do not change for best

#define SAMPLE_RATE 16000U

#define SAMPLE_BITS 16

#define WAV_HEADER_SIZE 44

#define VOLUME_GAIN 2

int fileNumber = 1;

String baseFileName;

bool isRecording = false;

void setup() {

Serial.begin(115200);

while (!Serial) ;

I2S.setAllPins(-1, 42, 41, -1, -1);

if (!I2S.begin(PDM_MONO_MODE, SAMPLE_RATE, SAMPLE_BITS)) {

Serial.println("Failed to initialize I2S!");

while (1) ;

}

if(!SD.begin(21)){

Serial.println("Failed to mount SD Card!");

while (1) ;

}

Serial.printf("Enter with the label name\n");

//record_wav();

}

void loop() {

if (Serial.available() > 0) {

String command = Serial.readStringUntil('\n');

command.trim();

if (command == "rec") {

isRecording = true;

} else {

baseFileName = command;

fileNumber = 1; // reset file number each time a new base file name is set

Serial.printf("Send rec for starting recording label \n");

}

}

if (isRecording && baseFileName != "") {

String fileName = "/" + baseFileName + "." + String(fileNumber) + ".wav";

fileNumber++;

record_wav(fileName);

delay(1000); // delay to avoid recording multiple files at once

isRecording = false;

}

}

void record_wav(String fileName)

{

uint32_t sample_size = 0;

uint32_t record_size = (SAMPLE_RATE * SAMPLE_BITS / 8) * RECORD_TIME;

uint8_t *rec_buffer = NULL;

Serial.printf("Start recording ...\n");

File file = SD.open(fileName.c_str(), FILE_WRITE);

// Write the header to the WAV file

uint8_t wav_header[WAV_HEADER_SIZE];

generate_wav_header(wav_header, record_size, SAMPLE_RATE);

file.write(wav_header, WAV_HEADER_SIZE);

// PSRAM malloc for recording

rec_buffer = (uint8_t *)ps_malloc(record_size);

if (rec_buffer == NULL) {

Serial.printf("malloc failed!\n");

while(1) ;

}

Serial.printf("Buffer: %d bytes\n", ESP.getPsramSize() - ESP.getFreePsram());

// Start recording

esp_i2s::i2s_read(esp_i2s::I2S_NUM_0, rec_buffer, record_size, &sample_size, portMAX_DELAY);

if (sample_size == 0) {

Serial.printf("Record Failed!\n");

} else {

Serial.printf("Record %d bytes\n", sample_size);

}

// Increase volume

for (uint32_t i = 0; i < sample_size; i += SAMPLE_BITS/8) {

(*(uint16_t *)(rec_buffer+i)) <<= VOLUME_GAIN;

}

// Write data to the WAV file

Serial.printf("Writing to the file ...\n");

if (file.write(rec_buffer, record_size) != record_size)

Serial.printf("Write file Failed!\n");

free(rec_buffer);

file.close();

Serial.printf("Recording complete: \n");

Serial.printf("Send rec for a new sample or enter a new label\n\n");

}

void generate_wav_header(uint8_t *wav_header, uint32_t wav_size, uint32_t sample_rate)

{

// See this for reference: http://soundfile.sapp.org/doc/WaveFormat/

uint32_t file_size = wav_size + WAV_HEADER_SIZE - 8;

uint32_t byte_rate = SAMPLE_RATE * SAMPLE_BITS / 8;

const uint8_t set_wav_header[] = {

'R', 'I', 'F', 'F', // ChunkID

file_size, file_size >> 8, file_size >> 16, file_size >> 24, // ChunkSize

'W', 'A', 'V', 'E', // Format

'f', 'm', 't', ' ', // Subchunk1ID

0x10, 0x00, 0x00, 0x00, // Subchunk1Size (16 for PCM)

0x01, 0x00, // AudioFormat (1 for PCM)

0x01, 0x00, // NumChannels (1 channel)

sample_rate, sample_rate >> 8, sample_rate >> 16, sample_rate >> 24, // SampleRate

byte_rate, byte_rate >> 8, byte_rate >> 16, byte_rate >> 24, // ByteRate

0x02, 0x00, // BlockAlign

0x10, 0x00, // BitsPerSample (16 bits)

'd', 'a', 't', 'a', // Subchunk2ID

wav_size, wav_size >> 8, wav_size >> 16, wav_size >> 24, // Subchunk2Size

};

memcpy(wav_header, set_wav_header, sizeof(set_wav_header));

}

If your ESP32 version is 3.0.x. Click here to preview the full program

/*

* WAV Recorder for Seeed XIAO ESP32S3 Sense

*

* NOTE: To execute this code, we will need to use the PSRAM

* function of the ESP-32 chip, so please turn it on before uploading.

* Tools>PSRAM: "OPI PSRAM"

*

* Adapted by M.Rovai @May23 from original Seeed code

*/

#include <ESP_I2S.h>

#include "FS.h"

#include "SD.h"

#include "SPI.h"

// make changes as needed

#define RECORD_TIME 10 // seconds, The maximum value is 240

#define WAV_FILE_NAME "data"

// do not change for best

#define SAMPLE_RATE 16000U

#define SAMPLE_BITS 16

#define WAV_HEADER_SIZE 44

#define VOLUME_GAIN 2

I2SClass I2S;

String baseFileName;

int fileNumber = 1;

bool isRecording = false;

void setup() {

Serial.begin(115200);

while (!Serial) ;

// setup 42 PDM clock and 41 PDM data pins

I2S.setPinsPdmRx(42, 41);

if (!I2S.begin(I2S_MODE_PDM_RX, 16000, I2S_DATA_BIT_WIDTH_16BIT, I2S_SLOT_MODE_MONO)) {

Serial.println("Failed to initialize I2S!");

while (1) ;

}

if(!SD.begin(21)){

Serial.println("Failed to mount SD Card!");

while (1) ;

}

Serial.printf("Enter with the label name\n");

//record_wav();

}

void loop() {

if (Serial.available() > 0) {

String command = Serial.readStringUntil('\n');

command.trim();

if (command == "rec") {

isRecording = true;

} else {

baseFileName = command;

fileNumber = 1; // reset file number each time a new base file name is set

Serial.printf("Send rec for starting recording label \n");

}

}

if (isRecording && baseFileName != "") {

String fileName = "/" + baseFileName + "." + String(fileNumber) + ".wav";

fileNumber++;

record_wav(fileName);

delay(1000); // delay to avoid recording multiple files at once

isRecording = false;

}

}

void record_wav(String fileName)

{

uint32_t sample_size = 0;

uint32_t record_size = (SAMPLE_RATE * SAMPLE_BITS / 8) * RECORD_TIME;

uint8_t *rec_buffer = NULL;

Serial.printf("Start recording ...\n");

File file = SD.open(fileName.c_str(), FILE_WRITE);

// Write the header to the WAV file

uint8_t wav_header[WAV_HEADER_SIZE];

generate_wav_header(wav_header, record_size, SAMPLE_RATE);

file.write(wav_header, WAV_HEADER_SIZE);

// PSRAM malloc for recording

rec_buffer = (uint8_t *)ps_malloc(record_size);

if (rec_buffer == NULL) {

Serial.printf("malloc failed!\n");

while(1) ;

}

Serial.printf("Buffer: %d bytes\n", ESP.getPsramSize() - ESP.getFreePsram());

// Start recording

esp_i2s::i2s_read(esp_i2s::I2S_NUM_0, rec_buffer, record_size, &sample_size, portMAX_DELAY);

if (sample_size == 0) {

Serial.printf("Record Failed!\n");

} else {

Serial.printf("Record %d bytes\n", sample_size);

}

// Increase volume

for (uint32_t i = 0; i < sample_size; i += SAMPLE_BITS/8) {

(*(uint16_t *)(rec_buffer+i)) <<= VOLUME_GAIN;

}

// Write data to the WAV file

Serial.printf("Writing to the file ...\n");

if (file.write(rec_buffer, record_size) != record_size)

Serial.printf("Write file Failed!\n");

free(rec_buffer);

file.close();

Serial.printf("Recording complete: \n");

Serial.printf("Send rec for a new sample or enter a new label\n\n");

}

void generate_wav_header(uint8_t *wav_header, uint32_t wav_size, uint32_t sample_rate)

{

// See this for reference: http://soundfile.sapp.org/doc/WaveFormat/

uint32_t file_size = wav_size + WAV_HEADER_SIZE - 8;

uint32_t byte_rate = SAMPLE_RATE * SAMPLE_BITS / 8;

const uint8_t set_wav_header[] = {

'R', 'I', 'F', 'F', // ChunkID

file_size, file_size >> 8, file_size >> 16, file_size >> 24, // ChunkSize

'W', 'A', 'V', 'E', // Format

'f', 'm', 't', ' ', // Subchunk1ID

0x10, 0x00, 0x00, 0x00, // Subchunk1Size (16 for PCM)

0x01, 0x00, // AudioFormat (1 for PCM)

0x01, 0x00, // NumChannels (1 channel)

sample_rate, sample_rate >> 8, sample_rate >> 16, sample_rate >> 24, // SampleRate

byte_rate, byte_rate >> 8, byte_rate >> 16, byte_rate >> 24, // ByteRate

0x02, 0x00, // BlockAlign

0x10, 0x00, // BitsPerSample (16 bits)

'd', 'a', 't', 'a', // Subchunk2ID

wav_size, wav_size >> 8, wav_size >> 16, wav_size >> 24, // Subchunk2Size

};

memcpy(wav_header, set_wav_header, sizeof(set_wav_header));

}

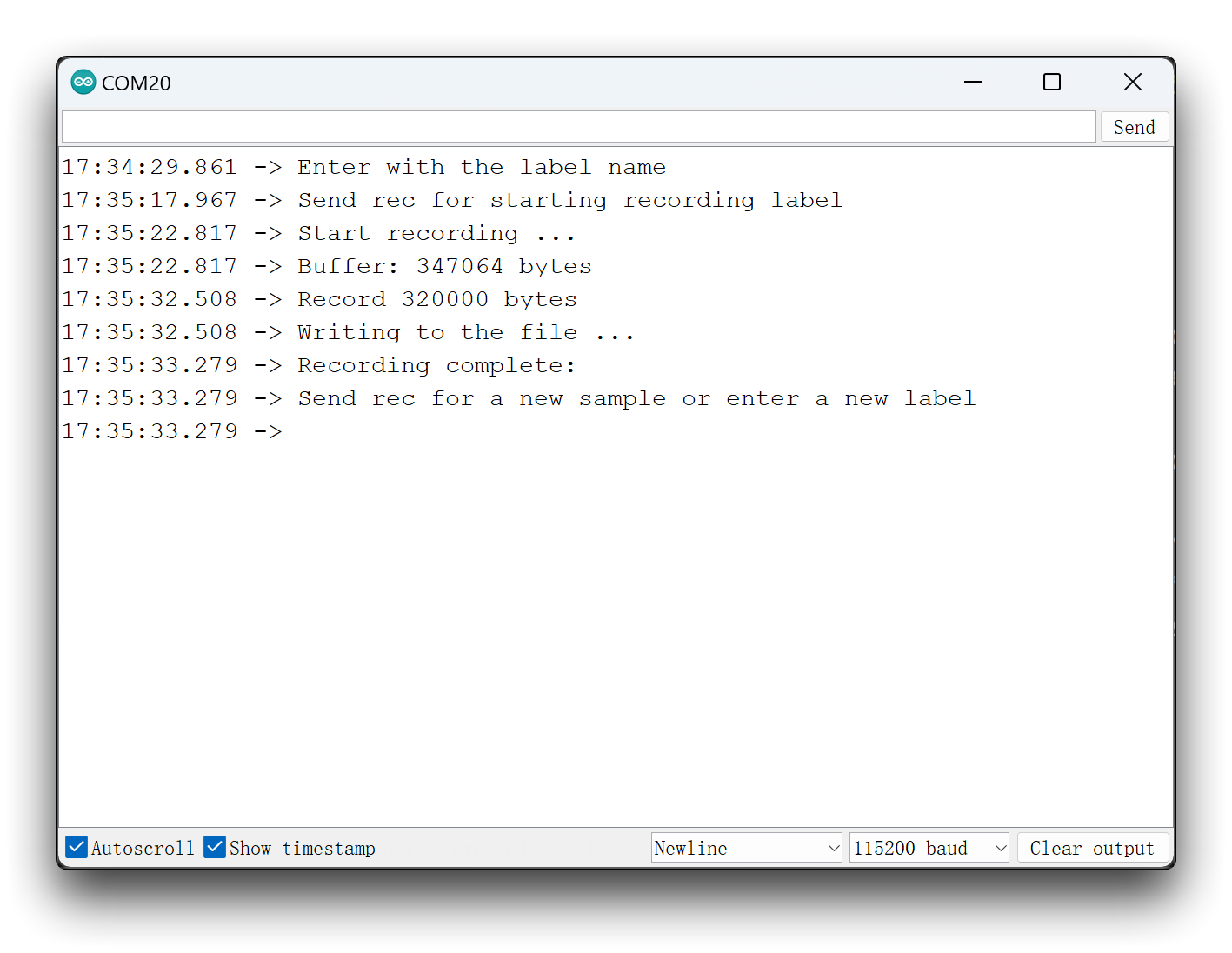

次に、コードをXIAOにアップロードし、キーワード(helloとstop)からサンプルを取得します。ノイズや他の単語もキャプチャできます。シリアルモニターは、記録するラベルを受信するよう促します。

ラベル(例:hello)を送信します。プログラムは別のコマンド:recを待機します。

プログラムは、コマンドrecが送信されるたびに新しいサンプルの記録を開始します。ファイルはhello.1.wav、hello.2.wav、hello.3.wavなどとして保存され、新しいラベル(例:stop)が送信されるまで続きます。この場合、各新しいサンプルに対してコマンドrecを送信する必要があり、stop.1.wav、stop.2.wav、stop.3.wavなどとして保存されます。

最終的に、SDカードに保存されたファイルを取得します。

各ラベルサンプルに十分な音声を用意することをお勧めします。10秒間の録音セッション中にキーワードを数回繰り返すことができ、後続のステップでサンプルをセグメント化します。ただし、キーワード間にはある程度の間隔が必要です。

訓練データの取得

ステップ2. 収集した音声データのアップロード

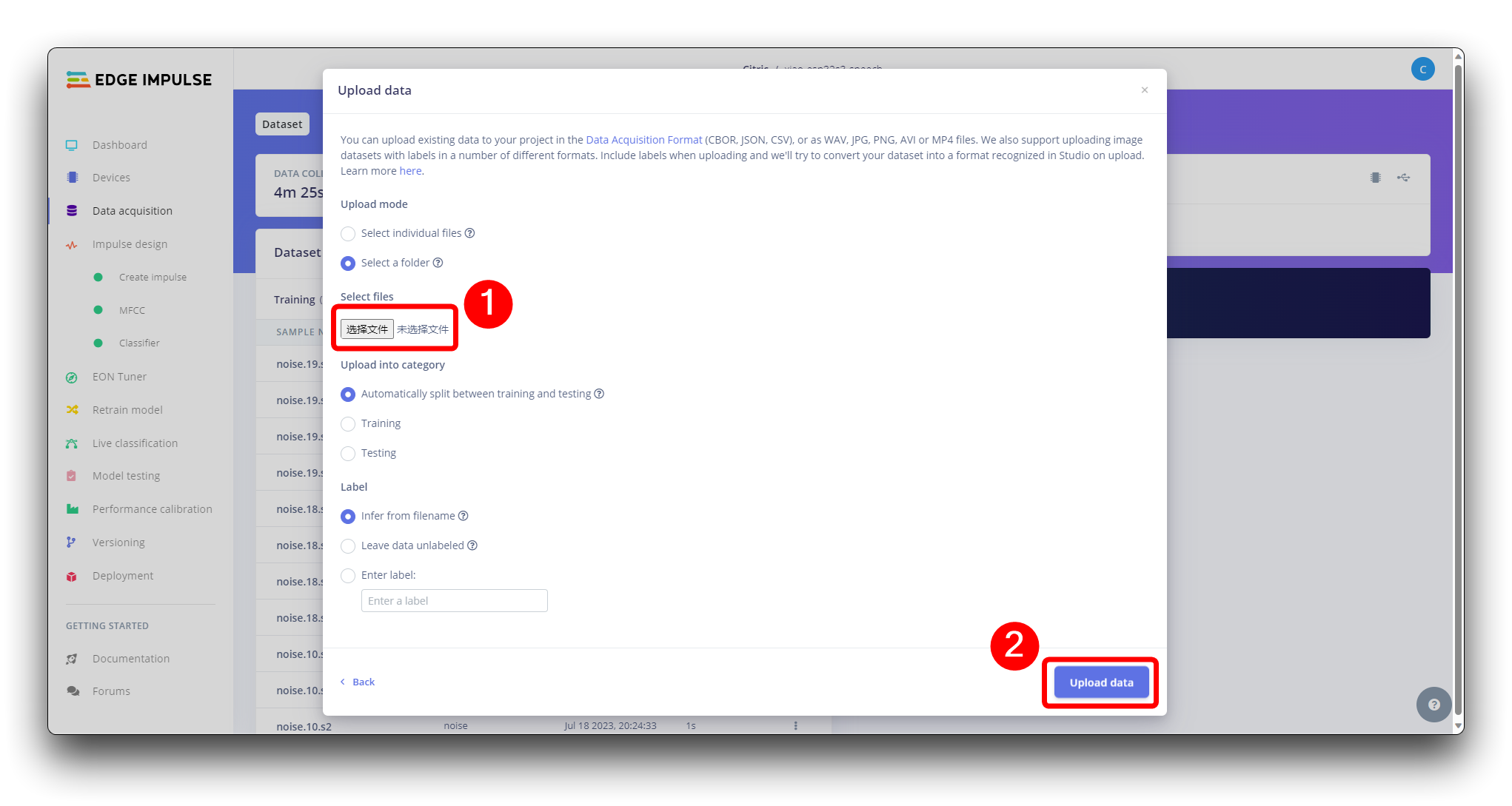

生データセットが定義され収集されたら、Edge Impulseで新しいプロジェクトを開始する必要があります。プロジェクトが作成されたら、Data AcquisitionセクションのUpload Existing Dataツールを選択します。アップロードするファイルを選択します。

それらをStudioにアップロードします(データを自動的にtrain/testに分割できます)。すべてのクラスとすべての生データに対して繰り返します。

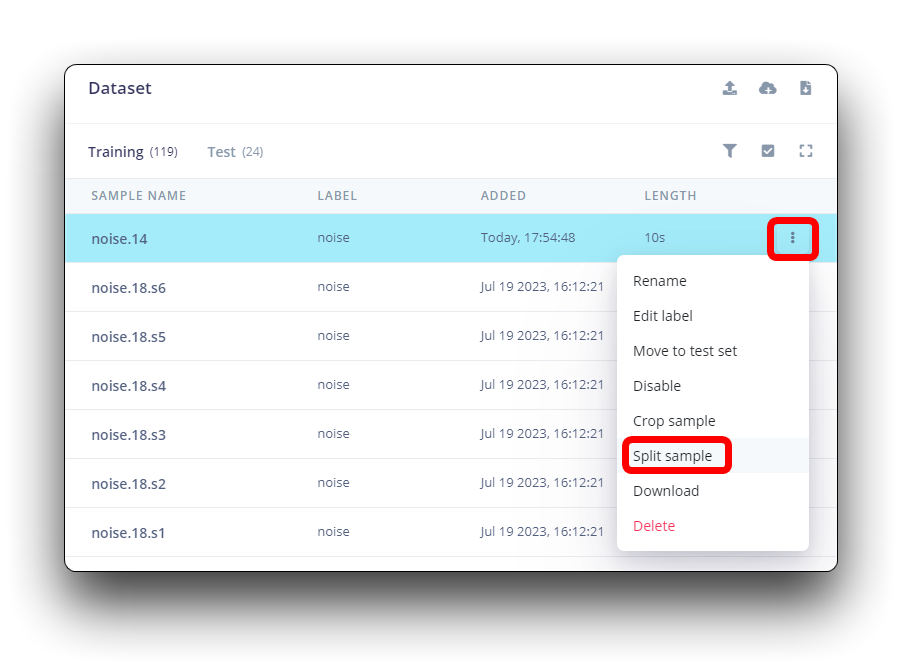

データセット内のすべてのデータは1秒の長さですが、前のセクションで記録されたサンプルは10秒であり、互換性を保つために1秒のサンプルに分割する必要があります。サンプル名の後の3つの点をクリックし、Split sampleを選択します。

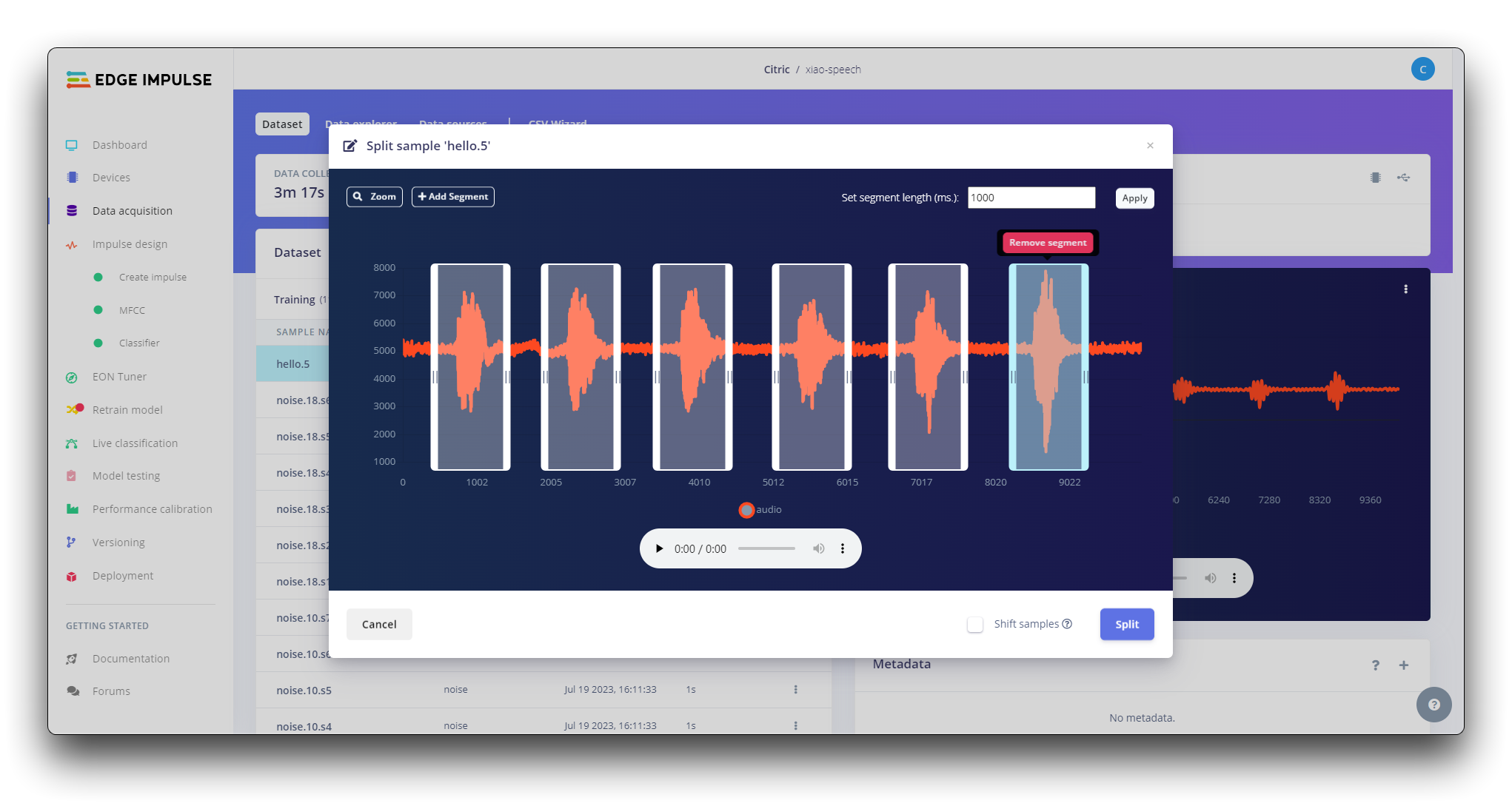

ツール内で、データを1秒の記録に分割します。必要に応じて、セグメントを追加または削除します。

この手順はすべてのサンプルに対して繰り返す必要があります。

ステップ3. インパルスの作成(前処理/モデル定義)

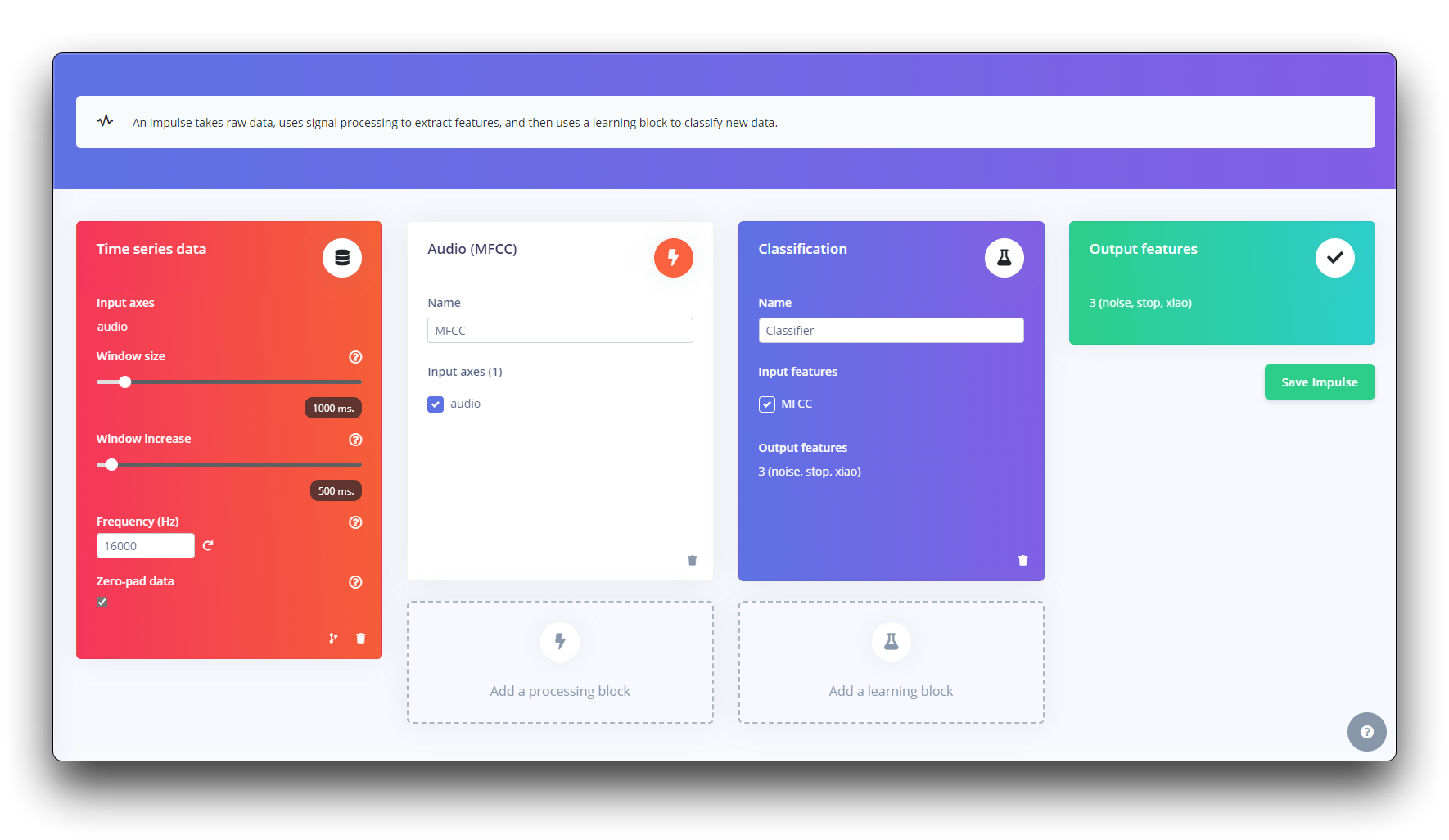

インパルスは生データを取得し、信号処理を使用して特徴を抽出し、学習ブロックを使用して新しいデータを分類します。

まず、1秒のウィンドウでデータポイントを取得し、データを拡張して、そのウィンドウを500msごとにスライドします。zero-pad dataオプションが設定されていることに注意してください。これは、1秒未満のサンプルをゼロで埋めるために重要です(場合によっては、ノイズやスパイクを避けるためにsplit toolで1000msウィンドウを縮小しました)。

各1秒の音声サンプルは前処理され、画像(例:13 x 49 x 1)に変換される必要があります。人間の声に適したMel周波数ケプストラム係数を使用して音声信号から特徴を抽出するMFCCを使用します。

次に、畳み込みニューラルネットワークを使用した画像分類によってゼロからモデルを構築する分類用のKERASを選択します。

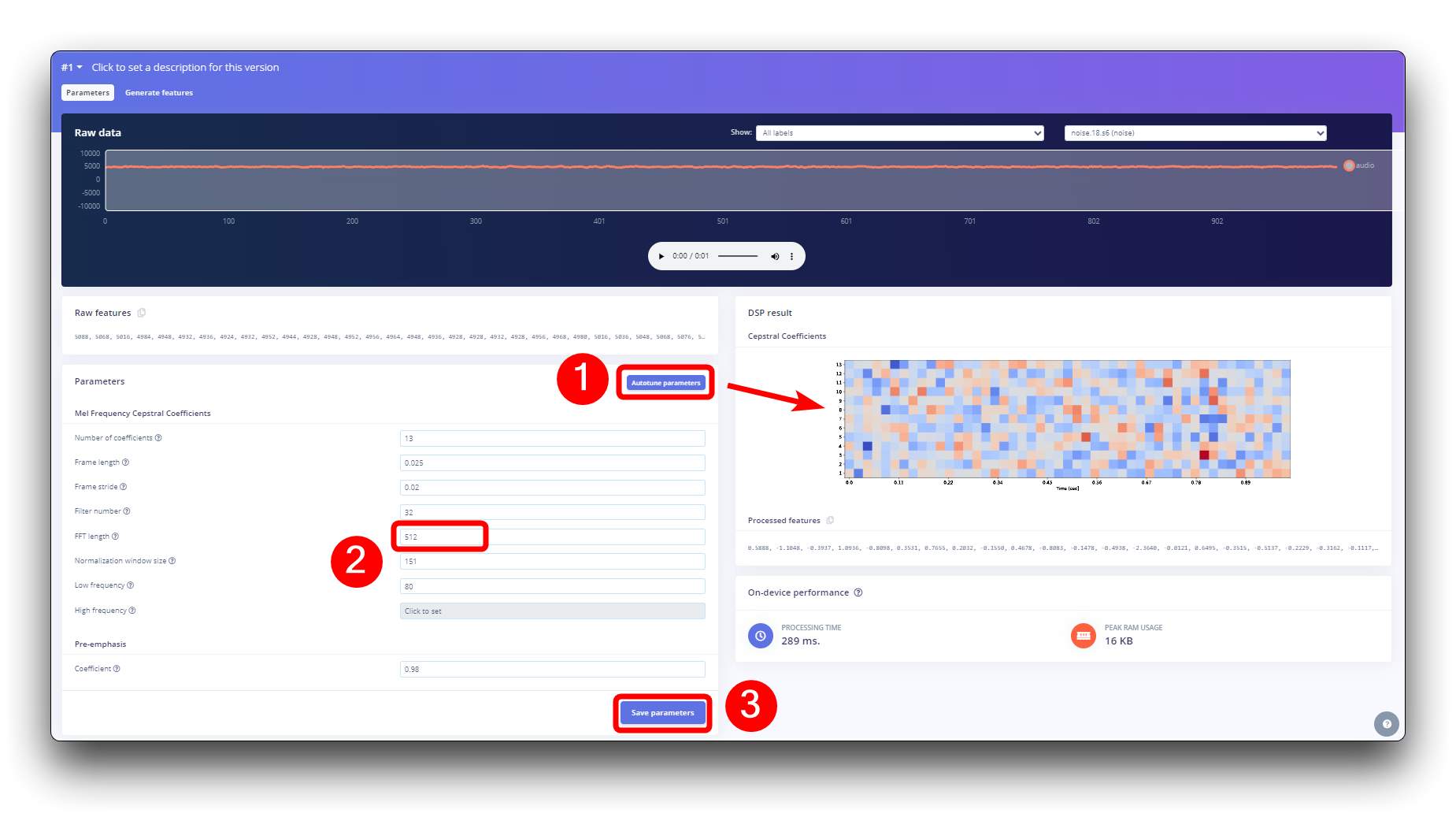

ステップ4. 前処理(MFCC)

次のステップは、次の段階で訓練される画像を作成することです。デフォルトのパラメータ値を保持するか、DSP Autotuneparametersオプションを活用することができます。後者を実行します。

機械学習モデルの構築

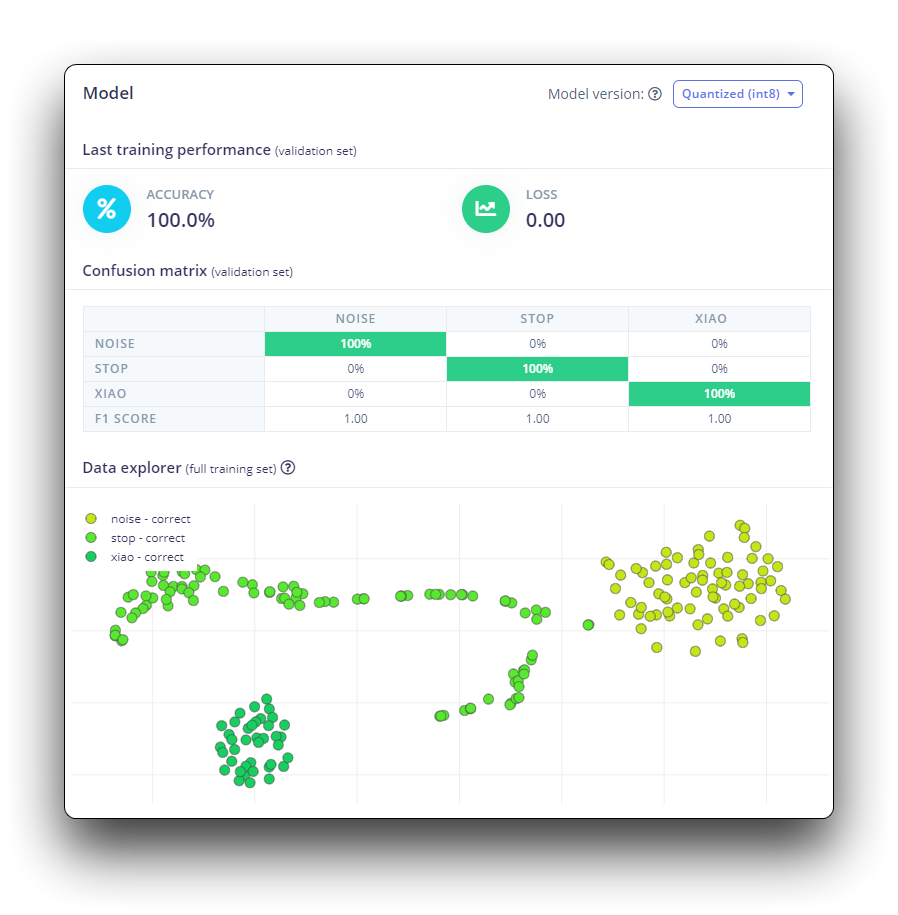

ステップ 5. モデル設計とトレーニング

畳み込みニューラルネットワーク(CNN)モデルを使用します。基本的なアーキテクチャは、Conv1D + MaxPooling の2つのブロック(それぞれ8個と16個のニューロン)と0.25のDropoutで定義されています。そして最後の層では、Flatteningの後に4つのニューロン(各クラスに1つずつ)を配置します。

ハイパーパラメータとして、学習率0.005と100エポックでトレーニングされるモデルを使用します。また、ノイズなどのデータ拡張も含めます。結果は良好に見えます。

XIAO ESP32S3 Senseへのデプロイ

ステップ 6. XIAO ESP32S3 Senseへのデプロイ

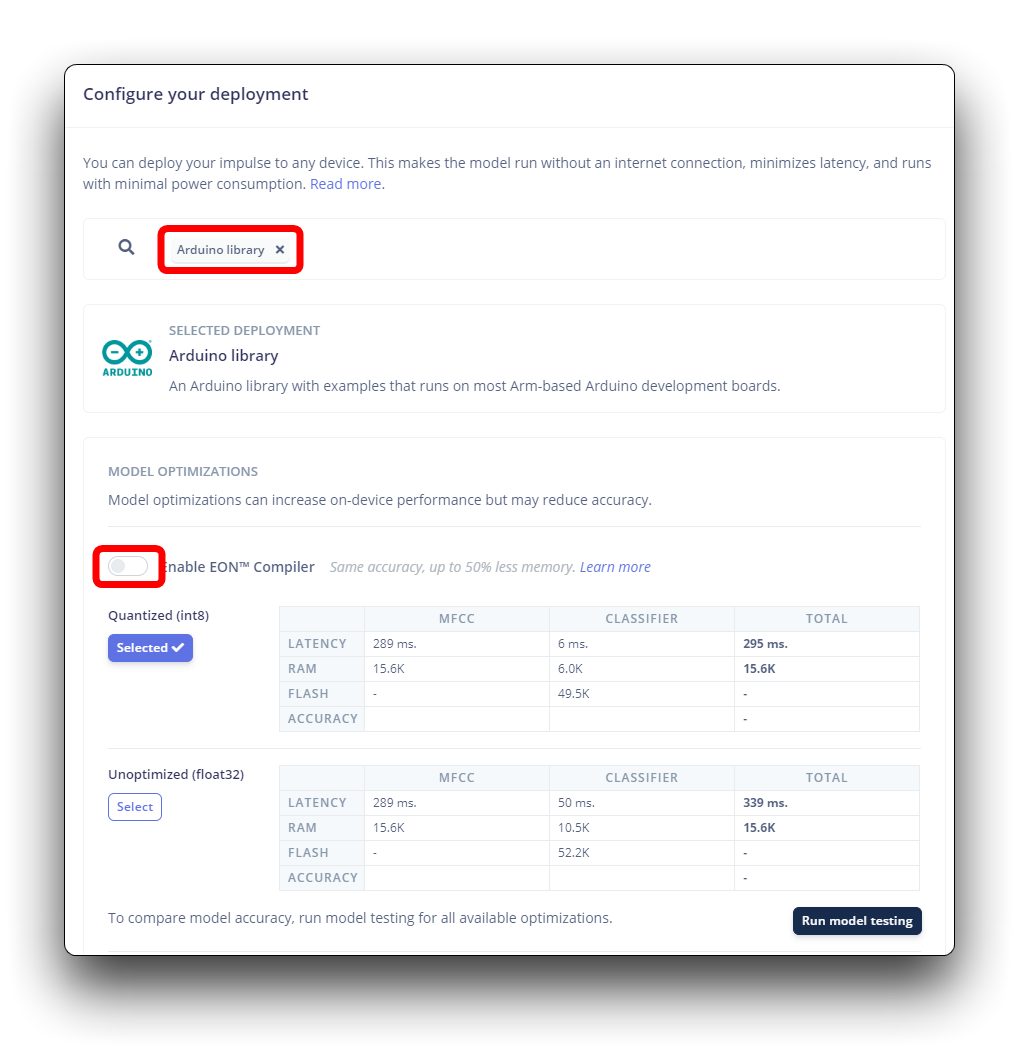

Edge Impulseは、必要なすべてのライブラリ、前処理関数、トレーニング済みモデルをパッケージ化し、コンピュータにダウンロードします。Arduino Libraryオプションを選択し、下部でQuantized (Int8)を選択してBuildボタンを押してください。

Edge ImpulseはESP NN アクセラレータを使用したESP32S3用のSDKをまだリリースしていませんが、Dmitry Maslovのおかげで、ESP32-S3用のアセンブリ最適化を復元・修正することができます。この解決策はまだ公式ではなく、EIは他のボードとの競合を修正した後、EI SDKに含める予定です。

現在のところ、これは非EONバージョンでのみ動作します。そのため、Enable EON Compilerオプションは選択しないでください。

Buildボタンを選択すると、Zipファイルが作成され、コンピュータにダウンロードされます。

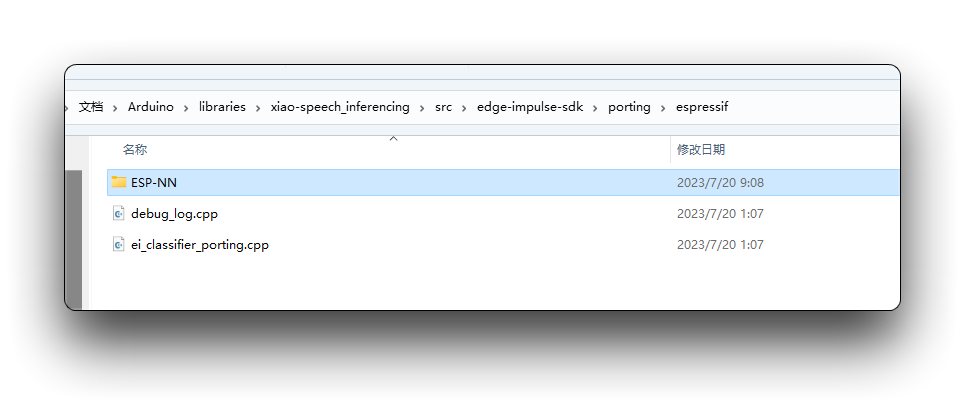

ダウンロードしたライブラリを使用する前に、ESP NNアクセラレータを有効にする必要があります。そのために、プロジェクトのGitHubから予備バージョンをダウンロードし、解凍して、Arduinoライブラリフォルダのsrc/edge-impulse-sdk/porting/espressif/ESP-NNにあるESP NNフォルダと置き換えてください。

Arduino IDEで、Sketchタブに移動し、Add .ZIP Libraryオプションを選択し、Edge Impulseでダウンロードした.zipファイルを選択してください。

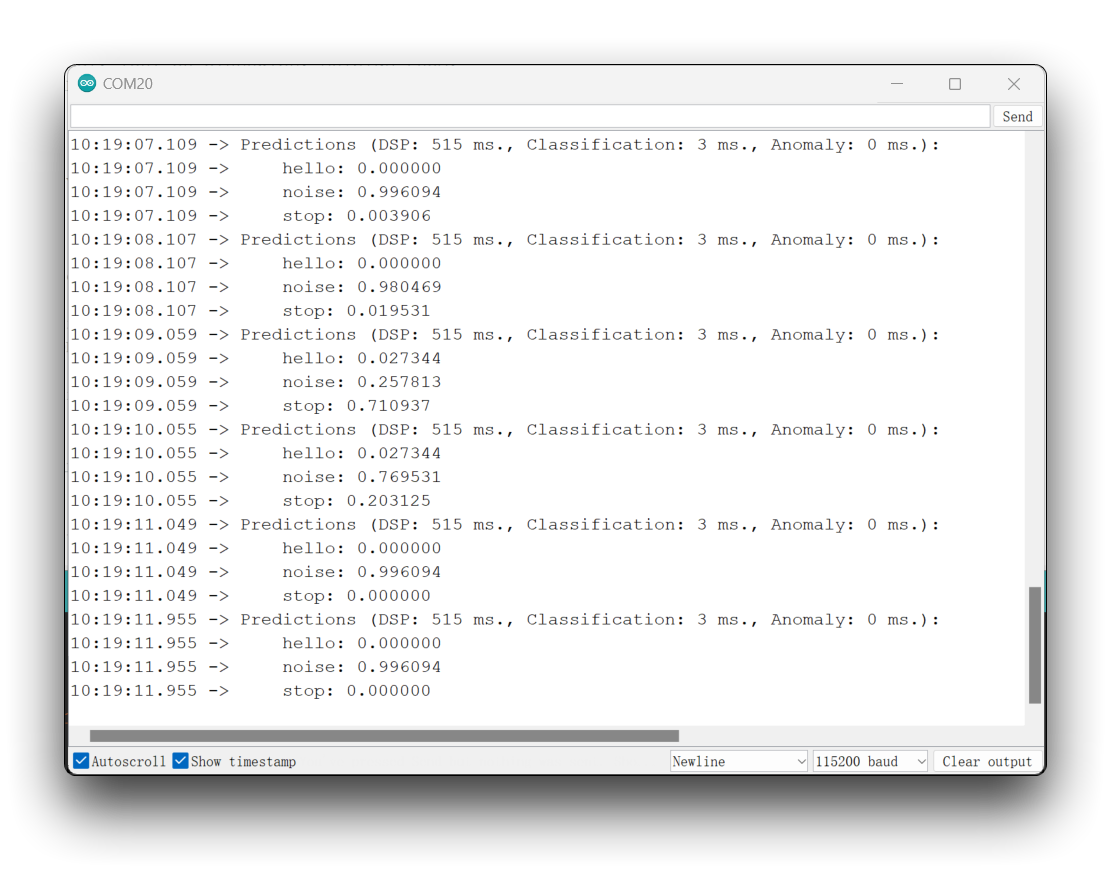

完全なコードはプロジェクトのGitHubで確認できます。スケッチをボードにアップロードし、実際の推論をテストしてください。

コードでインポートされるライブラリは、あなたのライブラリの名前で更新する必要があります。また、点灯のロジックも、実際にトレーニングしたラベルの順序に基づいて修正する必要があります。

ESP32バージョンが2.0.xの場合、こちらをクリックして完全なプログラムをプレビューしてください

/* Edge Impulse Arduino examples

* Copyright (c) 2022 EdgeImpulse Inc.

*

* Permission is hereby granted, free of charge, to any person obtaining a copy

* of this software and associated documentation files (the "Software"), to deal

* in the Software without restriction, including without limitation the rights

* to use, copy, modify, merge, publish, distribute, sublicense, and/or sell

* copies of the Software, and to permit persons to whom the Software is

* furnished to do so, subject to the following conditions:

*

* The above copyright notice and this permission notice shall be included in

* all copies or substantial portions of the Software.

*

* THE SOFTWARE IS PROVIDED "AS IS", WITHOUT WARRANTY OF ANY KIND, EXPRESS OR

* IMPLIED, INCLUDING BUT NOT LIMITED TO THE WARRANTIES OF MERCHANTABILITY,

* FITNESS FOR A PARTICULAR PURPOSE AND NONINFRINGEMENT. IN NO EVENT SHALL THE

* AUTHORS OR COPYRIGHT HOLDERS BE LIABLE FOR ANY CLAIM, DAMAGES OR OTHER

* LIABILITY, WHETHER IN AN ACTION OF CONTRACT, TORT OR OTHERWISE, ARISING FROM,

* OUT OF OR IN CONNECTION WITH THE SOFTWARE OR THE USE OR OTHER DEALINGS IN THE

* SOFTWARE.

*/

// If your target is limited in memory remove this macro to save 10K RAM

#define EIDSP_QUANTIZE_FILTERBANK 0

/*

** NOTE: If you run into TFLite arena allocation issue.

**

** This may be due to may dynamic memory fragmentation.

** Try defining "-DEI_CLASSIFIER_ALLOCATION_STATIC" in boards.local.txt (create

** if it doesn't exist) and copy this file to

** `<ARDUINO_CORE_INSTALL_PATH>/arduino/hardware/<mbed_core>/<core_version>/`.

**

** See

** (https://support.arduino.cc/hc/en-us/articles/360012076960-Where-are-the-installed-cores-located-)

** to find where Arduino installs cores on your machine.

**

** If the problem persists then there's not enough memory for this model and application.

*/

/* Includes ---------------------------------------------------------------- */

#include <XIAO-ESP32S3-KWS_inferencing.h>

#include <I2S.h>

#define SAMPLE_RATE 16000U

#define SAMPLE_BITS 16

#define LED_BUILT_IN 21

/** Audio buffers, pointers and selectors */

typedef struct {

int16_t *buffer;

uint8_t buf_ready;

uint32_t buf_count;

uint32_t n_samples;

} inference_t;

static inference_t inference;

static const uint32_t sample_buffer_size = 2048;

static signed short sampleBuffer[sample_buffer_size];

static bool debug_nn = false; // Set this to true to see e.g. features generated from the raw signal

static bool record_status = true;

/**

* @brief Arduino setup function

*/

void setup()

{

// put your setup code here, to run once:

Serial.begin(115200);

// comment out the below line to cancel the wait for USB connection (needed for native USB)

while (!Serial);

Serial.println("Edge Impulse Inferencing Demo");

pinMode(LED_BUILT_IN, OUTPUT); // Set the pin as output

digitalWrite(LED_BUILT_IN, HIGH); //Turn off

I2S.setAllPins(-1, 42, 41, -1, -1);

if (!I2S.begin(PDM_MONO_MODE, SAMPLE_RATE, SAMPLE_BITS)) {

Serial.println("Failed to initialize I2S!");

while (1) ;

}

// summary of inferencing settings (from model_metadata.h)

ei_printf("Inferencing settings:\n");

ei_printf("\tInterval: ");

ei_printf_float((float)EI_CLASSIFIER_INTERVAL_MS);

ei_printf(" ms.\n");

ei_printf("\tFrame size: %d\n", EI_CLASSIFIER_DSP_INPUT_FRAME_SIZE);

ei_printf("\tSample length: %d ms.\n", EI_CLASSIFIER_RAW_SAMPLE_COUNT / 16);

ei_printf("\tNo. of classes: %d\n", sizeof(ei_classifier_inferencing_categories) / sizeof(ei_classifier_inferencing_categories[0]));

ei_printf("\nStarting continious inference in 2 seconds...\n");

ei_sleep(2000);

if (microphone_inference_start(EI_CLASSIFIER_RAW_SAMPLE_COUNT) == false) {

ei_printf("ERR: Could not allocate audio buffer (size %d), this could be due to the window length of your model\r\n", EI_CLASSIFIER_RAW_SAMPLE_COUNT);

return;

}

ei_printf("Recording...\n");

}

/**

* @brief Arduino main function. Runs the inferencing loop.

*/

void loop()

{

bool m = microphone_inference_record();

if (!m) {

ei_printf("ERR: Failed to record audio...\n");

return;

}

signal_t signal;

signal.total_length = EI_CLASSIFIER_RAW_SAMPLE_COUNT;

signal.get_data = µphone_audio_signal_get_data;

ei_impulse_result_t result = { 0 };

EI_IMPULSE_ERROR r = run_classifier(&signal, &result, debug_nn);

if (r != EI_IMPULSE_OK) {

ei_printf("ERR: Failed to run classifier (%d)\n", r);

return;

}

int pred_index = 0; // Initialize pred_index

float pred_value = 0; // Initialize pred_value

// print the predictions

ei_printf("Predictions ");

ei_printf("(DSP: %d ms., Classification: %d ms., Anomaly: %d ms.)",

result.timing.dsp, result.timing.classification, result.timing.anomaly);

ei_printf(": \n");

for (size_t ix = 0; ix < EI_CLASSIFIER_LABEL_COUNT; ix++) {

ei_printf(" %s: ", result.classification[ix].label);

ei_printf_float(result.classification[ix].value);

ei_printf("\n");

if (result.classification[ix].value > pred_value){

pred_index = ix;

pred_value = result.classification[ix].value;

}

}

// Display inference result

if (pred_index == 3){

digitalWrite(LED_BUILT_IN, LOW); //Turn on

}

else{

digitalWrite(LED_BUILT_IN, HIGH); //Turn off

}

#if EI_CLASSIFIER_HAS_ANOMALY == 1

ei_printf(" anomaly score: ");

ei_printf_float(result.anomaly);

ei_printf("\n");

#endif

}

static void audio_inference_callback(uint32_t n_bytes)

{

for(int i = 0; i < n_bytes>>1; i++) {

inference.buffer[inference.buf_count++] = sampleBuffer[i];

if(inference.buf_count >= inference.n_samples) {

inference.buf_count = 0;

inference.buf_ready = 1;

}

}

}

static void capture_samples(void* arg) {

const int32_t i2s_bytes_to_read = (uint32_t)arg;

size_t bytes_read = i2s_bytes_to_read;

while (record_status) {

/* read data at once from i2s - Modified for XIAO ESP2S3 Sense and I2S.h library */

// i2s_read((i2s_port_t)1, (void*)sampleBuffer, i2s_bytes_to_read, &bytes_read, 100);

esp_i2s::i2s_read(esp_i2s::I2S_NUM_0, (void*)sampleBuffer, i2s_bytes_to_read, &bytes_read, 100);

if (bytes_read <= 0) {

ei_printf("Error in I2S read : %d", bytes_read);

}

else {

if (bytes_read < i2s_bytes_to_read) {

ei_printf("Partial I2S read");

}

// scale the data (otherwise the sound is too quiet)

for (int x = 0; x < i2s_bytes_to_read/2; x++) {

sampleBuffer[x] = (int16_t)(sampleBuffer[x]) * 8;

}

if (record_status) {

audio_inference_callback(i2s_bytes_to_read);

}

else {

break;

}

}

}

vTaskDelete(NULL);

}

/**

* @brief Init inferencing struct and setup/start PDM

*

* @param[in] n_samples The n samples

*

* @return { description_of_the_return_value }

*/

static bool microphone_inference_start(uint32_t n_samples)

{

inference.buffer = (int16_t *)malloc(n_samples * sizeof(int16_t));

if(inference.buffer == NULL) {

return false;

}

inference.buf_count = 0;

inference.n_samples = n_samples;

inference.buf_ready = 0;

// if (i2s_init(EI_CLASSIFIER_FREQUENCY)) {

// ei_printf("Failed to start I2S!");

// }

ei_sleep(100);

record_status = true;

xTaskCreate(capture_samples, "CaptureSamples", 1024 * 32, (void*)sample_buffer_size, 10, NULL);

return true;

}

/**

* @brief Wait on new data

*

* @return True when finished

*/

static bool microphone_inference_record(void)

{

bool ret = true;

while (inference.buf_ready == 0) {

delay(10);

}

inference.buf_ready = 0;

return ret;

}

/**

* Get raw audio signal data

*/

static int microphone_audio_signal_get_data(size_t offset, size_t length, float *out_ptr)

{

numpy::int16_to_float(&inference.buffer[offset], out_ptr, length);

return 0;

}

/**

* @brief Stop PDM and release buffers

*/

static void microphone_inference_end(void)

{

free(sampleBuffer);

ei_free(inference.buffer);

}

#if !defined(EI_CLASSIFIER_SENSOR) || EI_CLASSIFIER_SENSOR != EI_CLASSIFIER_SENSOR_MICROPHONE

#error "Invalid model for current sensor."

#endif

If your ESP32 version is 3.0.x. Click here to preview the full program

/* Edge Impulse Arduino examples

* Copyright (c) 2022 EdgeImpulse Inc.

*

* Permission is hereby granted, free of charge, to any person obtaining a copy

* of this software and associated documentation files (the "Software"), to deal

* in the Software without restriction, including without limitation the rights

* to use, copy, modify, merge, publish, distribute, sublicense, and/or sell

* copies of the Software, and to permit persons to whom the Software is

* furnished to do so, subject to the following conditions:

*

* The above copyright notice and this permission notice shall be included in

* all copies or substantial portions of the Software.

*

* THE SOFTWARE IS PROVIDED "AS IS", WITHOUT WARRANTY OF ANY KIND, EXPRESS OR

* IMPLIED, INCLUDING BUT NOT LIMITED TO THE WARRANTIES OF MERCHANTABILITY,

* FITNESS FOR A PARTICULAR PURPOSE AND NONINFRINGEMENT. IN NO EVENT SHALL THE

* AUTHORS OR COPYRIGHT HOLDERS BE LIABLE FOR ANY CLAIM, DAMAGES OR OTHER

* LIABILITY, WHETHER IN AN ACTION OF CONTRACT, TORT OR OTHERWISE, ARISING FROM,

* OUT OF OR IN CONNECTION WITH THE SOFTWARE OR THE USE OR OTHER DEALINGS IN THE

* SOFTWARE.

*/

// If your target is limited in memory remove this macro to save 10K RAM

#define EIDSP_QUANTIZE_FILTERBANK 0

/*

** NOTE: If you run into TFLite arena allocation issue.

**

** This may be due to may dynamic memory fragmentation.

** Try defining "-DEI_CLASSIFIER_ALLOCATION_STATIC" in boards.local.txt (create

** if it doesn't exist) and copy this file to

** `<ARDUINO_CORE_INSTALL_PATH>/arduino/hardware/<mbed_core>/<core_version>/`.

**

** See

** (https://support.arduino.cc/hc/en-us/articles/360012076960-Where-are-the-installed-cores-located-)

** to find where Arduino installs cores on your machine.

**

** If the problem persists then there's not enough memory for this model and application.

*/

/* Includes ---------------------------------------------------------------- */

#include <XIAO-ESP32S3-KWS_inferencing.h>

#include <ESP_I2S.h>

I2SClass I2S;

#define SAMPLE_RATE 16000U

#define SAMPLE_BITS 16

#define LED_BUILT_IN 21

/** Audio buffers, pointers and selectors */

typedef struct {

int16_t *buffer;

uint8_t buf_ready;

uint32_t buf_count;

uint32_t n_samples;

} inference_t;

static inference_t inference;

static const uint32_t sample_buffer_size = 2048;

static signed short sampleBuffer[sample_buffer_size];

static bool debug_nn = false; // Set this to true to see e.g. features generated from the raw signal

static bool record_status = true;

/**

* @brief Arduino setup function

*/

void setup()

{

// put your setup code here, to run once:

Serial.begin(115200);

// comment out the below line to cancel the wait for USB connection (needed for native USB)

while (!Serial);

Serial.println("Edge Impulse Inferencing Demo");

pinMode(LED_BUILT_IN, OUTPUT); // Set the pin as output

digitalWrite(LED_BUILT_IN, HIGH); //Turn off

// setup 42 PDM clock and 41 PDM data pins

I2S.setPinsPdmRx(42, 41);

if (!I2S.begin(I2S_MODE_PDM_RX, 16000, I2S_DATA_BIT_WIDTH_16BIT, I2S_SLOT_MODE_MONO)) {

Serial.println("Failed to initialize I2S!");

while (1) ;

}

// summary of inferencing settings (from model_metadata.h)

ei_printf("Inferencing settings:\n");

ei_printf("\tInterval: ");

ei_printf_float((float)EI_CLASSIFIER_INTERVAL_MS);

ei_printf(" ms.\n");

ei_printf("\tFrame size: %d\n", EI_CLASSIFIER_DSP_INPUT_FRAME_SIZE);

ei_printf("\tSample length: %d ms.\n", EI_CLASSIFIER_RAW_SAMPLE_COUNT / 16);

ei_printf("\tNo. of classes: %d\n", sizeof(ei_classifier_inferencing_categories) / sizeof(ei_classifier_inferencing_categories[0]));

ei_printf("\nStarting continious inference in 2 seconds...\n");

ei_sleep(2000);

if (microphone_inference_start(EI_CLASSIFIER_RAW_SAMPLE_COUNT) == false) {

ei_printf("ERR: Could not allocate audio buffer (size %d), this could be due to the window length of your model\r\n", EI_CLASSIFIER_RAW_SAMPLE_COUNT);

return;

}

ei_printf("Recording...\n");

}

/**

* @brief Arduino main function. Runs the inferencing loop.

*/

void loop()

{

bool m = microphone_inference_record();

if (!m) {

ei_printf("ERR: Failed to record audio...\n");

return;

}

signal_t signal;

signal.total_length = EI_CLASSIFIER_RAW_SAMPLE_COUNT;

signal.get_data = µphone_audio_signal_get_data;

ei_impulse_result_t result = { 0 };

EI_IMPULSE_ERROR r = run_classifier(&signal, &result, debug_nn);

if (r != EI_IMPULSE_OK) {

ei_printf("ERR: Failed to run classifier (%d)\n", r);

return;

}

int pred_index = 0; // Initialize pred_index

float pred_value = 0; // Initialize pred_value

// print the predictions

ei_printf("Predictions ");

ei_printf("(DSP: %d ms., Classification: %d ms., Anomaly: %d ms.)",

result.timing.dsp, result.timing.classification, result.timing.anomaly);

ei_printf(": \n");

for (size_t ix = 0; ix < EI_CLASSIFIER_LABEL_COUNT; ix++) {

ei_printf(" %s: ", result.classification[ix].label);

ei_printf_float(result.classification[ix].value);

ei_printf("\n");

if (result.classification[ix].value > pred_value){

pred_index = ix;

pred_value = result.classification[ix].value;

}

}

// Display inference result

if (pred_index == 3){

digitalWrite(LED_BUILT_IN, LOW); //Turn on

}

else{

digitalWrite(LED_BUILT_IN, HIGH); //Turn off

}

#if EI_CLASSIFIER_HAS_ANOMALY == 1

ei_printf(" anomaly score: ");

ei_printf_float(result.anomaly);

ei_printf("\n");

#endif

}

static void audio_inference_callback(uint32_t n_bytes)

{

for(int i = 0; i < n_bytes>>1; i++) {

inference.buffer[inference.buf_count++] = sampleBuffer[i];

if(inference.buf_count >= inference.n_samples) {

inference.buf_count = 0;

inference.buf_ready = 1;

}

}

}

static void capture_samples(void* arg) {

const int32_t i2s_bytes_to_read = (uint32_t)arg;

size_t bytes_read = i2s_bytes_to_read;

while (record_status) {

/* read data at once from i2s - Modified for XIAO ESP2S3 Sense and I2S.h library */

// i2s_read((i2s_port_t)1, (void*)sampleBuffer, i2s_bytes_to_read, &bytes_read, 100);

esp_i2s::i2s_read(esp_i2s::I2S_NUM_0, (void*)sampleBuffer, i2s_bytes_to_read, &bytes_read, 100);

if (bytes_read <= 0) {

ei_printf("Error in I2S read : %d", bytes_read);

}

else {

if (bytes_read < i2s_bytes_to_read) {

ei_printf("Partial I2S read");

}

// scale the data (otherwise the sound is too quiet)

for (int x = 0; x < i2s_bytes_to_read/2; x++) {

sampleBuffer[x] = (int16_t)(sampleBuffer[x]) * 8;

}

if (record_status) {

audio_inference_callback(i2s_bytes_to_read);

}

else {

break;

}

}

}

vTaskDelete(NULL);

}

/**

* @brief Init inferencing struct and setup/start PDM

*

* @param[in] n_samples The n samples

*

* @return { description_of_the_return_value }

*/

static bool microphone_inference_start(uint32_t n_samples)

{

inference.buffer = (int16_t *)malloc(n_samples * sizeof(int16_t));

if(inference.buffer == NULL) {

return false;

}

inference.buf_count = 0;

inference.n_samples = n_samples;

inference.buf_ready = 0;

// if (i2s_init(EI_CLASSIFIER_FREQUENCY)) {

// ei_printf("Failed to start I2S!");

// }

ei_sleep(100);

record_status = true;

xTaskCreate(capture_samples, "CaptureSamples", 1024 * 32, (void*)sample_buffer_size, 10, NULL);

return true;

}

/**

* @brief Wait on new data

*

* @return True when finished

*/

static bool microphone_inference_record(void)

{

bool ret = true;

while (inference.buf_ready == 0) {

delay(10);

}

inference.buf_ready = 0;

return ret;

}

/**

* Get raw audio signal data

*/

static int microphone_audio_signal_get_data(size_t offset, size_t length, float *out_ptr)

{

numpy::int16_to_float(&inference.buffer[offset], out_ptr, length);

return 0;

}

/**

* @brief Stop PDM and release buffers

*/

static void microphone_inference_end(void)

{

free(sampleBuffer);

ei_free(inference.buffer);

}

#if !defined(EI_CLASSIFIER_SENSOR) || EI_CLASSIFIER_SENSOR != EI_CLASSIFIER_SENSOR_MICROPHONE

#error "Invalid model for current sensor."

#endif

アイデアは、キーワード HELLO が検出されるたびにLEDがONになるというものです。同様に、LEDを点灯させる代わりに、導入部で見たように、これは外部デバイスの「トリガー」になることもできます。

特別な謝辞

XIAO ESP32S3 SenseのEdge Impulseへのアクセスに関するチュートリアル内容について、MJRoBot (Marcelo Rovai) に特別な感謝を申し上げます。元の記事は非常に詳細で、機械学習に関する多くの知識が含まれています。

この記事の元の内容を読みたい場合は、下にスクロールして元の記事に直接アクセスできます。

MJRoBotはXIAO ESP32S3に関する非常に多くの興味深いプロジェクトも持っています。

リソース

- [GITHUB] Project Github

- [EDGE-IMPULSE] edge impulse demo

技術サポート & 製品ディスカッション

私たちの製品をお選びいただき、ありがとうございます!私たちは、お客様の製品体験が可能な限りスムーズになるよう、さまざまなサポートを提供しています。異なる好みやニーズに対応するため、複数のコミュニケーションチャンネルを提供しています。